1. Introducción a las Series de Tiempo#

En esta sección se presentan algunos métodos estadísticos básicos, los cuales son esenciales para modelar, analizar y predecir datos de series temporales. Se presentan gráficos y resúmenes numéricos de las propiedades de los datos de series temporales. También se analiza el uso de transformaciones y ajustes de datos en la predicción y algunos métodos ampliamente utilizados para caracterizar y controlar el rendimiento de un modelo predictivo.

Algunos aspectos de como las medidas de rendimiento pueden usarse para seleccionar entre técnicas de predicción son presentados. Las predicciones se basan en datos u observaciones sobre la variable de interés. Estos datos suelen adoptar la forma de una serie temporal.

1.1. Diferentes tipos de datos#

Los analistas de negocio y científicos de datos se encuentran con diferentes tipos de datos en sus proyectos de análisis. La mayoría de los datos que se suelen encontrar en proyectos académicos e industriales se pueden clasificar a grandes rasgos en las siguientes categorías:

Datos transversalesDatos de series temporalesDatos de panel

Comprender qué tipo de datos se necesitan para resolver un problema y qué tipo de datos pueden obtenerse de las fuentes disponibles es importante para formular el problema y elegir el tipo de modelo más adecuado.

1.2. Datos transversales#

Los datos transversales o de corte transversal de una población se obtienen tomando observaciones de múltiples individuos en el mismo momento. Los datos transversales pueden incluir observaciones tomadas en distintos momentos, pero en estos casos el tiempo no desempeña ningún papel significativo en el análisis. Los resultados de la selectividad de los estudiantes es un ejemplo de datos transversales. El producto interno bruto de los países y los datos para el análisis de pérdida de clientes es otro ejemplo de datos transversales.

Observación

En esencia, los datos transversales representan un instante o momento dado. Sin embargo, los datos de clientes para el análisis de rotación pueden obtenerse a lo largo de un periodo de tiempo, como años y meses. Pero, a efectos de análisis, el tiempo puede no desempeñar un papel importante y, por lo tanto, aunque los datos de rotación de clientes pueden obtenerse de múltiples puntos en el tiempo, pueden seguir considerándose como un conjunto de datos transversal.

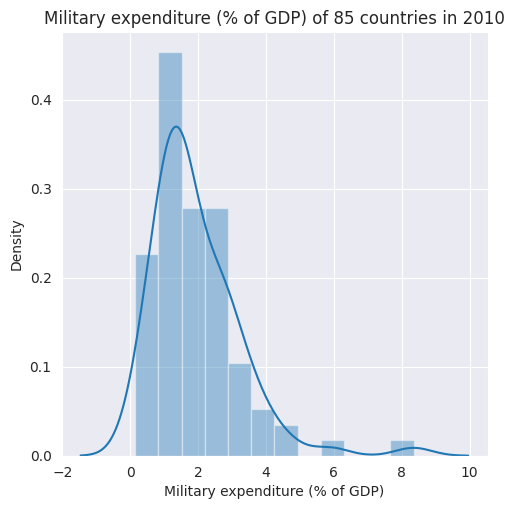

A menudo, el análisis de datos transversales comienza con un gráfico de las variables, para visualizar sus propiedades estadísticas como la tendencia central, la dispersión, la asimetría y la curtosis. En el siguiente ejemplo univariado se muestra el

Gasto militar como porcentaje del Producto Interno Brutode 85 países en el año 2010. Los datos usados en el presente curso se encuentran en el repositorio Dataset for TSF.Al tomar los datos de un solo año aseguramos su naturaleza transversal. La figura combina un histograma normalizado y un gráfico de densidad de kernel para resaltar las diferentes propiedades estadísticas de los datos de gasto militar. Utilizaremos

seabornen este caso para realizar las visualizaciones. Para temas diferentes al seleccionado (ver seaborn templates). Para descargar todos los datos que serán utilizados en este curso (ver Dataset for TSF)

import warnings

warnings.filterwarnings("ignore")

import pandas as pd

import numpy as np

from matplotlib import pyplot as plt

import seaborn as sns

sns.set_style("darkgrid")

data = pd.read_csv('/home/lihkir/Data/WDIData.csv')

print('Column names:', data.columns)

Column names: Index(['Country Name', 'Country Code', 'Indicator Name', 'Indicator Code',

'1960', '1961', '1962', '1963', '1964', '1965', '1966', '1967', '1968',

'1969', '1970', '1971', '1972', '1973', '1974', '1975', '1976', '1977',

'1978', '1979', '1980', '1981', '1982', '1983', '1984', '1985', '1986',

'1987', '1988', '1989', '1990', '1991', '1992', '1993', '1994', '1995',

'1996', '1997', '1998', '1999', '2000', '2001', '2002', '2003', '2004',

'2005', '2006', '2007', '2008', '2009', '2010', '2011', '2012', '2013',

'2014', '2015', '2016', 'Unnamed: 61'],

dtype='object')

También podemos hacernos una idea del tamaño de los datos en número de filas y columnas ejecutando la siguiente línea

print('No. of rows, columns:', data.shape)

No. of rows, columns: (401016, 62)

Este conjunto de datos tiene, 401016 filas porque recoge indicadores de desarrollo mundial para cada país. Esta información sobre el número único de indicadores y países puede obtenerse ejecutando las líneas siguientes

nb_countries = data['Country Code'].unique().shape[0]

print('Unique number of countries:', nb_countries)

Unique number of countries: 264

Como se desprende de la estructura de los datos, cada fila ofrece las observaciones sobre un indicador, que se identifica mediante las columnas

Indicator NameyIndicator Code, y sobre el país, que se indica mediante las columnasCountry NameyCountry Code.

data.dtypes

Country Name object

Country Code object

Indicator Name object

Indicator Code object

1960 float64

...

2013 float64

2014 float64

2015 float64

2016 float64

Unnamed: 61 float64

Length: 62, dtype: object

Las columnas de 1960 a 2016 tienen los valores de un indicador durante el mismo periodo de tiempo. En esta comprensión de cómo se disponen los datos en el

DataFrame, ahora estamos preparados para extraer las filas y columnas que son relevantes para nuestra visualización.Comencemos preparando otros dos

DataFrameque obtengan las filas correspondientes a los indicadoresTotal Central Government Debt (as % of GDP)yMilitary expenditure (% of GDP)para todos los países. Esto se hace por medio delDataFrameoriginal de la siguiente manera

central_govt_debt = data.loc[data['Indicator Name']=='Central government debt, total (% of GDP)']

military_exp = data.loc[data['Indicator Name']=='Military expenditure (% of GDP)']

Las dos líneas anteriores crean dos nuevos

DataFrame, a saber,central_govt_debtymilitar_exp. Una comprobación rápida de la forma de estosDataFramepuede hacerse ejecutando las dos líneas siguientes

print('Shape of central_govt_debt:', central_govt_debt.shape)

print('Shape of military_exp:', military_exp.shape)

Shape of central_govt_debt: (264, 62)

Shape of military_exp: (264, 62)

Estos

DataFramecontienen toda la información que necesitamos. Para trazar los datos univariantes y transversales necesitaremos la columna 2010. Antes de ejecutar el código para el trazado, comprobemos rápidamente si falta la columna 2010. Esto se hace mediante las dos líneas siguientes

central_govt_debt['2010'].describe()

count 94.000000

mean 53.048479

std 29.790674

min 0.519665

25% 28.357797

50% 49.540245

75% 75.259012

max 161.596402

Name: 2010, dtype: float64

military_exp['2010'].describe()

count 192.000000

mean 1.988556

std 1.354856

min 0.000000

25% 1.190287

50% 1.613407

75% 2.624711

max 8.565679

Name: 2010, dtype: float64

Además, queremos que la columna

Country Codesea el índice de las filas. Así que se ejecuta el siguiente par de líneas

central_govt_debt.index = central_govt_debt['Country Code']

military_exp.index = military_exp['Country Code']

A continuación, creamos dos

pandas.Seriestomando columnas 2010 no vacías decentral_govt_debtymilitary_exp. Los objetosSeriesrecién creados se unifican para formar un únicoDataFrame

central_govt_debt_2010 = central_govt_debt['2010'].loc[~pd.isnull(central_govt_debt['2010'])]

military_exp_2010 = military_exp['2010'].loc[~pd.isnull(military_exp['2010'])]

central_govt_debt_2010

Country Code

CEB 47.446156

EMU 72.414709

ECS 63.137736

ECA 22.338687

TEC 27.287492

...

UGA 27.552595

UKR 29.969556

GBR 83.406797

USA 85.601594

URY 44.222702

Name: 2010, Length: 94, dtype: float64

military_exp_2010

Country Code

ARB 5.117807

CEB 1.482543

EAR 2.335511

EAS 1.563325

EAP 1.724963

...

VEN 0.853924

VNM 2.305049

YEM 4.685557

ZMB 1.382593

ZWE 0.977841

Name: 2010, Length: 192, dtype: float64

data_to_plot = pd.concat((central_govt_debt_2010, military_exp_2010), axis=1)

data_to_plot.columns = ['central_govt_debt', 'military_exp']

data_to_plot.head()

| central_govt_debt | military_exp | |

|---|---|---|

| Country Code | ||

| CEB | 47.446156 | 1.482543 |

| EMU | 72.414709 | 1.618759 |

| ECS | 63.137736 | 1.860343 |

| ECA | 22.338687 | 2.933044 |

| TEC | 27.287492 | 2.785617 |

data_to_plot.shape

(202, 2)

Podemos visualizar, por ejemplo, el top 10 de países con mayor

Central government debt, total (% of GDP). Nótese que la cantidad real invertida, va a depender de que tan grande es ese porcentajeGDP, y está fijada de manera transversal al año 2010.

df_ordenado = data_to_plot.sort_values(by='military_exp', ascending=False)

df_ordenado.head(10)

| central_govt_debt | military_exp | |

|---|---|---|

| Country Code | ||

| SAU | NaN | 8.565679 |

| OMN | 5.039094 | 8.347635 |

| ISR | NaN | 6.228475 |

| ARE | NaN | 6.038592 |

| JOR | 61.373457 | 5.895421 |

| TCD | NaN | 5.778139 |

| ARB | NaN | 5.117807 |

| MEA | NaN | 4.804054 |

| YEM | NaN | 4.685557 |

| USA | 85.601594 | 4.665615 |

Para graficar, tenemos que tomar solo aquellos países que tienen las columnas

central_govt_debtymilitary_expdiferentes de cero. Ejecute la línea siguiente para filtrar las filas con valores omitidos

data_to_plot = data_to_plot.loc[(~pd.isnull(data_to_plot.central_govt_debt)) & (~pd.isnull(data_to_plot.military_exp)), :]

data_to_plot.head()

| central_govt_debt | military_exp | |

|---|---|---|

| Country Code | ||

| CEB | 47.446156 | 1.482543 |

| EMU | 72.414709 | 1.618759 |

| ECS | 63.137736 | 1.860343 |

| ECA | 22.338687 | 2.933044 |

| TEC | 27.287492 | 2.785617 |

data_to_plot.shape

(84, 2)

La tabla anterior solo tiene valores no vacíos y ya estamos listos para generar los gráficos para los datos transversales. Las siguientes líneas de código generan el gráfico de los datos univariantes transversales sobre el gasto militar

Podemos visualizar, por ejemplo, el top 10 de países con mayor

Central government debt, total (% of GDP). Nótese que la cantidad real invertida, va a depender de que tan grande es ese porcentajeGDP, y está fijada de manera transversal al año 2010.

df_ordenado = data_to_plot.sort_values(by='military_exp', ascending=False)

df_ordenado.head(10)

| central_govt_debt | military_exp | |

|---|---|---|

| Country Code | ||

| OMN | 5.039094 | 8.347635 |

| JOR | 61.373457 | 5.895421 |

| USA | 85.601594 | 4.665615 |

| NAC | 82.576224 | 4.328041 |

| GEO | 36.799720 | 3.902453 |

| RUS | 9.098114 | 3.850719 |

| COL | 72.337793 | 3.631149 |

| NAM | 16.944972 | 3.514744 |

| SGP | 102.903421 | 3.429849 |

| MAR | 50.962499 | 3.390796 |

Podemos visualizar, por ejemplo, el top 10 de países con mayor

Central government debt, total (% of GDP). Nótese que la cantidad real invertida, va a depender de que tan grande es ese porcentajeGDP, y está fijada de manera transversal al año 2010.

df_ordenado = data_to_plot.sort_values(by='military_exp', ascending=False)

df_ordenado.head(10)

| central_govt_debt | military_exp | |

|---|---|---|

| Country Code | ||

| OMN | 5.039094 | 8.347635 |

| JOR | 61.373457 | 5.895421 |

| USA | 85.601594 | 4.665615 |

| NAC | 82.576224 | 4.328041 |

| GEO | 36.799720 | 3.902453 |

| RUS | 9.098114 | 3.850719 |

| COL | 72.337793 | 3.631149 |

| NAM | 16.944972 | 3.514744 |

| SGP | 102.903421 | 3.429849 |

| MAR | 50.962499 | 3.390796 |

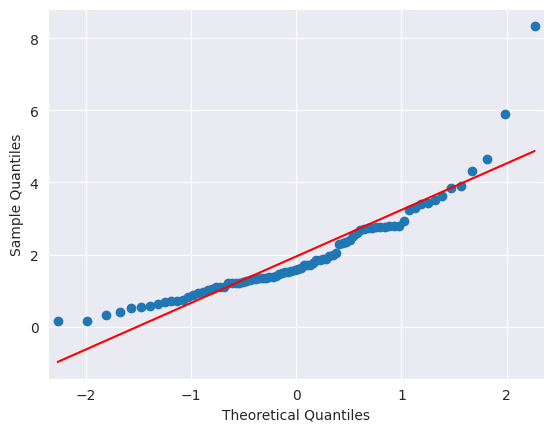

Realizamos algunos

tests de normalidadpor ejemplo paramilitary expenditure

military_exp_np = np.array(data_to_plot.military_exp)

plt.figure(figsize=(5.5, 5.5))

g = sns.distplot(military_exp_np, norm_hist=False)

g.set_title('Military expenditure (% of GDP) of 85 countries in 2010');

plt.xlabel("Military expenditure (% of GDP)");

from statsmodels.graphics.gofplots import qqplot

qqplot(military_exp_np, line='s');

Prueba de Shapiro-Wilk y Kolmogorov-Smirnov

La prueba de

Shapiro-Wilkevalúa una muestra de datos y cuantifica la probabilidad de que los datos procedan de una distribución gaussiana, en honor aSamuel ShapiroyMartin Wilk. En la práctica, se cree que la prueba deShapiro-Wilkes una prueba fiable de normalidad, aunque hay algunos indicios de que la prueba puede ser adecuada para muestras de datos más pequeñas (\(n < 50\) idealmente), por ejemplo, miles de observaciones o menos.El test de

Kolmogorov-Smirnov (KS)es menos afectado por el tamaño muestral en comparación con el test de Shapiro-Wilk. Por lo tanto, puede ser más apropiado para muestras grandes, donde el test de Shapiro-Wilk tiende a volverse más conservador. El test de KS es más general y no se limita únicamente a la normalidad. Puede utilizarse para comparar cualquier distribución empírica con una distribución teórica.La función

shapiro() SciPycalcula la prueba deShapiro-Wilk(ver Shapiro-Wilk test) en un conjunto de datos determinado. La función devuelve tanto el estadístico \(W\) calculado por la prueba como el \(p\)-value. A continuación se muestra el ejemplo completo de realización de la prueba deShapiro-Wilken el conjunto de datos.

from scipy.stats import shapiro

print('Shapiro-Wilk Test:')

stat, p = shapiro(military_exp_np)

print('Statistics=%.6f, p=%e' % (stat, p))

alpha = 0.05

if p > alpha:

print('Sample looks Normal (fail to reject H0)')

else:

print('Sample does not look Normal (reject H0)')

Shapiro-Wilk Test:

Statistics=0.857023, p=1.646573e-07

Sample does not look Normal (reject H0)

import numpy as np

from scipy import stats

print('Kolmogorov-Smirnov:')

stat, p = stats.kstest(military_exp_np, stats.norm.cdf)

print('Statistics=%.6f, p=%e' % (stat, p))

alpha = 0.05

if p > alpha:

print('Sample looks Normal (fail to reject H0)')

else:

print('Sample does not look Normal (reject H0)')

Kolmogorov-Smirnov:

Statistics=0.659326, p=2.320049e-36

Sample does not look Normal (reject H0)

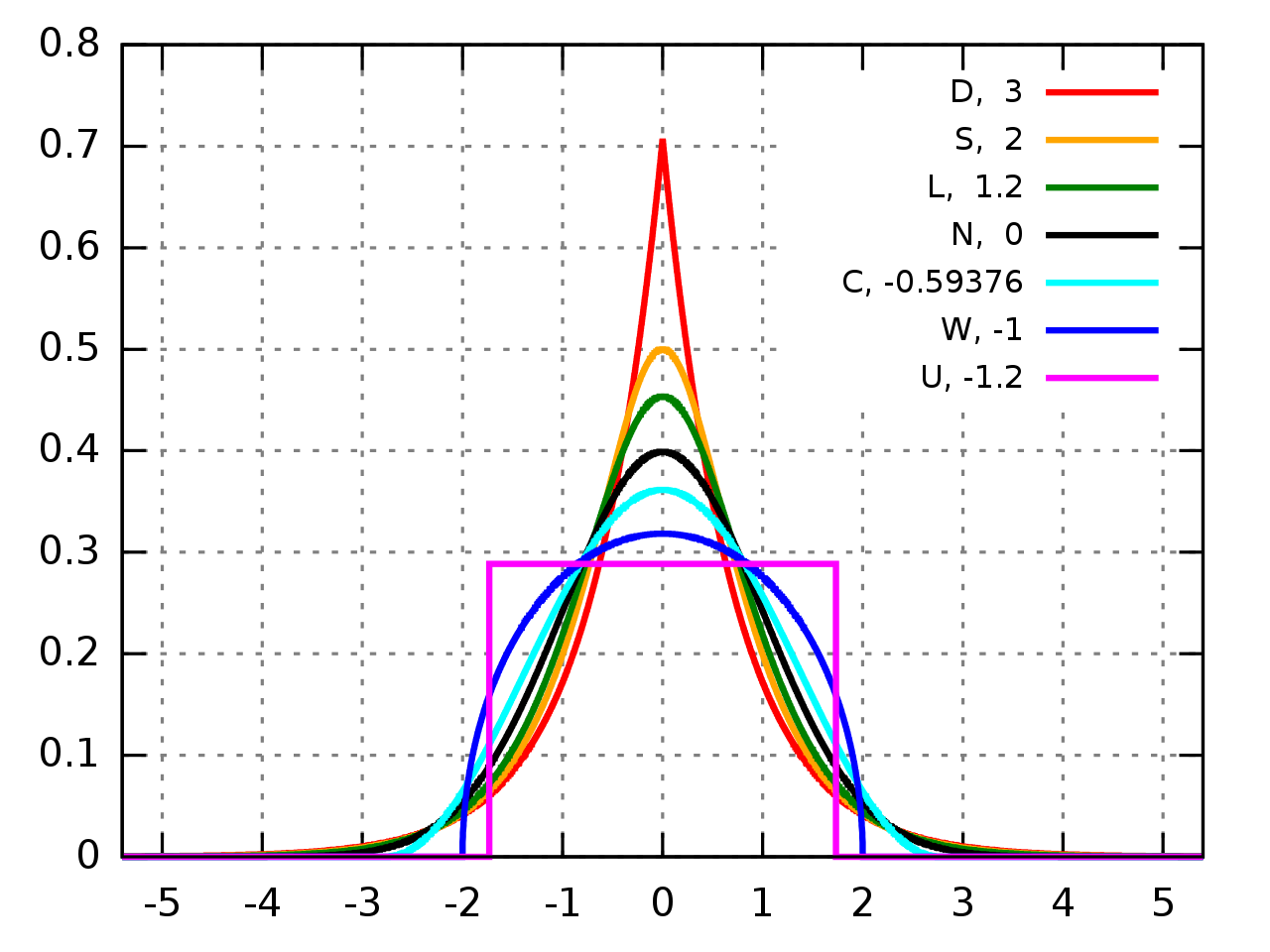

Prueba \(K^2\) de D'Agostino

La prueba \(K^2\) de D’Agostino calcula los estadísticos de resumen de los datos, es decir, la curtosis y la asimetría, para determinar si la distribución de los datos se aparta de la distribución normal, llamada así por

Ralph D'Agostino. La asimetría (skew) es una cuantificación del grado en que una distribución se desplaza hacia la izquierda o hacia la derecha, es una medida de la asimetría de la distribución.La curtosis (

kurtosis) cuantifica la proporción de la distribución que se encuentra en cierta cola lateral (ver Fig. 1.1). Es una prueba estadística de normalidad sencilla y de uso común. La prueba \(K^2\) de D’Agostino está disponible a través de la funciónSciPy normaltest()y devuelve el estadístico de la prueba y el \(p\)-value

Fig. 1.1 Diferentes distribuciones asociadas a multiples valores de kurtosis. Fuente wikipedia.#

D:

Distribución de Laplace(kurtosis = 3);S:

Distribución hiperbólica secante, (kurtosis = 2);L:

Distribución logística, (kurtosis = 1.2);N:

Distribución normal, (kurtosis = 0);C:

Distribución del coseno elevado, (kurtosis = -0,593762);W:

Distribución del semicírculo de Wigner, (kurtosis = -1);U:

Distribución uniforme, (kurtosis = -1.2).

from scipy.stats import normaltest, kurtosis, skew

stat, p = normaltest(military_exp_np)

print('Statistics=%.3f, p=%.3f' % (stat, p))

alpha = 0.05

if p > alpha:

print('Sample looks Gaussian (fail to reject H0)')

else:

print('Sample does not look Gaussian (reject H0)')

print('Kurtosis=%.3f'%kurtosis(military_exp_np))

print('Skew=%.3f'%skew(military_exp_np))

Statistics=49.874, p=0.000

Sample does not look Gaussian (reject H0)

Kurtosis=6.122

Skew=1.916

Observación

Kurtosis mayor que 0: Indica una distribuciónleptocúrtica, lo que significa que la distribución tiene colas más pesadas y es más puntiaguda en comparación con una distribución normal. Esto implica que hay una mayor concentración de datos alrededor de la media, con valores extremos más frecuentes.Kurtosis menor que 0: Indica una distribuciónplaticúrtica, lo que significa que la distribución es más aplanada y tiene colas más ligeras en comparación con una distribución normal. Esto implica que los datos están más dispersos y hay menos valores en la región de la media, con valores extremos menos frecuentes.

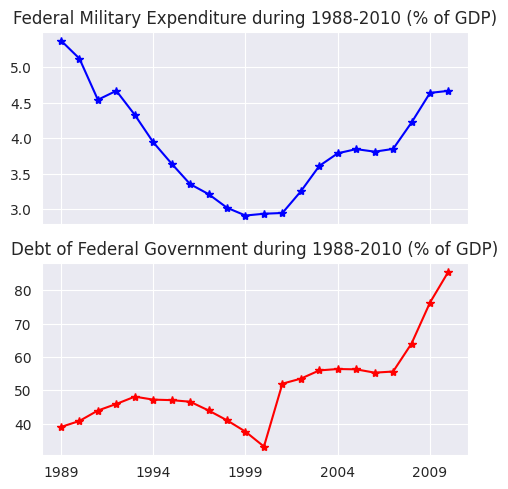

1.3. Datos de series temporales#

Introducción

El ejemplo de datos transversales comentado anteriormente corresponde únicamente al año 2010. Sin embargo, en cambio, si consideramos un solo país, por ejemplo Estados Unidos (

USA), y echamos un vistazo a susFederal Military Expenditure,Debt of Federal Government, durante un periodo de 10 años, de 2001 a 2010, obtendríamos dos series temporales:Federal Military ExpenditureDebt of Federal Government

Por lo tanto, en esencia, una serie temporal se compone de observaciones cuantitativas sobre una o más características medibles de una entidad individual y tomadas en múltiples puntos en el tiempo. En este caso, los datos representan

Federal Military Expenditure,Debt of Federal Government.

Los datos de series temporales suelen caracterizarse por varias estructuras internas interesantes, como la tendencia, la estacionalidad, estacionariedad, autocorrelación, etc. Las estructuras internas de los datos de series temporales requieren una formulación y técnicas especiales para su análisis. Estas técnicas se tratarán en los siguientes capítulos con estudios de casos e implementación de código de trabajo en

Python.

Para generar los gráficos anteriores usaremos el código que se desarrolló para obtener los gráficos para los datos transversales. Comenzaremos creando dos nuevas series para representar las series temporales de

Federal Military ExpenditureyDebt of Federal Government, desde 1960 hasta 2010

central_govt_debt_us = central_govt_debt.loc[central_govt_debt['Country Code']=='USA', :].T

military_exp_us = military_exp.loc[military_exp['Country Code']=='USA', :].T

Los dos objetos

Seriescreados en el código anterior se fusionan para formar un únicoDataFramey se cortan para contener los datos de los años 2001 a 2010:

data_us = pd.concat((military_exp_us, central_govt_debt_us), axis=1)

index0 = np.where(data_us.index=='1960')[0][0]

index1 = np.where(data_us.index=='2010')[0][0]

data_us = data_us.iloc[index0:index1+1,:]

data_us.columns = ['Federal Military Expenditure', 'Debt of Federal Government']

data_us.head()

| Federal Military Expenditure | Debt of Federal Government | |

|---|---|---|

| 1960 | 8.35266 | NaN |

| 1961 | 8.487129 | NaN |

| 1962 | 8.656586 | NaN |

| 1963 | 8.189007 | NaN |

| 1964 | 7.467629 | NaN |

Podemos utilizar los métodos

isna()oisnull()para contabilizar datos faltantes en los datos. Podemos obtener el total de valores perdidos en cada columna con la funciónsum()o tomar la media conmean(). Técnicas de imputación de datos faltantes pueden ser utilizadas del módulo de Visualización de Datos

data_us.isna().sum()

Federal Military Expenditure 0

Debt of Federal Government 29

dtype: int64

(data_us.isnull().sum()/len(data_us))*100

Federal Military Expenditure 0.000000

Debt of Federal Government 56.862745

dtype: float64

data_us['backward_fill'] = data_us['Debt of Federal Government'].bfill()

data_us.head()

| Federal Military Expenditure | Debt of Federal Government | backward_fill | |

|---|---|---|---|

| 1960 | 8.35266 | NaN | 39.016963 |

| 1961 | 8.487129 | NaN | 39.016963 |

| 1962 | 8.656586 | NaN | 39.016963 |

| 1963 | 8.189007 | NaN | 39.016963 |

| 1964 | 7.467629 | NaN | 39.016963 |

El método

.bfill()enPandasse utiliza para rellenar los valores faltantes (NaN) en unaSerieoDataFramehacia atrás (backward fill). Por ejemplo, si tiene una columna con valores[1, NaN, 3, NaN, 5], al aplicar.bfill(), los valores faltantes se llenarán con los valores siguientes más cercanos, dando como resultado[1, 3, 3, 5, 5].

data_us['mean_fill'] = data_us['Debt of Federal Government'].mean()

data_us.head()

| Federal Military Expenditure | Debt of Federal Government | backward_fill | mean_fill | |

|---|---|---|---|---|

| 1960 | 8.35266 | NaN | 39.016963 | 51.155537 |

| 1961 | 8.487129 | NaN | 39.016963 | 51.155537 |

| 1962 | 8.656586 | NaN | 39.016963 | 51.155537 |

| 1963 | 8.189007 | NaN | 39.016963 | 51.155537 |

| 1964 | 7.467629 | NaN | 39.016963 | 51.155537 |

data_us['median_fill'] = data_us['Debt of Federal Government'].median()

data_us.head()

| Federal Military Expenditure | Debt of Federal Government | backward_fill | mean_fill | median_fill | |

|---|---|---|---|---|---|

| 1960 | 8.35266 | NaN | 39.016963 | 51.155537 | 47.659404 |

| 1961 | 8.487129 | NaN | 39.016963 | 51.155537 | 47.659404 |

| 1962 | 8.656586 | NaN | 39.016963 | 51.155537 | 47.659404 |

| 1963 | 8.189007 | NaN | 39.016963 | 51.155537 | 47.659404 |

| 1964 | 7.467629 | NaN | 39.016963 | 51.155537 | 47.659404 |

data_us['quadratic_fill'] = data_us['Debt of Federal Government'].interpolate(option='quadratic')

data_us.head()

| Federal Military Expenditure | Debt of Federal Government | backward_fill | mean_fill | median_fill | quadratic_fill | |

|---|---|---|---|---|---|---|

| 1960 | 8.35266 | NaN | 39.016963 | 51.155537 | 47.659404 | NaN |

| 1961 | 8.487129 | NaN | 39.016963 | 51.155537 | 47.659404 | NaN |

| 1962 | 8.656586 | NaN | 39.016963 | 51.155537 | 47.659404 | NaN |

| 1963 | 8.189007 | NaN | 39.016963 | 51.155537 | 47.659404 | NaN |

| 1964 | 7.467629 | NaN | 39.016963 | 51.155537 | 47.659404 | NaN |

El método

interpolate()enPandasse utiliza para interpolar los valores faltantes en unaSerieoDataFrame. Al especificaroption='quadratic', está indicando que desea utilizar la interpolación cuadrática para llenar los valores faltantes.

Existen otras técnicas de imputación de datos, tales como por ejemplo: sklearn.impute.KNNImputer, IterativeImputer, etc.,… Nótese que la columna

quadratic_fillmantiene los valoresNaN. Esta técnica ofrece las siguientes versiones de imputación:'nearest', 'zero', 'slinear', 'quadratic', 'cubic', 'spline', 'barycentric', 'polynomial'las cuales se le invita a revisar en la documentación. Realice para cada imputación una representación de su nueva distribución e identifique si esta se vio realmente afectada.

Dado que el cuadro anterior muestra que no se dispone solamente de datos sobre

Debt of Federal Governmentde varios años a partir de 1960, y se necesitan las dos dimensiones, otra opción es eliminar las filas con datos faltantes delDataframe,data_usantes de trazar la serie temporal

data_us.dropna(inplace=True)

print('Shape of data_us:', data_us.shape)

Shape of data_us: (22, 6)

data_us.head(10)

| Federal Military Expenditure | Debt of Federal Government | backward_fill | mean_fill | median_fill | quadratic_fill | |

|---|---|---|---|---|---|---|

| 1989 | 5.374717 | 39.016963 | 39.016963 | 51.155537 | 47.659404 | 39.016963 |

| 1990 | 5.120252 | 40.821367 | 40.821367 | 51.155537 | 47.659404 | 40.821367 |

| 1991 | 4.539845 | 43.948026 | 43.948026 | 51.155537 | 47.659404 | 43.948026 |

| 1992 | 4.666265 | 45.916542 | 45.916542 | 51.155537 | 47.659404 | 45.916542 |

| 1993 | 4.326925 | 48.104749 | 48.104749 | 51.155537 | 47.659404 | 48.104749 |

| 1994 | 3.941287 | 47.21406 | 47.214060 | 51.155537 | 47.659404 | 47.21406 |

| 1995 | 3.638489 | 47.059783 | 47.059783 | 51.155537 | 47.659404 | 47.059783 |

| 1996 | 3.350744 | 46.585511 | 46.585511 | 51.155537 | 47.659404 | 46.585511 |

| 1997 | 3.209903 | 43.958801 | 43.958801 | 51.155537 | 47.659404 | 43.958801 |

| 1998 | 3.017636 | 41.009914 | 41.009914 | 51.155537 | 47.659404 | 41.009914 |

Por último, las series temporales se generan ejecutando el siguiente código

f, axarr = plt.subplots(2, sharex=True)

f.set_size_inches(5.5, 5.5)

axarr[0].set_title('Federal Military Expenditure during 1988-2010 (% of GDP)')

data_us['Federal Military Expenditure'].plot(linestyle='-', marker='*', color='b', ax=axarr[0])

axarr[1].set_title('Debt of Federal Government during 1988-2010 (% of GDP)')

data_us['Debt of Federal Government'].plot(linestyle='-', marker='*', color='r', ax=axarr[1]);

1.4. Datos de panel#

Introducción

Hemos visto datos transversales (de múltiples individuos en un solo punto en el tiempo) y series temporales (de una entidad a lo largo de múltiples puntos en el tiempo). Si observamos múltiples entidades a lo largo de múltiples puntos en el tiempo, obtenemos un panel de datos o datos longitudinales.

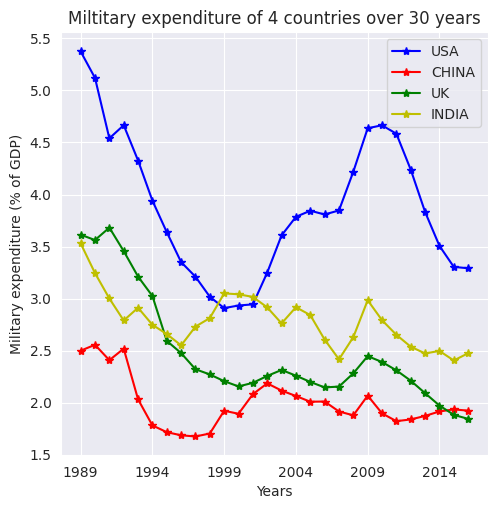

Tomando como ejemplo para cuatro países

'Military expenditure (% of GDP)'durante el periodo 1960-2010, creamos un conjunto de datos de panel. Ahora, prepararemos los datos para trazar la figura correspondiente, siguiendo un proceso similar al utilizado para los datos transversales y de series temporales en este capítulo.

Preparemos los datos necesarios para trazar la figura correspondiente. Seguiremos el código que hemos utilizado para los datos transversales y de series temporales en este capítulo. Empezaremos creando un DataFrame con los datos de las cuatro empresas mencionadas en el gráfico anterior. Esto se hace de la siguiente manera:

chn = data.loc[(data['Indicator Name']=='Military expenditure (% of GDP)') & \

(data['Country Code']=='CHN'), :] #China

chn.head()

| Country Name | Country Code | Indicator Name | Indicator Code | 1960 | 1961 | 1962 | 1963 | 1964 | 1965 | ... | 2008 | 2009 | 2010 | 2011 | 2012 | 2013 | 2014 | 2015 | 2016 | Unnamed: 61 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 134507 | China | CHN | Military expenditure (% of GDP) | MS.MIL.XPND.GD.ZS | NaN | NaN | NaN | NaN | NaN | NaN | ... | 1.878156 | 2.067426 | 1.896713 | 1.821927 | 1.838564 | 1.872334 | 1.915341 | 1.934922 | 1.922962 | NaN |

1 rows × 62 columns

chn = data.loc[(data['Indicator Name']=='Military expenditure (% of GDP)') & \

(data['Country Code']=='CHN'), :].drop(data.columns[range(3)], axis=1)

chn.head()

| Indicator Code | 1960 | 1961 | 1962 | 1963 | 1964 | 1965 | 1966 | 1967 | 1968 | ... | 2008 | 2009 | 2010 | 2011 | 2012 | 2013 | 2014 | 2015 | 2016 | Unnamed: 61 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 134507 | MS.MIL.XPND.GD.ZS | NaN | NaN | NaN | NaN | NaN | NaN | NaN | NaN | NaN | ... | 1.878156 | 2.067426 | 1.896713 | 1.821927 | 1.838564 | 1.872334 | 1.915341 | 1.934922 | 1.922962 | NaN |

1 rows × 59 columns

chn = pd.Series(data=chn.values[0], index=chn.columns)

chn.dropna(inplace=True)

chn.head()

Indicator Code MS.MIL.XPND.GD.ZS

1989 2.499185

1990 2.555996

1991 2.407892

1992 2.518629

dtype: object

usa = data.loc[(data['Indicator Name']=='Military expenditure (% of GDP)') & \

(data['Country Code']=='USA'), :].drop(data.columns[range(3)], axis=1) #USA

usa = pd.Series(data=usa.values[0], index=usa.columns)

usa.dropna(inplace=True)

usa.head()

Indicator Code MS.MIL.XPND.GD.ZS

1960 8.35266

1961 8.487129

1962 8.656586

1963 8.189007

dtype: object

ind = data.loc[(data['Indicator Name']=='Military expenditure (% of GDP)') & \

(data['Country Code']=='IND'), :].drop(data.columns[range(3)], axis=1) #India

ind = pd.Series(data=ind.values[0], index=ind.columns)

ind.dropna(inplace=True)

ind.head()

Indicator Code MS.MIL.XPND.GD.ZS

1960 1.866015

1961 1.933365

1962 2.561202

1963 3.758057

dtype: object

gbr = data.loc[(data['Indicator Name']=='Military expenditure (% of GDP)') & \

(data['Country Code']=='GBR'), :].drop(data.columns[range(3)], axis=1) #United Kingdom

gbr = pd.Series(data=gbr.values[0], index=gbr.columns)

gbr.dropna(inplace=True)

gbr.head()

Indicator Code MS.MIL.XPND.GD.ZS

1960 6.343041

1961 6.190022

1962 6.210394

1963 6.082126

dtype: object

n_years = chn.shape[0]

print("#Years: ", n_years+1)

#Years: 30

plt.figure(figsize=(5.5, 5.5))

usa[n_years+1:2*n_years].plot(linestyle='-', marker='*', color='b')

chn[1:n_years].plot(linestyle='-', marker='*', color='r')

gbr[n_years+1:2*n_years].plot(linestyle='-', marker='*', color='g')

ind[n_years+1:2*n_years].plot(linestyle='-', marker='*', color='y')

plt.legend(['USA','CHINA','UK','INDIA'], loc=1)

plt.title('Miltitary expenditure of 4 countries over 30 years')

plt.ylabel('Military expenditure (% of GDP)')

plt.xlabel('Years');

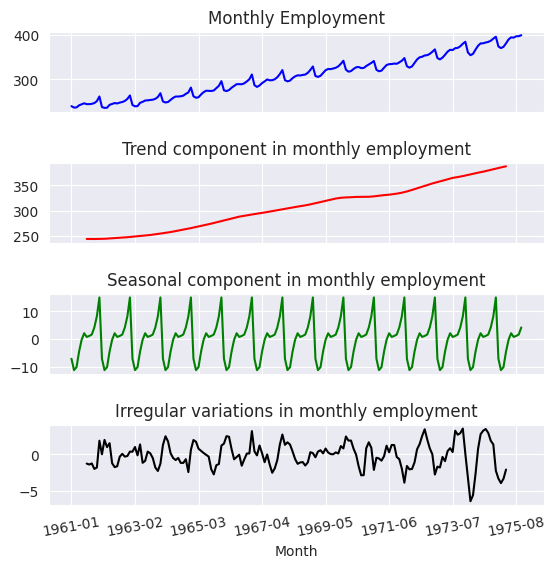

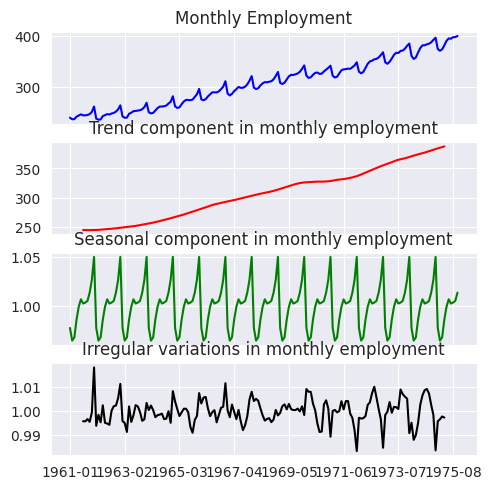

1.5. Estructuras internas de las series temporales#

En esta sección, explicaremos conceptualmente las siguientes características especiales de los datos de series temporales que requieren un tratamiento matemático especial

Tendencia generalEstacionalidadMovimientos cíclicosComponentes irregulares

Observación

La mayoría de las series temporales presentan una o varias de las estructuras internas mencionadas. Basándose en esta noción, una serie temporal puede expresarse como

\[ y_{t}=F_{t}+S_{t}+C_{t}+\varepsilon_{t}, \]que es una suma de los componentes de tendencia, componentes estacionales, cíclicas e irregulares en ese orden. Aquí, \(t\) es el índice temporal en el que observaciones sobre la serie se han tomado en \(t = 1,2,3, \dots, T\) puntos sucesivos e igualmente espaciados en el tiempo.

El objetivo del análisis de series temporales es descomponer una serie temporal en sus características constitutivas y desarrollar modelos matemáticos para ellas. Estos modelos se utilizan para comprender las causas del comportamiento observado de la serie temporal y predecirla para momentos futuros.

1.6. Tendencia general#

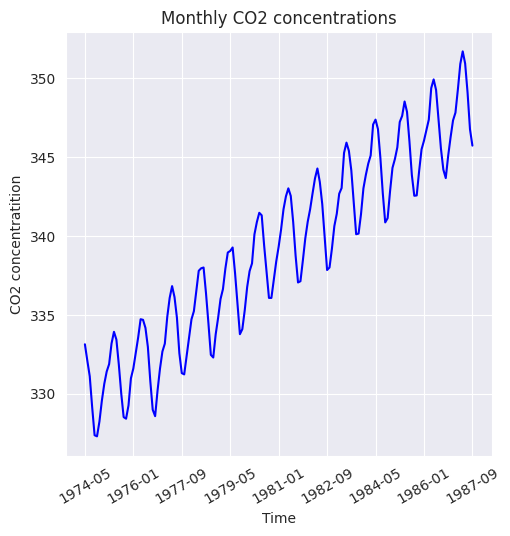

Cuando una serie temporal presenta un movimiento ascendente o descendente a largo plazo, se dice que tiene tendencia general. Una forma rápida de comprobar la presencia de una tendencia general es trazar la serie temporal como en la siguiente figura, que muestra las concentraciones de CO2 en el aire medidas durante 1974 hasta 1987

import pandas as pd

import numpy as np

from matplotlib import pyplot as plt

import seaborn as sns

data = pd.read_excel('/home/lihkir/Data/Monthly_CO2_Concentrations.xlsx', converters={'Year': np.int32, 'Month': np.int32})

data.head()

| CO2 | Year | Month | |

|---|---|---|---|

| 0 | 333.13 | 1974 | 5 |

| 1 | 332.09 | 1974 | 6 |

| 2 | 331.10 | 1974 | 7 |

| 3 | 329.14 | 1974 | 8 |

| 4 | 327.36 | 1974 | 9 |

Creamos índice de filas del

DataFrameutilizando las columnasYearyMonth

data.index = data['Year'].astype(str) + '-' + data['Month'].astype(str).map(lambda x: '0'+x if len(x) == 1 else x)

data.head()

| CO2 | Year | Month | |

|---|---|---|---|

| 1974-05 | 333.13 | 1974 | 5 |

| 1974-06 | 332.09 | 1974 | 6 |

| 1974-07 | 331.10 | 1974 | 7 |

| 1974-08 | 329.14 | 1974 | 8 |

| 1974-09 | 327.36 | 1974 | 9 |

data = data.loc[(~pd.isnull(data['CO2'])) & \

(~pd.isnull(data['Year']))& \

(~pd.isnull(data['Month']))]

data.sort_values(['Year', 'Month'], inplace=True)

plt.figure(figsize=(5.5, 5.5))

data['CO2'].plot(color='b')

plt.title('Monthly CO2 concentrations')

plt.xlabel('Time')

plt.ylabel('CO2 concentratition')

plt.xticks(rotation=30);

Nótese que,

pd.infer_freq()devuelve"MS", lo cual significa que la serie de tiempo tiene una frecuencia mensual y que cada punto de datos representa el primer día de cada mes

data.index = pd.to_datetime(data.index, format='%Y-%m')

frecuencia = pd.infer_freq(data.index)

print("Frecuencia: ", frecuencia)

Frecuencia: MS

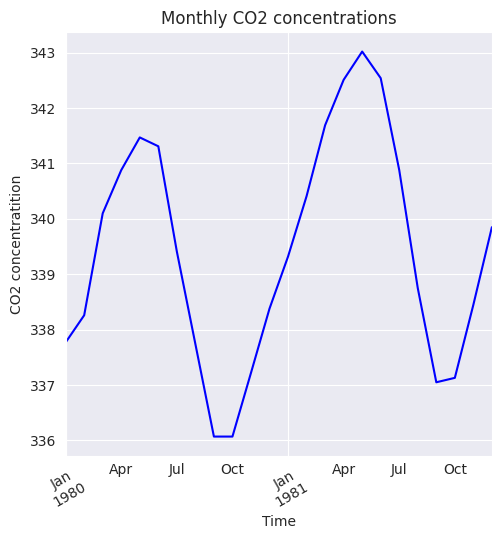

Sin embargo, la tendencia general puede no ser evidente a corto plazo. Los efectos a corto plazo como las fluctuaciones estacionales y las variaciones irregulares hacen que las series temporales vuelvan a registrar valores más bajos o más altos observados en el pasado, por lo que pueden ocultar temporalmente cualquier tendencia general.

Esto es evidente en la misma serie temporal de concentraciones de CO2 cuando se considera de 1979 a 1981, como se muestra en la siguiente figura. Por tanto, para revelar la tendencia general, necesitamos una serie temporal que se remonte sustancialmente al pasado.

plt.figure(figsize=(5.5, 5.5))

data['CO2'].loc[(data['Year']==1980) | (data['Year']==1981)].plot(color='b')

plt.title('Monthly CO2 concentrations')

plt.xlabel('Time')

plt.ylabel('CO2 concentratition')

plt.xticks(rotation=30);

Observación

La tendencia general de la serie temporal se debe a cambios fundamentales o sistémicos del proceso o sistema que representa. Por ejemplo, el movimiento ascendente de las concentraciones de CO2 entre 1974 y 1987 puede atribuirse al aumento gradual de los automóviles y la industrialización durante esos años.

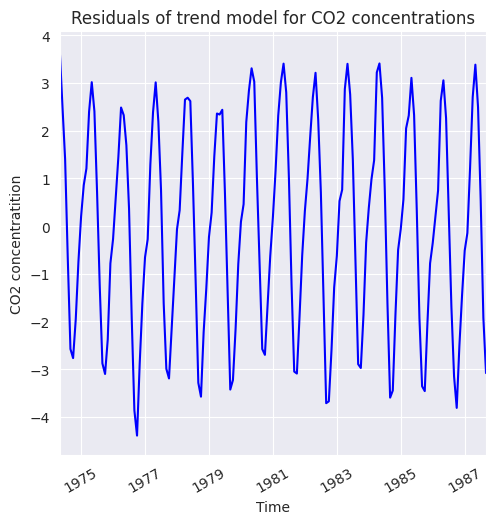

La tendencia de una serie temporal se modela comúnmente mediante una regresión respecto al tiempo y otras variables conocidas como explicativas. Esta regresión se usa para predecir el movimiento a largo plazo de la serie. Los residuos de esta regresión revelan otras características como la estacionalidad, ciclos y variaciones irregulares.

A continuación, vamos a ajustar la línea de tendencia. Para ello importamos la clase

LinearRegressiondescikit-learny ajustamos un modelo lineal al índice temporal. Para instalar la librería, utilice la orden

pip install -U sklearn-learn

from sklearn.linear_model import LinearRegression

import numpy as np

trend_model = LinearRegression(fit_intercept=True)

trend_model.fit(np.arange(data.shape[0]).reshape((-1,1)), data['CO2'])

LinearRegression()In a Jupyter environment, please rerun this cell to show the HTML representation or trust the notebook.

On GitHub, the HTML representation is unable to render, please try loading this page with nbviewer.org.

LinearRegression()

print('Trend model coefficient={} and intercept={}'.format(trend_model.coef_[0], trend_model.intercept_))

Trend model coefficient=0.1209930124223602 and intercept=329.45310559006214

El residual obtenido a partir del modelo de línea de tendencia se muestra en la siguiente figura, el cual presenta un comportamiento estacional, el cual se analizará en la siguiente sección. Los residuos se calculan y se representan mediante la siguiente línea de código

residuals = np.array(data['CO2']) - trend_model.predict(np.arange(data.shape[0]).reshape((-1,1)))

plt.figure(figsize=(5.5, 5.5))

pd.Series(data=residuals, index=data.index).plot(color='b')

plt.title('Residuals of trend model for CO2 concentrations')

plt.xlabel('Time')

plt.ylabel('CO2 concentratition')

plt.xticks(rotation=30);

1.7. Estacionalidad#

Introducción

La estacionalidad muestra variaciones repetitivas y periódicas en una serie temporal, comúnmente reveladas durante el análisis exploratorio de datos. Por ejemplo, las fluctuaciones mensuales en las emisiones de CO2 o en las ventas de productos estacionales como los regalos navideños evidencian esta estacionalidad.

Una técnica práctica para determinar la estacionalidad es el análisis exploratorio de datos mediante los siguientes gráficos:

Gráfico de secuencia de series

Gráfico de subseries estacionales

Gráficos de cajas múltiples

1.8. Gráfico de secuencia de series#

Un simple gráfico de secuencia de ejecución de la serie temporal original con el tiempo en el eje \(x\) y la variable en el eje \(y\) sirve para indicar las siguientes propiedades de la serie temporal:

Movimientos en la media de la serie

Cambios en la varianza

Presencia de valores atípicos

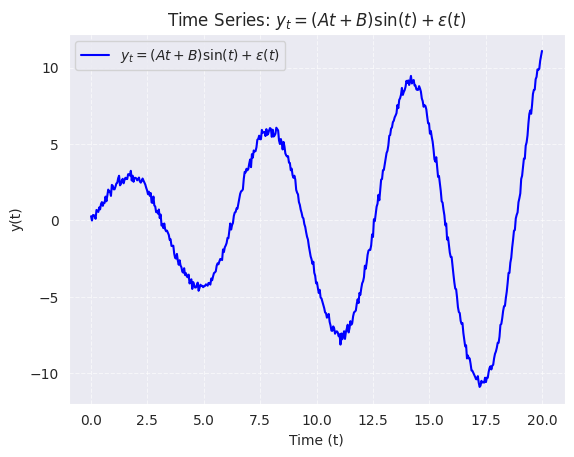

Por ejemplo, el gráfico de la secuencia de ejecución de una serie temporal hipotética que se obtiene a partir de la formulación matemática

\[ y_{t} = (At + B)\sin(t) + \varepsilon(t) \]con una media dependiente del tiempo y error \(\varepsilon(t)\) que varía como una distribución normal \(N(0, At + b)\).

En casos como este, un gráfico de secuencia de ejecución es una forma eficaz de identificar el desplazamiento de la media y la varianza de la serie, así como los valores atípicos. El gráfico de la serie temporal sin tendencia es un ejemplo de gráfico de secuencia.

import numpy as np

import matplotlib.pyplot as plt

A = 0.5

B = 2.0

t = np.linspace(0, 20, 500)

epsilon = np.random.normal(0, 0.2, len(t))

y_t = (A * t + B) * np.sin(t) + epsilon

plt.figure()

plt.plot(t, y_t, label=r'$y_{t} = (At + B)\sin(t) + \varepsilon(t)$', color='blue')

plt.title("Time Series: $y_{t} = (At + B)\\sin(t) + \\varepsilon(t)$")

plt.xlabel("Time (t)")

plt.ylabel("y(t)")

plt.grid(True, linestyle='--', alpha=0.6)

plt.legend()

plt.show()

1.9. Gráfico de subserie estacional#

Subseries estacionales

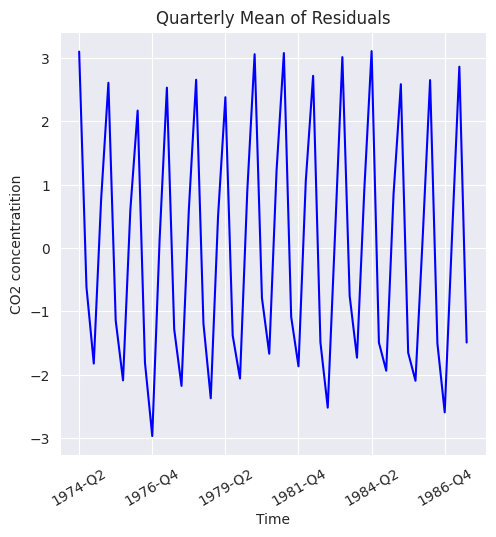

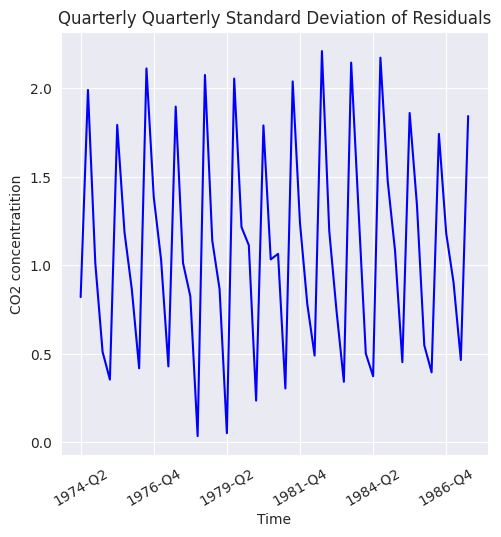

Para una periodicidad conocida de variaciones estacionales, las subseries estacionales vuelven a dibujar la serie original en lotes de períodos sucesivos. Por ejemplo, la periodicidad de las concentraciones de CO2 es de 12 meses y, basándose en ella, se traza una subserie estacional de la media y la desviación estándar de los residuos.

Para visualizar estacionalidad en los residuos, creamos medias y desviaciones estándar trimestrales. Una subserie estacional revela dos propiedades:

Variaciones dentro de las estaciones como dentro de un lote de meses sucesivos.

Variaciones entre las estaciones como entre lotes de meses sucesivos

En primer lugar, tenemos que añadir los residuos y las etiquetas trimestrales al DataFrame de concentraciones de CO2 de la siguiente forma

data.head()

| CO2 | Year | Month | |

|---|---|---|---|

| 1974-05-01 | 333.13 | 1974 | 5 |

| 1974-06-01 | 332.09 | 1974 | 6 |

| 1974-07-01 | 331.10 | 1974 | 7 |

| 1974-08-01 | 329.14 | 1974 | 8 |

| 1974-09-01 | 327.36 | 1974 | 9 |

data['Residuals'] = residuals

month_quarter_map = {1: 'Q1', 2: 'Q1', 3: 'Q1',

4: 'Q2', 5: 'Q2', 6: 'Q2',

7: 'Q3', 8: 'Q3', 9: 'Q3',

10: 'Q4', 11: 'Q4', 12: 'Q4'}

data['Quarter'] = data['Month'].map(lambda m: month_quarter_map.get(m))

A continuación, se calculan la media estacional y las desviaciones típicas, agrupando los datos por

YearyQuarter. Esto crea el nuevoDataFramecomoseasonal_sub_series_data, que tiene la media trimestral y las desviaciones estándar a lo largo de los años. Estas columnas se renombran como sigue:

seasonal_sub_series_data = data.groupby(by=['Year', 'Quarter'])['Residuals'].aggregate([np.mean, np.std])

seasonal_sub_series_data.columns = ['Quarterly Mean', 'Quarterly Standard Deviation']

Creamos índices de filas de

seasonal_sub_series_datautilizandoYear & Quarter

seasonal_sub_series_data.reset_index(inplace=True)

seasonal_sub_series_data.index = seasonal_sub_series_data['Year'].astype(str) + '-' + seasonal_sub_series_data['Quarter']

seasonal_sub_series_data.head()

| Year | Quarter | Quarterly Mean | Quarterly Standard Deviation | |

|---|---|---|---|---|

| 1974-Q2 | 1974 | Q2 | 3.096398 | 0.820946 |

| 1974-Q3 | 1974 | Q3 | -0.616085 | 1.991671 |

| 1974-Q4 | 1974 | Q4 | -1.822397 | 1.014952 |

| 1975-Q1 | 1975 | Q1 | 0.754624 | 0.511890 |

| 1975-Q2 | 1975 | Q2 | 2.604978 | 0.355093 |

plt.figure(figsize=(5.5, 5.5))

seasonal_sub_series_data['Quarterly Mean'].plot(color='b')

plt.title('Quarterly Mean of Residuals')

plt.xlabel('Time')

plt.ylabel('CO2 concentratition')

plt.xticks(rotation=30);

plt.figure(figsize=(5.5, 5.5))

seasonal_sub_series_data['Quarterly Standard Deviation'].plot(color='b')

plt.title('Quarterly Quarterly Standard Deviation of Residuals')

plt.xlabel('Time')

plt.ylabel('CO2 concentratition')

plt.xticks(rotation=30);

Nótese que, el agrupamiento por año y trimestre (Year, Quarter) y el cálculo de la media trimestral indica que hay variaciones regulares en los datos residuales según el trimestre. Esto confirma la presencia de

patrones estacionales periódicos.La desviación estándar trimestral muestra que la magnitud de las fluctuaciones también tiene un comportamiento estacional. En algunos trimestres, los datos pueden ser más variables que en otros. Esto sugiere

heterocedasticidad estacional.

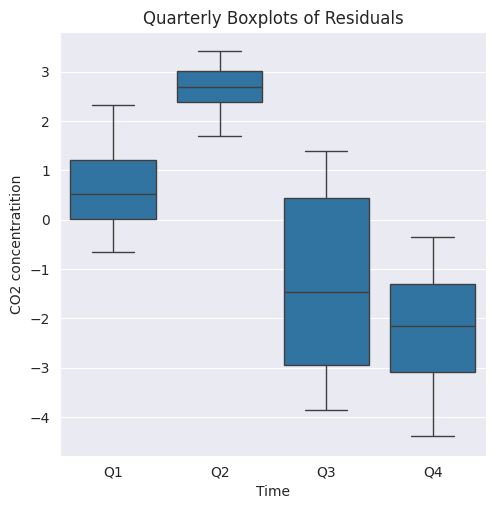

1.10. Gráficos de cajas múltiples#

Boxplot

El gráfico de la subserie estacional para la serie de residuos de

LinearRegressionpuede ser más informativo si se redibuja con gráficos de caja estacionales como se muestra en la siguiente figura.Un gráfico de cajas muestra tanto la tendencia central como la dispersión de los datos estacionales en un lote de unidades temporales. Además, la separación entre dos gráficos de caja adyacentes revela las variaciones dentro de la temporada

plt.figure(figsize=(5.5, 5.5))

g = sns.boxplot(data=data[data['Year'] > 1974], y='Residuals', x='Quarter')

g.set_title('Quarterly Boxplots of Residuals')

g.set_xlabel('Time')

g.set_ylabel('CO2 concentratition');

Observación

Q1yQ2tienen medianas positivas, lo que indica que los residuos en estos trimestres tienden a ser positivos, lo cual podría sugerir una subestimación sistemática del modelo en estas épocas del año.Q3yQ4tienen medianas negativas, lo que sugiere una sobreestimación sistemática en estos trimestres.Q2muestra la menor dispersión, lo que indica una menor variabilidad de los residuos durante este trimestre. Esto podría reflejar una mayor estabilidad en las predicciones del modelo en este período.Q3tiene la mayor dispersión, lo que sugiere mayor variabilidad o incertidumbre en las predicciones del modelo en este trimestre.

1.11. Cambios cíclicos#

Cambios cíclicos

Los cambios cíclicos son movimientos que se observan cada pocas unidades de tiempo, menos frecuentes que las fluctuaciones estacionales, pueden no tener un período fijo y suelen ocurrir cada pocos años. Se necesitan datos a largo plazo para identificarlos, como los ciclos económicos recurrentes.

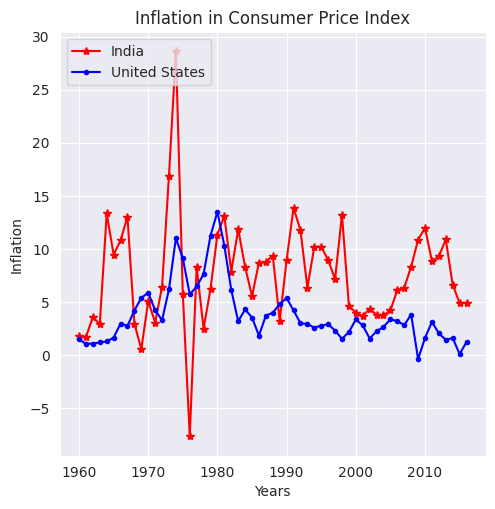

La inflación del CPI en India y Estados Unidos (consumer price index (CPI)) muestra patrones cíclicos cada 2-2.5 años. Los datos se obtuvieron de

datamarket.

inflation = pd.read_excel('/home/lihkir/Data/inflation-consumer-prices-annual.xlsx', parse_dates=['Year'])

inflation.head()

| Year | India | United States | |

|---|---|---|---|

| 0 | 1960-01-01 | 1.783265 | 1.509929 |

| 1 | 1961-01-01 | 1.752022 | 1.075182 |

| 2 | 1962-01-01 | 3.576159 | 1.116071 |

| 3 | 1963-01-01 | 2.941176 | 1.214128 |

| 4 | 1964-01-01 | 13.354037 | 1.308615 |

plt.figure(figsize=(5.5, 5.5))

plt.plot(range(1960,2017), inflation['India'], linestyle='-', marker='*', color='r')

plt.plot(range(1960,2017), inflation['United States'], linestyle='-', marker='.', color='b')

plt.legend(['India','United States'], loc=2)

plt.title('Inflation in Consumer Price Index')

plt.ylabel('Inflation')

plt.xlabel('Years');

La figura anterior muestra un cambio cíclico entre 1970 y 1980. La alta inflación en Estados Unidos e India entre 1970 y 1980 se debió principalmente a los aumentos en los precios del petróleo a nivel mundial, políticas económicas expansivas y presión sobre los precios por aumento de la demanda debido al rápido crecimiento económico.

1.12. Componentes irregulares#

Variaciones irregulares

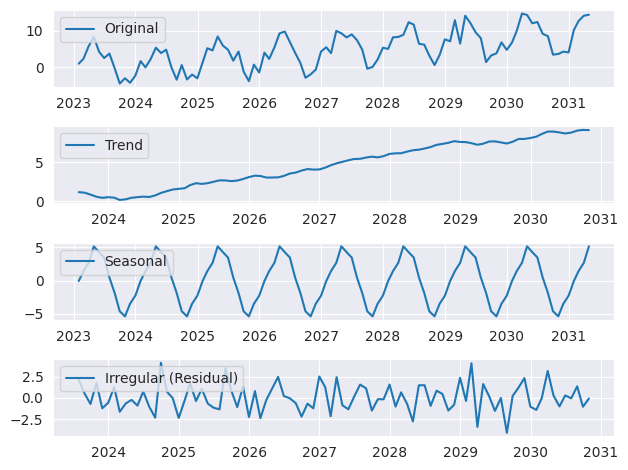

A pesar de que nuestro modelo que incluye cuatro componentes para expresar una serie temporal, aún puede haber un componente irregular. Este componente es un error irreducible que es aleatorio y no muestra una relación sistemática con el tiempo.

Refleja variaciones inesperadas en la serie temporal que son estocásticas y no pueden predecirse definitivamente con un modelo matemático, debido a la falta de información sobre variables explicativas o la presencia de ruido aleatorio.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from statsmodels.tsa.seasonal import seasonal_decompose

np.random.seed(42)

n = 100

time = np.arange(n)

trend = 0.1 * time

seasonality = 5 * np.sin(2 * np.pi * time / 12)

irregular = np.random.normal(0, 2, n)

series = trend + seasonality + irregular

date_range = pd.date_range(start="2023-01-01", periods=n, freq='M')

data = pd.DataFrame({'Date': date_range, 'Value': series}).set_index('Date')

decomposition = seasonal_decompose(data['Value'], model='additive', period=12)

plt.figure()

plt.subplot(411)

plt.plot(data['Value'], label='Original')

plt.legend(loc='upper left')

plt.subplot(412)

plt.plot(decomposition.trend, label='Trend')

plt.legend(loc='upper left')

plt.subplot(413)

plt.plot(decomposition.seasonal, label='Seasonal')

plt.legend(loc='upper left')

plt.subplot(414)

plt.plot(decomposition.resid, label='Irregular (Residual)')

plt.legend(loc='upper left')

plt.tight_layout()

plt.show()

1.13. Modelos de análisis de series temporales#

Introducción

El objetivo del análisis de series temporales es desarrollar un modelo matemático que pueda explicar el comportamiento observado de una serie temporal y, posiblemente, predecir su estado futuro.

El modelo elegido debe ser capaz de dar cuenta de una o más de las estructuras internas que pueden estar presentes. Con este fin, daremos una visión general de los siguientes modelos que se utilizan a menudo como componentes básicos del análisis de series temporales:

Modelos de media cero

Recorrido aleatorio

Modelos de tendencia

Modelos de estacionalidad

1.14. Modelos de media cero#

Definición

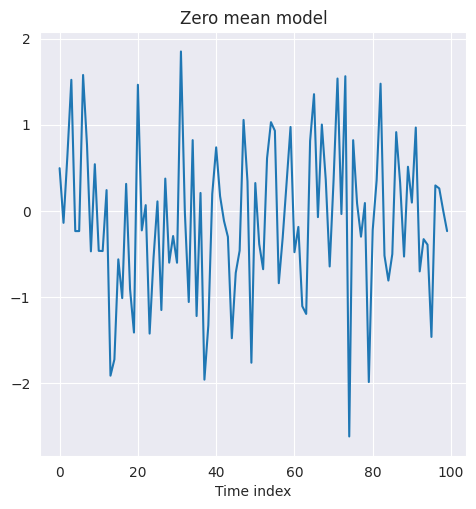

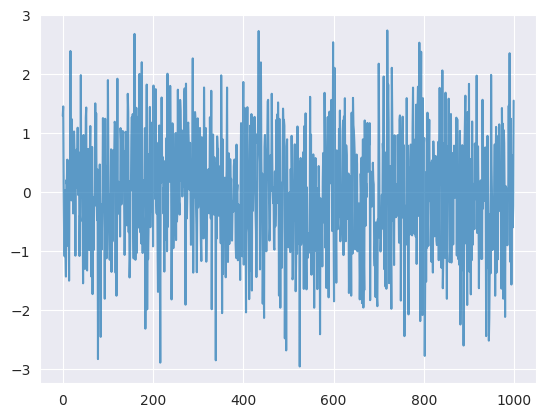

Los modelos de media cero tienen una media y una varianza constantes y no muestran tendencias predecibles ni estacionalidad. Se supone que las observaciones de un modelo de media cero son independientes e idénticamente distribuidas (iid) y representan el ruido aleatorio en torno a una media fija, que se ha deducido de la serie temporal como un término constante.

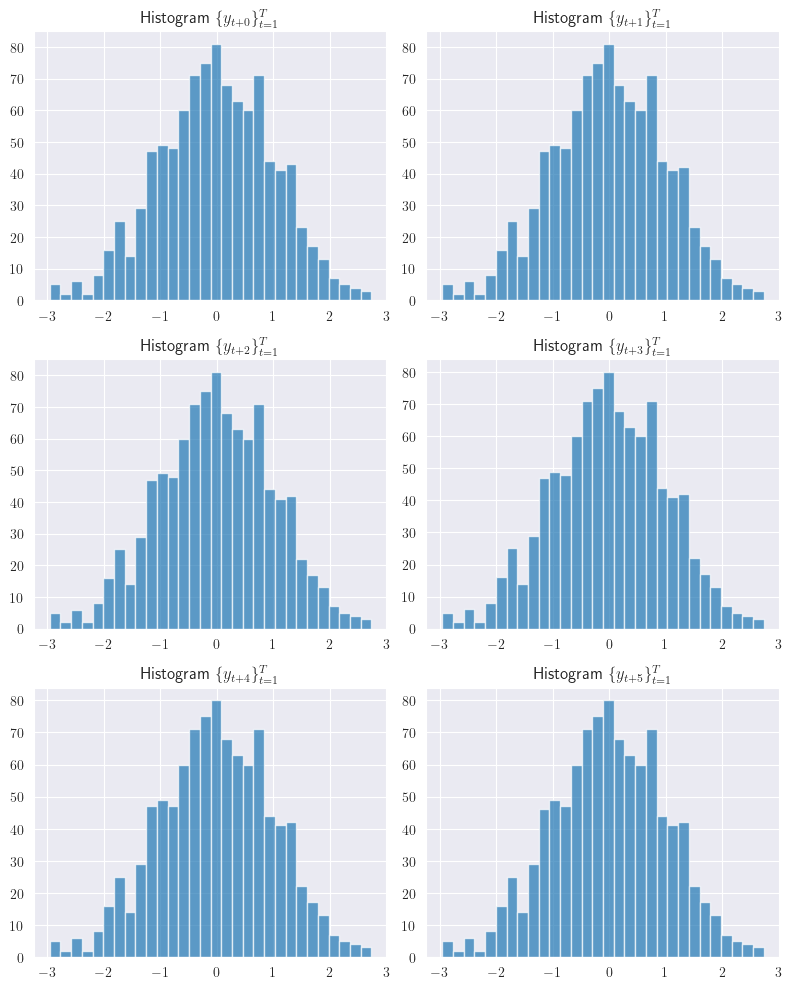

Consideremos que \(Y_{1}, Y_{2},\dots, Y_{T}\) representan las variables aleatorias correspondientes a \(T\) observaciones de un modelo de media cero. Si \(y_{1}, y_{2},\dots, y_{T}\) son \(t\) observaciones de la serie temporal de media cero, la distribución conjunta de las observaciones viene dada por el producto de las funciones de masa de probabilidad para cada índice temporal

Lo más habitual es modelar \(f(Y_{t} = y_{t})\) mediante una distribución normal de media cero y varianza \(\sigma^2\), que se supone que es el error irreducible del modelo y, por tanto, se trata como un ruido aleatorio. La siguiente figura muestra una serie de ruido aleatorio con media cero y distribución normal de varianza unitaria

import numpy as np

from matplotlib import pyplot as plt

import seaborn as sns

np.random.seed(42)

zero_mean_series = np.random.normal(loc=0.0, scale=1., size=100)

plt.figure(figsize=(5.5, 5.5))

g = sns.lineplot(zero_mean_series)

g.set_title('Zero mean model')

g.set_xlabel('Time index');

La media cero con varianza constante representa un ruido aleatorio que puede asumir infinitos posibles valores reales y es adecuado para representar variaciones irregulares en la serie temporal de una variable continua.

Sin embargo, en muchos casos, el estado observable del sistema o proceso puede ser de naturaleza discreta y limitarse a un número finito de valores posibles \(s_{1}, s_{2}, \dots, s_{m}\). En tales casos, se supone que la variable observada \(X\) obedece a la distribución multinomial,

\[ P(X = s_{1}) = p_{1}, P(X = s_{2}) = p_{2}, \dots, P(X = s_{m}) = p_{m}~\text{tal que}~p_{1} + p_{2} + \cdots + p_{m} = 1. \]Una serie temporal de este tipo es un proceso estocástico discreto.

El lanzamiento múltiple de un dado a lo largo del tiempo es un ejemplo de proceso estocástico discreto con seis resultados posibles para cada lanzamiento. Un proceso estocástico discreto más sencillo es un proceso binario como lanzar una moneda con solo dos resultados: cara y sello.

1.15. Camino aleatorio#

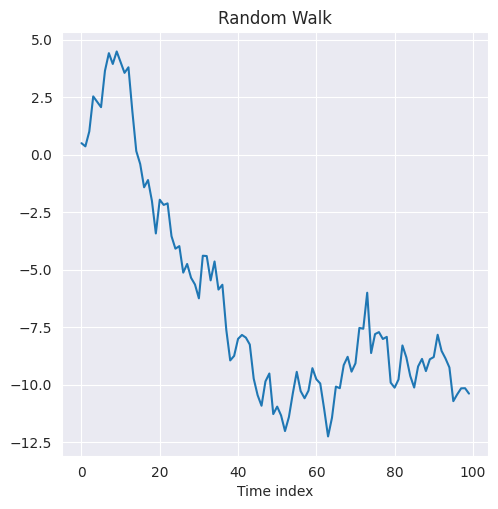

Definición

Un paseo aleatorio viene dado como una suma de \(n\) iids, que tiene media cero y varianza constante. A partir de esta definición, la realización de un paseo aleatorio en el índice de tiempo \(t\) viene dada por la suma

\[ S = y_{1} + y_{2} + \cdots + y_{T}. \]

La siguiente figura muestra el paseo aleatorio obtenido a partir de las iids, que varían según una distribución normal de media cero y varianza unitaria.

El paseo aleatorio es importante porque si se encuentra un comportamiento de este tipo en una serie temporal, se puede fácilmente reducir a un modelo de media cero tomando las diferencias de las observaciones de dos índices temporales consecutivos como

\[ S_{t}-S_{t-1} = y_{t} \]obteniendo así una serie iid con media cero y varianza constante.

El paseo aleatorio puede generarse tomando la suma acumulada del modelo de media cero discutido en la sección anterior. El siguiente código lo implementa

random_walk = np.cumsum(zero_mean_series)

plt.figure(figsize=(5.5, 5.5))

g = sns.lineplot(random_walk)

g.set_title('Random Walk')

g.set_xlabel('Time index');

El código dado genera y visualiza un paseo aleatorio (random walk) a partir de una serie de tiempo con media cero (

zero_mean_series). A continuación, se describen los pasos detallados:np.cumsum(zero_mean_series):Calcula la suma acumulada de los valores en

zero_mean_series.Esta operación transforma la serie original en un paseo aleatorio, donde cada nuevo valor es la suma del anterior más un incremento aleatorio.

Matemáticamente, esto se expresa como:

\[ X_t = X_{t-1} + \epsilon_t, \]donde \(\epsilon_t\) representa los valores de

zero_mean_series.

1.16. Modelos de tendencia#

Introducción

Este tipo de modelo pretende captar la tendencia a largo plazo de la serie temporal que puede ajustarse como regresión lineal del índice temporal. Cuando la serie temporal no presenta fluctuaciones periódicas o estacionales, puede expresarse simplemente como la suma de la tendencia y la media nula como

\[ y_{t} = \mu(t) + \varepsilon_{t} \]donde \(\mu(t)\) es la tendencia a largo plazo dependiente del tiempo de la serie.

La elección del modelo de tendencia \(\mu(t)\) es fundamental para captar correctamente el comportamiento de la serie temporal. El análisis exploratorio de datos suele proporcionar pistas para plantear la hipótesis de si el modelo debería ser lineal o no lineal en \(t\).

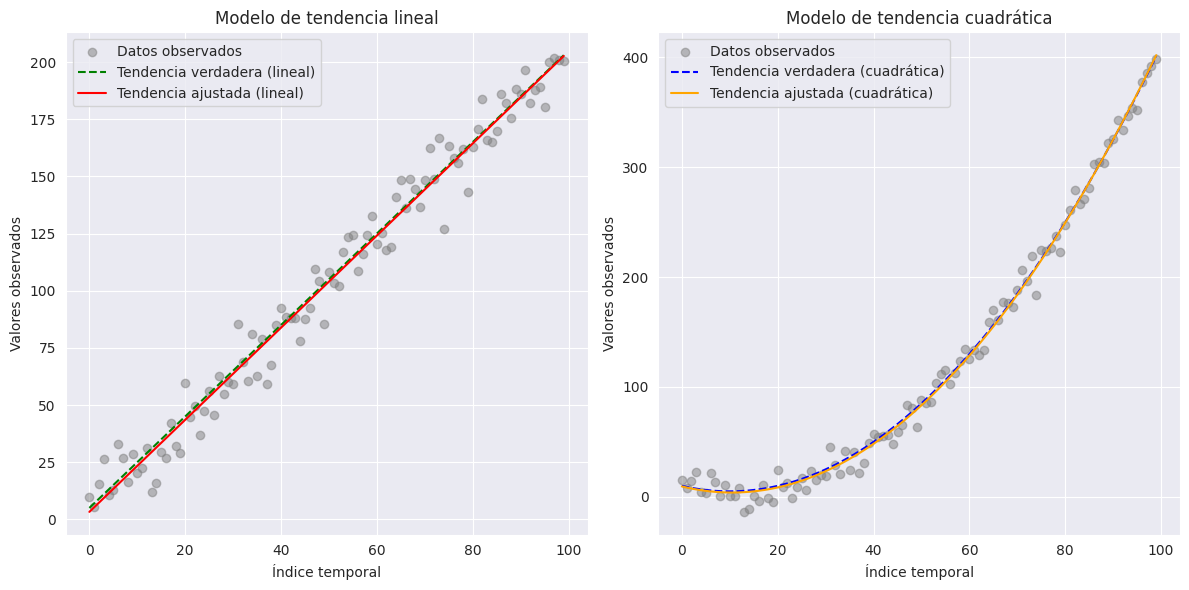

Un modelo lineal es simplemente \(\mu(t) = wt + b\), mientras que un modelo cuadrático es \(\mu(t) = w_{1}t + w_{2}t^{2} + b\). A veces, la tendencia se puede hipotetizar mediante una relación compleja en términos del índice temporal, como \(\mu(t) = w_{0}t^{p} + b\) o \(\mu(t)=w_{0}e^{w_{1}t}\).

Los pesos y sesgos en los modos de tendencia como los discutidos anteriormente se obtienen ejecutando una regresión con \(t\) como variable explicativa y \(\mu(t)\) como respuesta. Los residuos \(y_{t} - \mu(t)\) del modelo de tendencia es considerado el ruido irreducible y como realización del componente de media cero \(\varepsilon_{t}\).

import numpy as np

import matplotlib.pyplot as plt

np.random.seed(42)

t = np.arange(0, 100, 1)

true_trend_linear = 2 * t + 5 # Modelo de tendencia lineal: µ(t) = 2t + 5

true_trend_quadratic = 0.05 * t**2 - t + 10 # Modelo cuadrático: µ(t) = 0.05t^2 - t + 10

noise = np.random.normal(0, 10, size=len(t))

y_linear = true_trend_linear + noise # Serie con tendencia lineal

y_quadratic = true_trend_quadratic + noise # Serie con tendencia cuadrática

# Modelo lineal: y = wt + b

coeffs_linear = np.polyfit(t, y_linear, 1) # Grado 1

fitted_trend_linear = np.polyval(coeffs_linear, t)

# Modelo cuadrático: y = w1t + w2t^2 + b

coeffs_quadratic = np.polyfit(t, y_quadratic, 2) # Grado 2

fitted_trend_quadratic = np.polyval(coeffs_quadratic, t)

plt.figure(figsize=(12, 6))

plt.subplot(1, 2, 1)

plt.scatter(t, y_linear, color='gray', alpha=0.5, label='Datos observados')

plt.plot(t, true_trend_linear, color='green', label='Tendencia verdadera (lineal)', linestyle='dashed')

plt.plot(t, fitted_trend_linear, color='red', label='Tendencia ajustada (lineal)')

plt.title('Modelo de tendencia lineal')

plt.xlabel('Índice temporal')

plt.ylabel('Valores observados')

plt.legend()

plt.subplot(1, 2, 2)

plt.scatter(t, y_quadratic, color='gray', alpha=0.5, label='Datos observados')

plt.plot(t, true_trend_quadratic, color='blue', label='Tendencia verdadera (cuadrática)', linestyle='dashed')

plt.plot(t, fitted_trend_quadratic, color='orange', label='Tendencia ajustada (cuadrática)')

plt.title('Modelo de tendencia cuadrática')

plt.xlabel('Índice temporal')

plt.ylabel('Valores observados')

plt.legend()

plt.tight_layout()

plt.show()

1.17. Modelos de estacionalidad#

Definición

La estacionalidad se manifiesta como fluctuaciones periódicas y repetitivas en una serie temporal y, por tanto, se modelan como una suma ponderada de ondas senoidales de periodicidad conocida.

Suponiendo que la tendencia a largo plazo se ha eliminado mediante una línea de tendencia, el modelo de estacionalidad puede expresarse como \(y_{t} = S_{t}+ \varepsilon_{t}\), donde la variación estacional es

\[ S_{t}=\sum_{k=1}^{L}(w_{k}\cos(\alpha t)+v_{k}\sin(\alpha t))+b, \]con periocidad \(\alpha\).

Los modelos de estacionalidad también se conocen como modelos de regresión armónica, ya que intentan ajustar la suma de múltiples ondas senoidales. Los cuatro modelos descritos aquí son los componentes básicos de un modelo de series temporales completo.

Observación

Como ya se habrá dado cuenta, un modelo de suma cero representa el error irreducible del sistema y los otros tres modelos pretenden transformar una serie temporal dada en modelos de suma cero mediante transformaciones matemáticas adecuadas. Para obtener previsiones en series temporales originales, se aplican las transformaciones inversas pertinentes.

En las próximas secciones se detallarán los cuatro modelos aquí analizados. Sin embargo, hemos llegado a un punto en el que podemos resumir el enfoque genérico de un análisis de series temporales en los siguientes cuatro pasos:

Visualizar los datos en distintas etapas del índice temporal para revelar las tendencias a largo plazo y las fluctuaciones estacionales.

Ajustar la línea de tendencia para captar tendencias a largo plazo y trazar los residuos para comprobar si hay estacionalidad o error irreducible

Ajustar de un modelo de regresión armónica para captar la estacionalidad

Trazar los residuos dejados por el modelo de estacionalidad para comprobar si hay error irreducible.

Estos pasos suelen bastar para desarrollar modelos matemáticos para la mayoría de las series temporales. Los modelos individuales de tendencia y estacionalidad pueden ser sencillos o complejos, dependiendo de la serie temporal original y de la aplicación.

1.18. Autocorrelación y autocorrelación parcial#

Introducción

Tras aplicar las transformaciones matemáticas comentadas en el apartado anterior, a menudo nos encontramos con lo que se conoce como una serie temporal estacionaria (o débilmente estacionaria), que se caracteriza por una media constante \(\text{E}(y_{t})\) y una correlación que solo depende del desfase entre dos pasos temporales, pero independiente del valor del paso temporal, esto es, su distribución de probabilidad es completamente independiente del tiempo.

Este tipo de covarianza es la clave en el análisis de series temporales y se denomina autocovarianza o autocorrelación, cuando se normaliza en el intervalo de -1 a 1. La autocorrelación refleja el grado de dependencia lineal entre la serie temporal en el índice \(t\) y las series temporales de los índices \(t-k\) o \(t+k\).

Una autocorrelación positiva indica que los valores presentes y futuros de la serie temporal se mueven en la misma dirección, mientras que los valores negativos significan que los valores presentes y futuros se mueven en sentido contrario.

Si la autocorrelación es cercana a cero, las dependencias temporales dentro de la serie pueden ser difíciles de encontrar. Debido a esta propiedad, la autocorrelación es útil para predecir el estado futuro de una serie temporal a \(h\) pasos por delante.

Definición

La covarianza entre \(y_{t}\) y su valor en otro período de tiempo, digamos, \(y_{t+k}\) se denomina autocovarianza en el desfase (lag) \(k\) y se define como

La colección de los valores de \(\gamma_{k}, k = 0, 1, 2,\dots\) se denomina función de autocovarianza. Tenga en cuenta que la autocovarianza en el lag \(k = 0\) es solo la varianza de la serie temporal; es decir, \(\gamma_{0}=\sigma_{y}^{2}\), que es constante para una serie de tiempo estacionaria.

El coeficiente de autocorrelación en el lag \(k\) para una serie temporal estacionaria es

El conjunto de los valores de \(\rho_{k}, k = 0, 1, 2, \dots\) se denomina función de autocorrelación (ACF). Obsérvese que, por definición, \(\rho_{0} = 1\). Además, la ACF es independiente de la escala de medición de la serie temporal, por lo que es una cantidad adimensional. Adicionalmente, \(\rho_{k} = \rho_{-k}\); es decir, la ACF es simétrica en torno a cero, por lo que solo es necesario calcular la mitad positiva (o negativa).

Es necesario estimar la autocovarianza y los ACF a partir de una serie temporal de longitud finita, digamos, \(y_{1}, y_{2}, \dots, y_{T}\). La estimación habitual de la función de autocovarianza es

\[\begin{split} \\[1mm] c_{k}=\hat{\gamma}_{k}=\frac{1}{T}\sum_{t=1}^{T-k}(y_{t}-\overline{y})(y_{t+k}-\overline{y}),\quad k=1,2,\dots,K, \end{split}\]y la ACF es estimada por la función de autocorrelación muestral (o ACF muestral)

\[\begin{split} \\[1mm] r_{k}=\hat{\rho}_{k}=\frac{c_{k}}{c_{0}},\quad k=0,1,2,\dots,K. \end{split}\]

El siguiente tutorial puede ser de utilidad para quienes gozan usar

Excel. En esta oportunidad puede ser usado como calculadora para obtener de forma manual la función ACF (ver How to calculate ACF by 2 ways in Excel)

Observación

Una buena regla general es que se necesitan al menos 50 observaciones para obtener una estimación fiable de la ACF, y las autocorrelaciones de las muestras individuales deben calcularse hasta el retardo \(K\), donde \(K\) es aproximadamente \(T/4\).

A menudo tendremos que determinar si el coeficiente de autocorrelación en un determinado retardo es cero. Esto puede hacerse comparando el coeficiente de autocorrelación de la muestra en el retardo \(k, r_{k}\), con su error estándar.

Sí, suponemos que las observaciones no están correlacionadas, es decir, \(\rho_{k} = 0\) para todo \(k\), entonces la varianza del coeficiente de autocorrelación de la muestra es (ver [Bartlett, 1946])

\[\begin{split} \\[1mm] \textsf{Var}(r_{k})\cong\frac{1}{T}, \end{split}\]y error estándar es

\[ \textsf{se}(r_{k})\cong\frac{1}{\sqrt{T}}. \]

Para abordar el cálculo de este error, Bartlett considera el proceso estocástico discreto AR \(y_{t+1}=\phi y_{t}+\varepsilon_{t+1}\). Para este propósito, utiliza la siguiente expresión para la varianza aproximada del coeficiente de autocorrelación estimado de un proceso normal estacionario dada por

Por ejemplo, si \(\rho_{k}=\phi^{|k|},~(-1<\phi<1)\), es decir, la función de autocorrelación se reduce exponencialmente, entonces la Ecuación (1.1) se convierte en (

verifíquelo)

Bajo el supuesto de que los \(\rho_{k}\) son todos cero más allá de un cierto rezago \(k =q\), el error estándar de gran retardo se aproxima a la desviación estándar de \(r_{k}\) para retardos adecuadamente grandes \((k > q)\). Entonces los errores estándar para las autocorrelaciones estimadas \(r_{k}\) adoptan la forma simple (

bonus)

1.19. Experimentos numéricos ACF#

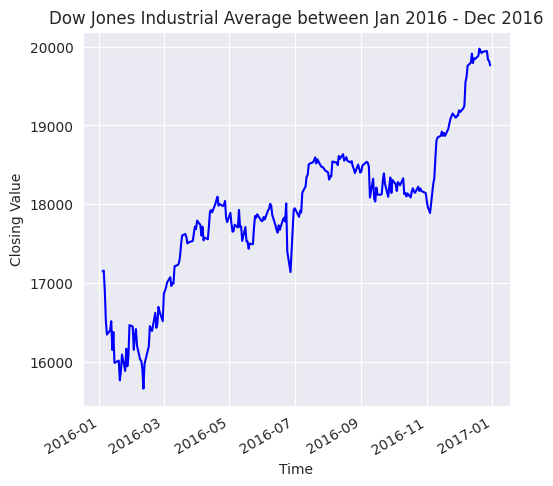

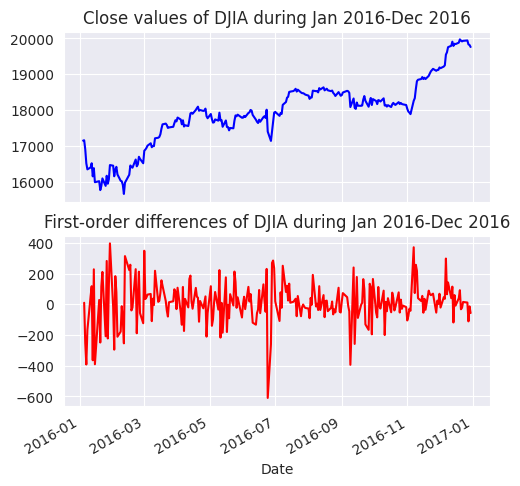

La presencia de autocorrelación puede identificarse trazando los valores observados de la función de autocorrelación (ACF) de una serie temporal determinada. Este gráfico suele denominarse

ACF. Ilustremos cómo el trazado de los valores observados de laACFpuede ayudar a detectar la presencia de autocorrelación.Para ello, trazaremos primero el valor diario del Dow Jones Industrial Average (DJIA) observado durante enero de 2016 a diciembre de 2016

import pandas as pd

from matplotlib import pyplot as plt

from statsmodels.graphics.tsaplots import plot_acf, plot_pacf

djia_df = pd.read_excel('/home/lihkir/Data/DJIA_Jan2016_Dec2016.xlsx')

djia_df.index = djia_df['Date']

djia_df.head()

| Date | Open | High | Low | Close | Adj Close | Volume | |

|---|---|---|---|---|---|---|---|

| Date | |||||||

| 2016-01-04 | 2016-01-04 | 17405.480469 | 17405.480469 | 16957.630859 | 17148.939453 | 17148.939453 | 148060000 |

| 2016-01-05 | 2016-01-05 | 17147.500000 | 17195.839844 | 17038.609375 | 17158.660156 | 17158.660156 | 105750000 |

| 2016-01-06 | 2016-01-06 | 17154.830078 | 17154.830078 | 16817.619141 | 16906.509766 | 16906.509766 | 120250000 |

| 2016-01-07 | 2016-01-07 | 16888.359375 | 16888.359375 | 16463.630859 | 16514.099609 | 16514.099609 | 176240000 |

| 2016-01-08 | 2016-01-08 | 16519.169922 | 16651.890625 | 16314.570313 | 16346.450195 | 16346.450195 | 141850000 |

plt.figure(figsize=(5.5, 5.5))

djia_df['Close'].plot(color='b')

plt.title('Dow Jones Industrial Average between Jan 2016 - Dec 2016')

plt.xlabel('Time')

plt.ylabel('Closing Value');

De la figura anterior se desprende que cuando el DJIA empieza a subir, continúa haciéndolo durante algún tiempo y viceversa. Sin embargo, debemos comprobarlo mediante un gráfico ACF.

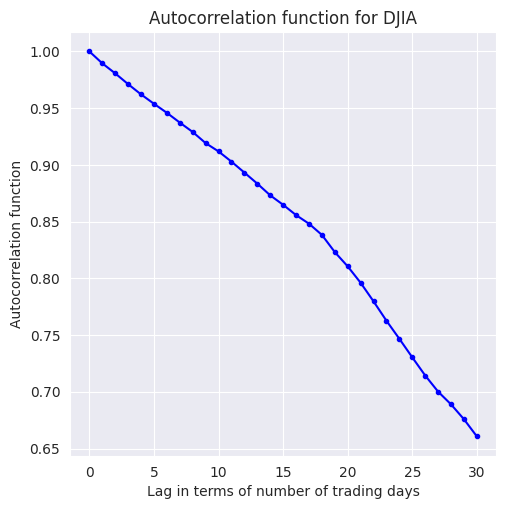

A continuación, se estima la ACF calculando la autocorrelación para diferentes valores del retardo \(h\), que en este caso varía de 0 a 30. La función

Pandas.Series.autocorrse utiliza para calcular la autocorrelación para diferentes valores del retardo

lag = range(0,31)

djia_acf = []

for l in lag:

djia_acf.append(djia_df['Close'].autocorr(l))

El código anterior, itera sobre una lista de 31 valores de lag, empezando de 0 a 30. Un rezago de 0 índica autocorrelación de una observación consigo misma (\(\text{Cov}(y_{t}, y_{t})/\text{Var}(y_{t})\)) y, por lo tanto, se espera que sea 1.0, como también se confirma en la figura siguiente.

Autocorrelación en

DJIA Closeparece disminuir linealmente con el retardo, con un cambio aparente en la tasa de caída en torno a los 18 días. Con un desfase de 30 días, la ACF es ligeramente superior a 0.65.

plt.figure(figsize=(5.5, 5.5))

plt.plot(djia_acf, marker='.', color='b')

plt.title('Autocorrelation function for DJIA')

plt.xlabel('Lag in terms of number of trading days')

plt.ylabel('Autocorrelation function');

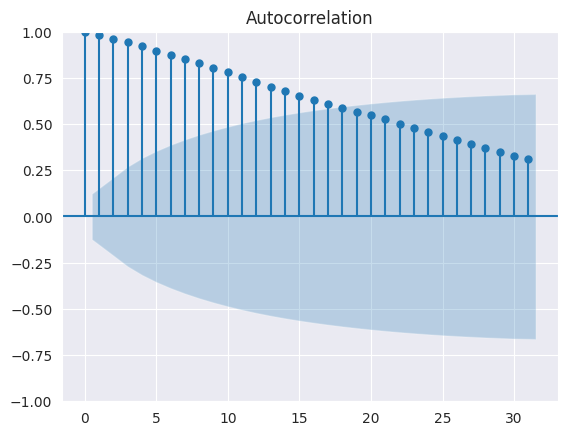

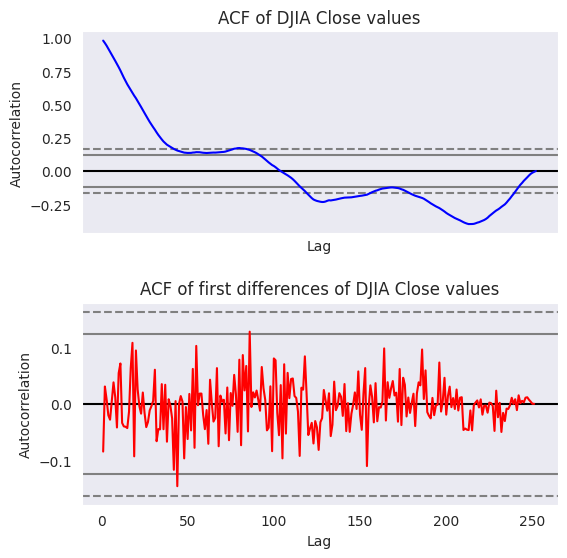

El gráfico ACF muestra que la autocorrelación, en el caso de los valores de cierre del DJIA, tienen una dependencia funcional del desfase temporal entre las observaciones. Hemos escrito un bucle for para calcular la autocorrelación en distintos retardos y hemos representado los resultados mediante la función

sns.pointplot. También se puede utilizar la funciónplot_acfdestatsmodels.graphics.tsaplotspara calcular y trazar la autocorrelación en varios rezagos.Además, esta función también traza los intervalos de confianza del 95%. La autocorrelación fuera de estos intervalos de confianza es una correlación estadísticamente significativa, mientras que las que están dentro de los intervalos de confianza se deben a ruido aleatorio. La autocorrelación y los intervalos de confianza generados por

plot_acfse muestran en la figura siguiente:

plt.figure(figsize=(5.5, 5.5));

plot_acf(djia_df['Close'], lags=31);

<Figure size 550x550 with 0 Axes>

Hasta ahora hemos hablado de la autocorrelación, que es una medida de la dependencia lineal entre las variables \(y_{t}\) y \(y_{t+k}\). Los modelos autorregresivos (AR) captan esta dependencia como una regresión lineal entre \(y_{t+k}\) y \(y_{t}\). Sin embargo, las series temporales tienden a llevar información y estructuras de dependencia por etapas, por lo que la autocorrelación en el rezago \(k\) también se ve influida por las variables intermedias \(y_t, y_{t+1}, \dots, y_{t+k-1}\). Por lo tanto, la autocorrelación no es la medida correcta de la correlación mutua entre \(y_{t}\) y \(y_{t+k}\) en presencia de las variables intermedias.

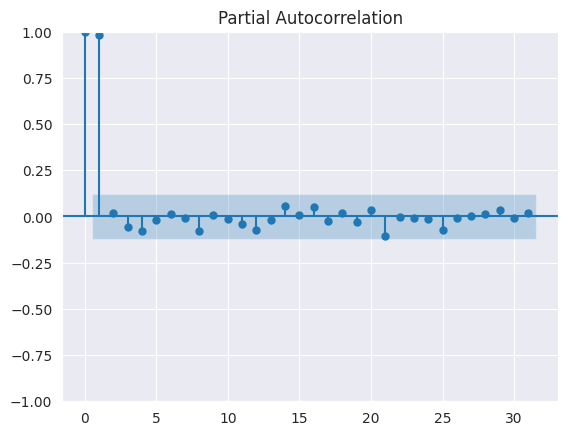

Sería erróneo elegir \(k\) en modelos AR basados en autocorrelación. La autocorrelación parcial (PACF) resuelve este problema midiendo la correlación entre \(y_{t}\) y \(y_{t+k}\) cuando se ha eliminado la influencia de las variables intermedias. Por lo tanto, la autocorrelación parcial en el análisis de series temporales define la correlación entre \(y_{t}\) y \(y_{t+k}\) que no tiene en cuenta los retardos \(t+1, \dots, t+k-1\). La PACF ayuda a identificar el orden \(p\) de un modelo \(AR(p)\). Veamos la autocorrelación parcial de los valores de cierre del

DJIAutilizandoplot_pacfcomo sigue

plt.figure(figsize=(5.5, 5.5));

plot_pacf(djia_df['Close'], lags=31);

<Figure size 550x550 with 0 Axes>

La primera autocorrelación parcial en el retardo cero es siempre 1.0. Como se observa en el gráfico anterior, la autocorrelación parcial solo en el retardo uno es estadísticamente significativa, mientras que para el resto de los rezagos está dentro de los intervalos de confianza del 95%. Por lo tanto, para los valores de cierre del

DJIAel orden de los modelos \(AR\) es uno (usar \(AR(1)\)).

1.20. Análisis de datos de series temporales#

Observación

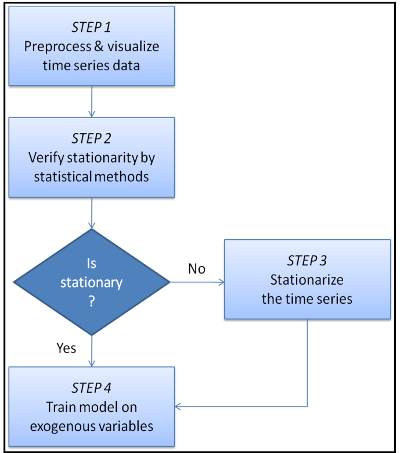

El análisis de series temporales implica dos pasos clave: visualizar los datos para identificar tendencias y patrones, y ajustar estas tendencias y estacionalidades para crear series estacionarias. Las fluctuaciones irregulares restantes se modelan como observaciones independientes e idénticamente distribuidas (iid) mediante regresión lineal sobre variables exógenas.

Este enfoque mejora las predicciones futuras. La metodología se presenta en un diagrama de flujo y se cubren los primeros tres pasos, incluyendo procesamiento avanzado de datos, pruebas estadísticas para estacionariedad y descomposición de series temporales. Estos conceptos son fundamentales para desarrollar modelos predictivos de series temporales.

1.21. Procesamiento avanzado y visualización de datos de series temporales#

Introducción

Las series temporales suelen transformarse en estadísticos agregados como la media o la mediana para períodos de tiempo más largos. Por ejemplo, en ventas mensuales de automóviles, la estacionalidad mensual se resalta al calcular promedios para cada mes a lo largo de varios años. Esto se logra dividiendo la serie en segmentos mensuales y agregando los datos de cada segmento.

Para un análisis más detallado, a menudo se utilizan agregados móviles, como medias trimestrales, que se calculan desplazando una ventana de tiempo sobre la serie y calculando estadísticos dentro de esa ventana. Esto se demuestra con ejemplos de remuestreo, agrupación y cálculo de estadísticos móviles utilizando librerías de

pandas.

1.22. Remuestreo de datos de series temporales#

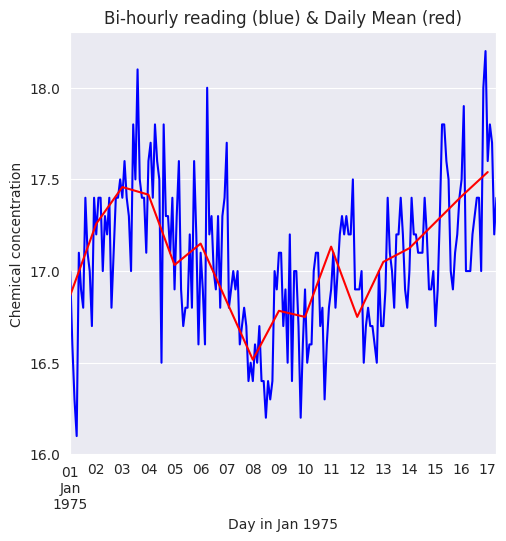

La técnica de remuestreo se ilustra utilizando una serie temporal sobre concentraciones químicas tomadas cada dos horas entre el 1 de enero de 1975 y el 17 de enero de 1975. El conjunto de datos se ha descargado de datamarket.

import pandas as pd

import numpy as np

from matplotlib import pyplot as plt

A continuación se leen los datos del archivo

CSVen unpandas.DataFramey mostramos las primeras filas delDataFrame

df = pd.read_csv('/home/lihkir/Data/chemical-concentration-readings.csv')

print('Shape of the dataset:', df.shape)

df.head()

Shape of the dataset: (197, 2)

| Timestamp | Chemical conc. | |

|---|---|---|

| 0 | 1975-01-01 00:00:00 | 17.0 |

| 1 | 1975-01-01 02:00:00 | 16.6 |

| 2 | 1975-01-01 04:00:00 | 16.3 |

| 3 | 1975-01-01 06:00:00 | 16.1 |

| 4 | 1975-01-01 08:00:00 | 17.1 |

Convertiremos las observaciones de la serie temporal original en medias diarias aplicando las funciones de remuestreo y media en la segunda columna. La función de remuestreo requiere que los índices de fila del

DataFrameseantimestampde tiponumpy.datetime64.Por lo tanto, cambiamos los índices de fila de números enteros, como se muestra en la tabla anterior, a

datetime_rowidque es unapandas.Seriesde objetosnumpy.datetime64.Los objetos

numpy.datetime64se generan a partir de la columnaTimestamputilizando la función de utilidadpd.todatetime. El siguiente código muestra cómo se realiza la reindexación por filas

datetime_rowid = df['Timestamp'].map(lambda t: pd.to_datetime(t, format='%Y-%m-%d %H:%M:%S'))

df.index = datetime_rowid

df.head()

| Timestamp | Chemical conc. | |

|---|---|---|

| Timestamp | ||

| 1975-01-01 00:00:00 | 1975-01-01 00:00:00 | 17.0 |

| 1975-01-01 02:00:00 | 1975-01-01 02:00:00 | 16.6 |

| 1975-01-01 04:00:00 | 1975-01-01 04:00:00 | 16.3 |

| 1975-01-01 06:00:00 | 1975-01-01 06:00:00 | 16.1 |

| 1975-01-01 08:00:00 | 1975-01-01 08:00:00 | 17.1 |

Ahora estamos listos para aplicar las funciones de

resampleymeanen la columnaChemical conc.

daily = df['Chemical conc.'].resample('D')

daily_mean = daily.mean()

Observe que hemos pasado el argumento

Da la funciónresamplepara generar las medias diarias. Para los agregados mensuales y anuales, tenemos que pasarMeYa la funciónresample. Por último, las medias originales y diarias se representan en la siguiente figura, que muestra el efecto de suavización de esta última.

fig = plt.figure(figsize=(5.5, 5.5))

ax = fig.add_subplot(1,1,1)

df['Chemical conc.'].plot(ax=ax, color='b')

daily_mean.plot(ax=ax, color='r')

ax.set_title('Bi-hourly reading (blue) & Daily Mean (red)');

ax.set_xlabel('Day in Jan 1975');

ax.set_ylabel('Chemical concentration');

1.23. Agregación por grupos#

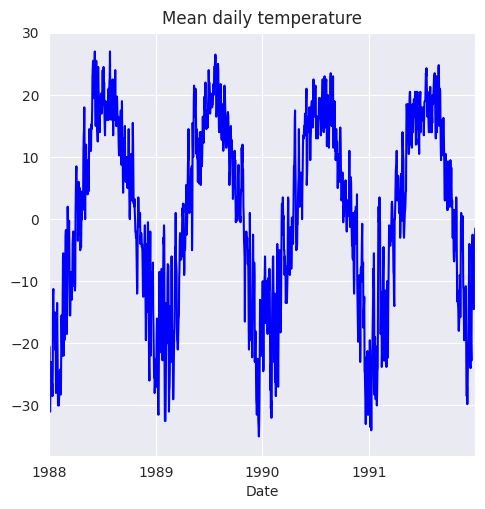

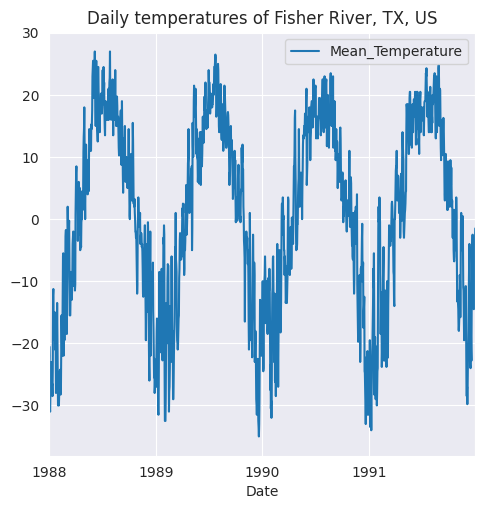

Para demostrar la agregación por grupos, utilizaremos la serie temporal de la temperatura media diaria del río Fisher en Texas, Estados Unidos. La serie temporal tiene observaciones tomadas entre el 1 de enero de 1988 y el 31 de diciembre de 1991.

df = pd.read_csv('/home/lihkir/Data/mean-daily-temperature-fisher-river.csv')

df.index = df['Date'].map(lambda d: pd.to_datetime(d, format = '%Y-%m-%d'))

print('Shape of dataframe:', df.shape)

df.head()

Shape of dataframe: (1461, 2)

| Date | Mean temperature | |

|---|---|---|

| Date | ||

| 1988-01-01 | 1988-01-01 | -23.0 |

| 1988-01-02 | 1988-01-02 | -20.5 |

| 1988-01-03 | 1988-01-03 | -22.0 |

| 1988-01-04 | 1988-01-04 | -30.5 |

| 1988-01-05 | 1988-01-05 | -31.0 |

fig = plt.figure(figsize=(5.5, 5.5))

ax = fig.add_subplot(1,1,1)

df['Mean temperature'].plot(ax=ax, color='b')

ax.set_title('Mean daily temperature');

La serie temporal original parece tener patrones mensuales que se repiten cada año y que pueden verificarse calculando los promedios mensuales. Esto se hace agrupando los datos en 12 meses y luego calculando los promedios de cada mes. Comenzamos agregando una columna

Month_YearalDataFrame

df['Month_Year'] = df.index.map(lambda d: d.strftime('%m-%Y'))

df.head()

| Date | Mean temperature | Month_Year | |

|---|---|---|---|

| Date | |||

| 1988-01-01 | 1988-01-01 | -23.0 | 01-1988 |

| 1988-01-02 | 1988-01-02 | -20.5 | 01-1988 |

| 1988-01-03 | 1988-01-03 | -22.0 | 01-1988 |

| 1988-01-04 | 1988-01-04 | -30.5 | 01-1988 |

| 1988-01-05 | 1988-01-05 | -31.0 | 01-1988 |

A continuación, la columna

Mean temperaturese agrupa con respecto a la nueva columnaMonth_Yeary se calculan la media, la mediana y las desviaciones estándar de cada mes

monthly_stats = df.groupby(by='Month_Year')['Mean temperature'].aggregate([np.mean, np.median, np.std])

monthly_stats.reset_index(inplace=True)

monthly_stats.head()

| Month_Year | mean | median | std | |

|---|---|---|---|---|

| 0 | 01-1988 | -22.137097 | -23.0 | 5.260640 |

| 1 | 01-1989 | -17.129032 | -18.0 | 8.250725 |

| 2 | 01-1990 | -15.112903 | -12.0 | 6.606764 |

| 3 | 01-1991 | -23.038710 | -24.5 | 7.095570 |

| 4 | 02-1988 | -19.025862 | -19.5 | 8.598522 |

Tenga en cuenta que las filas de la tabla anterior no están en orden ascendente de

Month_Year. Por lo tanto, es necesario registrarlo. Esto se hace creando dos nuevas columnasMonthyYeary, a continuación, ordenando en orden ascendenteYear, seguido de la ordenación en orden ascendente deMonth

monthly_stats['Year'] = monthly_stats['Month_Year']\

.map(lambda m: pd.to_datetime(m, format='%m-%Y').strftime('%Y'))

monthly_stats['Month'] = monthly_stats['Month_Year']\

.map(lambda m: pd.to_datetime(m, format='%m-%Y').strftime('%m'))

monthly_stats.sort_values(by=['Year', 'Month'], inplace=True)

monthly_stats.head()

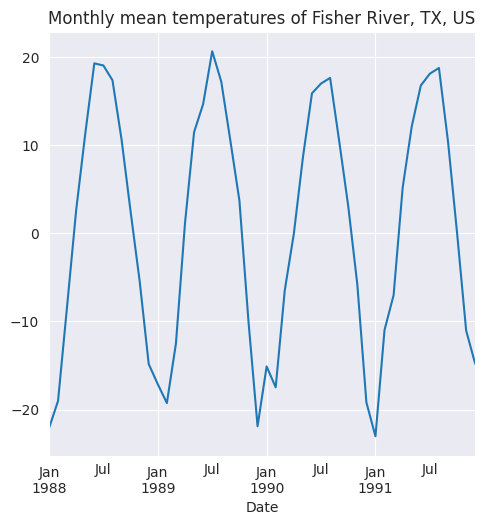

| Month_Year | mean | median | std | Year | Month | |

|---|---|---|---|---|---|---|

| 0 | 01-1988 | -22.137097 | -23.000 | 5.260640 | 1988 | 01 |

| 4 | 02-1988 | -19.025862 | -19.500 | 8.598522 | 1988 | 02 |

| 8 | 03-1988 | -8.258065 | -9.250 | 5.341459 | 1988 | 03 |

| 12 | 04-1988 | 2.641667 | 1.875 | 5.057720 | 1988 | 04 |

| 16 | 05-1988 | 11.290323 | 11.000 | 6.254364 | 1988 | 05 |

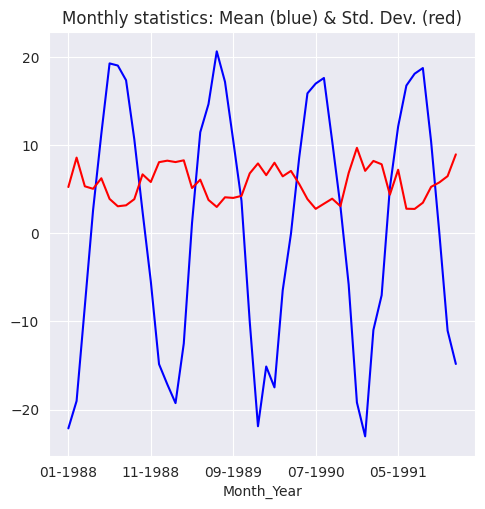

Los agregados mensuales se representan en la siguiente figura, que pone de manifiesto la estacionalidad mensual existente en los datos originales.

monthly_stats.index = monthly_stats['Month_Year']

fig = plt.figure(figsize=(5.5, 5.5))

ax = fig.add_subplot(1,1,1)

monthly_stats['mean'].plot(ax=ax, color='b')

monthly_stats['std'].plot(ax=ax, color='r')

ax.set_title('Monthly statistics: Mean (blue) & Std. Dev. (red)');

1.24. Estadísticos móviles#

Introducción

Los estadísticos móviles o rodantes se calculan desplazando una ventana sobre la serie temporal original y agregando los datos de cada ventana. Los parámetros clave son el tamaño de la ventana y la longitud del paso, que definen la entrada y el intervalo para cada cálculo.

Por ejemplo, supongamos que se utiliza un tamaño de ventana de \(k\) y un intervalo de longitud \(l\) para calcular la función \(f\) sobre una serie temporal \(y_{1}, y_{2},\dots, y_{T}\) con \(T\) observaciones. En este caso, el estadístico móvil se obtiene como \(f(y_{1}, y_{2},\dots, y_{k}), f(y_{1+l}, y_{2+l},\dots, y_{k+l})\), y así sucesivamente.

Obsérvese que cada vez se calcula la función desplazando la ventana temporal hacia la derecha en \(l\) unidades de tiempo. La media móvil es un caso especial de la función \(f\) y requiere simplemente promediar las observaciones en la ventana de tiempo.

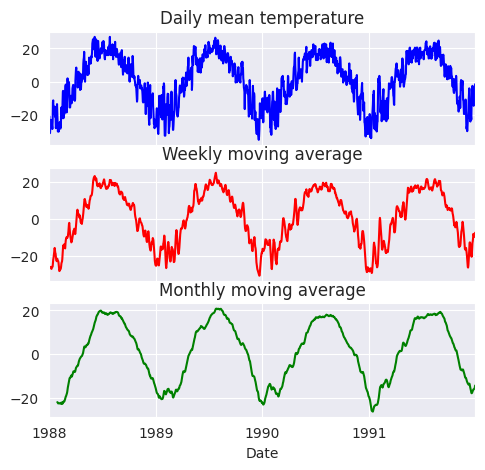

Vamos a demostrar cómo se pueden calcular las medias móviles en el conjunto de datos de Fisher River. Calcularemos las medias móviles semanales, fijando el tamaño de la ventana en siete y deslizando la ventana un lugar a la derecha

weekly_moving_average = df['Mean temperature'].rolling(7).mean()

monthly_moving_average = df['Mean temperature'].rolling(30).mean()

La función

rollingsolo toma como argumento el tamaño de la ventana. Por lo tanto, para añadir una longitud de paso de más de uno, seguimos calculando la media móvil como se ha mostrado anteriormente, pero cortamos la serie resultante para obtener el resultado deseado. Para las franjas de más de dos unidades de tiempo utilizamos el siguiente código

weekly_moving_average_2stride = df['Mean temperature'].rolling(7).mean()[::2]

monthly_moving_average_2stride = df['Mean temperature'].rolling(30).mean()[::2]

En el análisis de series temporales, los estadísticos móviles basadas en la longitud de paso son las más comunes, por lo que rara vez se necesitará algo más que la función rolling. Los datos originales se representan en la siguiente figura, que muestra la reducción del ruido y el consiguiente efecto de suavización producido por las medias móviles

fig, axarr = plt.subplots(3, sharex=True)

fig.set_size_inches(5.5, 5,5)

df['Mean temperature'].plot(ax=axarr[0], color='b')

axarr[0].set_title('Daily mean temperature');

weekly_moving_average.plot(ax=axarr[1], color='r')

axarr[1].set_title('Weekly moving average');

monthly_moving_average.plot(ax=axarr[2], color='g')

axarr[2].set_title('Monthly moving average');

Theorem 1.1

Una media móvil simple de longitud \(N\) asigna ponderaciones \(1/N\) a las observaciones más recientes \(y_{T}, y_{T-1},\dots, y_{T-N+1}\), y peso cero a todas las demás observaciones. Si \(M_{T}\) es la media móvil, la media móvil de \(N\) intervalos en el período \(T\) es

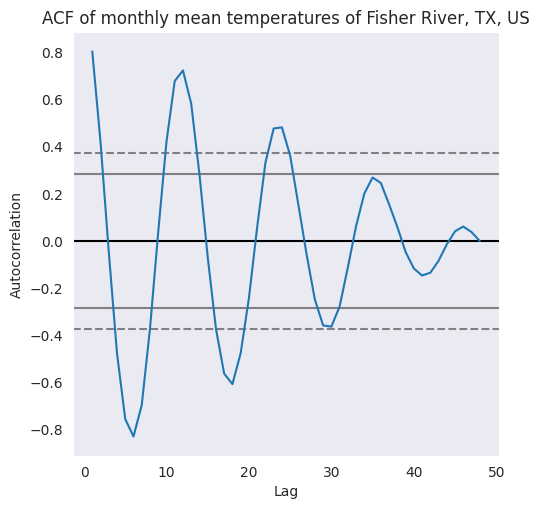

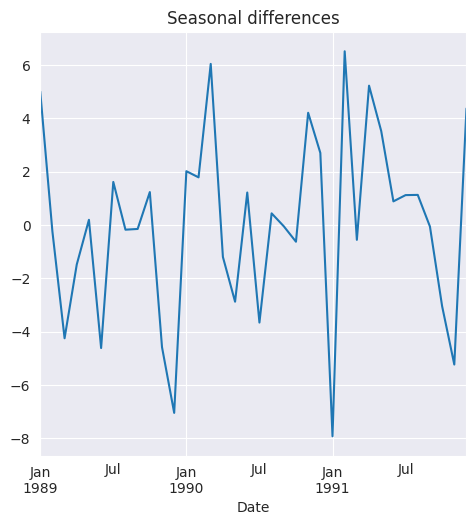

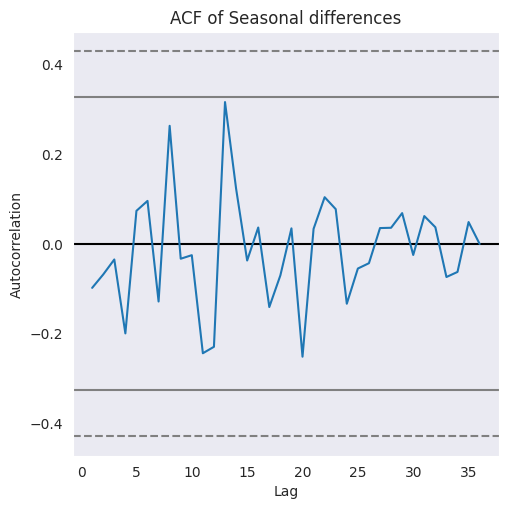

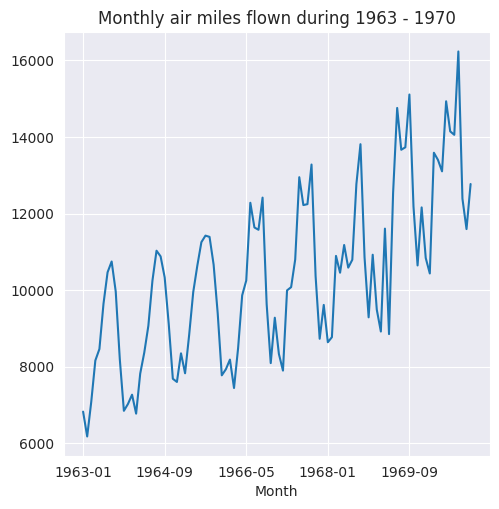

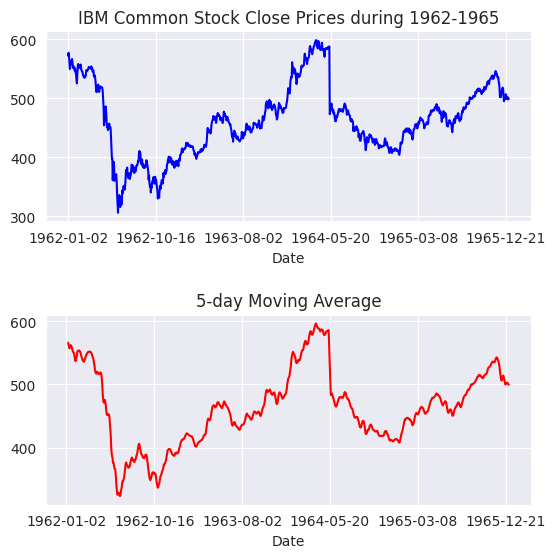

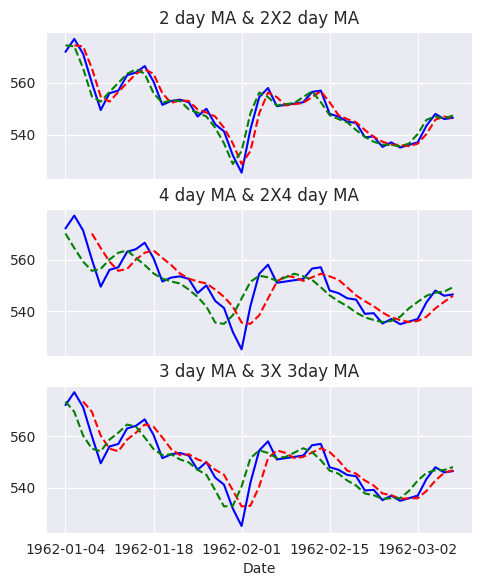

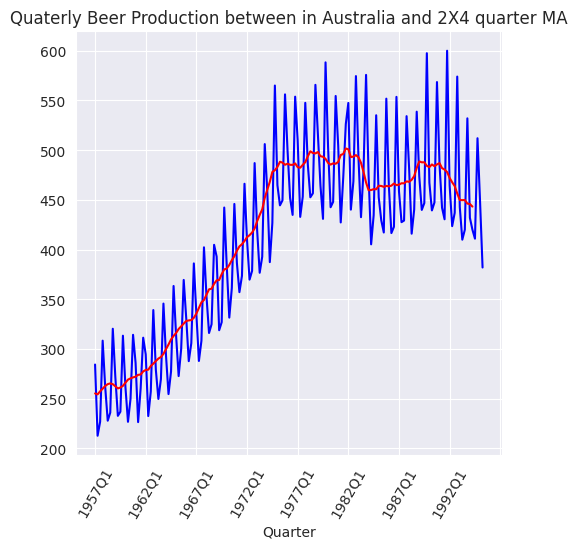

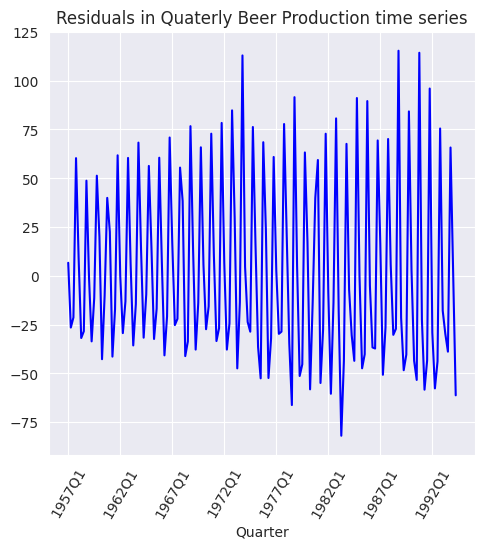

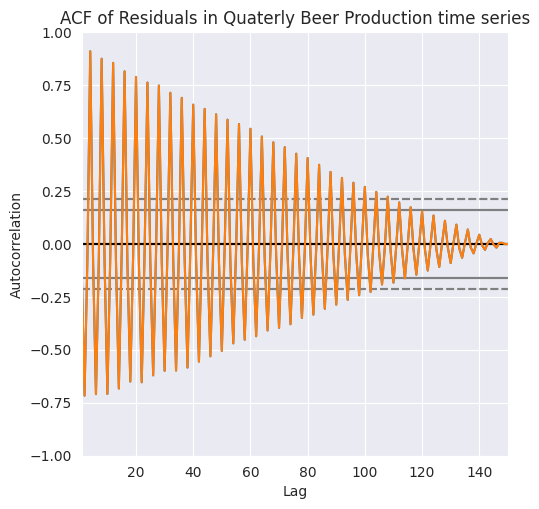

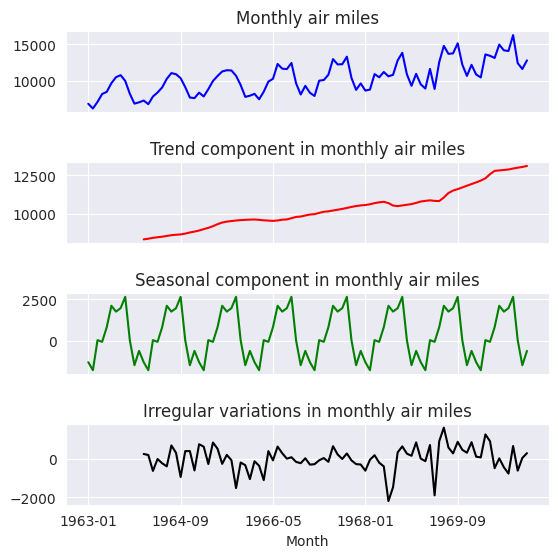

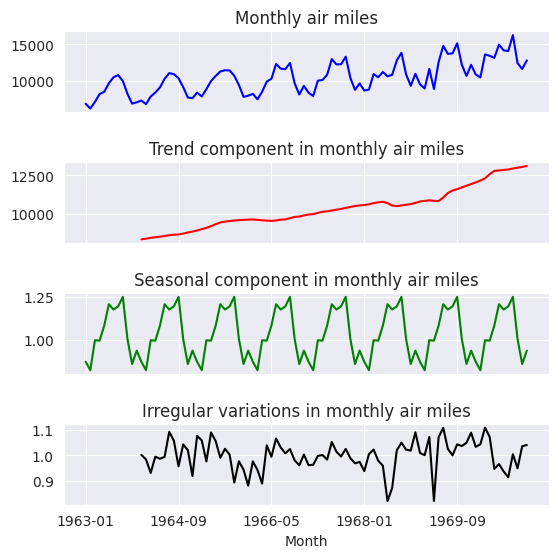

Evidentemente, a medida que se dispone de cada nueva observación, ésta se añade a la suma a partir de la cual se calcula la media móvil y la observación más antigua se descarta (