3. Modelos autorregresivos integrados de media móvil#

Introducción

El capítulo anterior cubrió técnicas de predicción basadas en suavizado exponencial, suponiendo que las series temporales tienen componentes deterministas y estocásticos. Sin embargo, estas técnicas pueden ser insuficientes cuando la suposición de ruido aleatorio completamente aleatorio no se cumple.

En tales casos, los modelos autorregresivos pueden ser útiles, ya que aprovechan la correlación entre observaciones pasadas para ajustarse inmediatamente. Estos modelos incluyen términos autorregresivos y de media móvil, y pueden ser utilizados en diferentes enfoques de predicción, como ARMA y ARIMA.

La presente sección se centra en el modelo autorregresivo y cubrirá los siguientes temas:

Media móvil (MA)

Autorregresivo (AR)

Media móvil autorregresiva (ARMA)

Media móvil integrada autorregresiva (ARIMA)

3.1. Análisis#

3.2. Modelos lineales para series de tiempo estacionarias#

En el ámbito del modelado estadístico, a menudo nos esforzamos por descubrir la genuina conexión entre entradas específicas y la variable de salida. Nuestros esfuerzos suelen dar como resultado modelos que simplemente aproximan la “verdadera” relación.

Este resultado comúnmente se origina en las decisiones estratégicas del analista para facilitar el proceso de modelado. Una suposición fundamental que a menudo simplifica los esfuerzos de modelado es la suposición de linealidad.

Filtro lineal

Un filtro lineal constituye una transformación lineal de una serie temporal, \(x_{t}\) a otra serie de tiempo \(y_{t}\),

(3.1)#\[ y_{t}=L(x_{t})=\sum_{i=-\infty}^{+\infty}\psi_{i}x_{t-i},~\text{con}~t=,\dots,-1,0,1,\dots, \]

En ese sentido, el filtro lineal puede verse como un “proceso” que convierte la entrada, \(x_{t}\), en una salida, \(y_{t}\), y esa conversión no es instantánea, sino que involucra todos (presente, pasado y futuro) los valores de la entrada en forma de suma con diferentes “pesos”, \(\psi_{i}\), en cada \(x_{t-i}\).

Además, el filtro lineal en la Ecuación (3.1) se dice que tiene las siguientes propiedades:

Invariante en el tiempo, ya que los coeficientes \(\psi_{i}\) no dependen del tiempo.

Físicamente realizable si \(\psi_{i}=0\) para \(i<0\); esto es, el output \(y_{t}\) es una función lineal de los actuales y pasados valores del input: \(y_{t}=\psi_{0}x_{t}+\psi_{1}x_{t-1}+\cdots\)

Estable si \(\sum_{i=-\infty}^{+\infty}|\psi_{i}|<\infty\).

En los filtros lineales, ciertas condiciones hacen que ciertas características, como la estacionariedad de la serie temporal de entrada, también se manifiesten en la de salida. En el capítulo previo, exploramos el concepto de estacionariedad mencionado anteriormente.

3.3. Estacionariedad#

La estacionariedad de una serie temporal está relacionada con sus propiedades estadísticas en el tiempo. Es decir, en un sentido más estricto, una serie temporal estacionaria exhibe un comportamiento estadístico similar en el tiempo, lo que a menudo se caracteriza como una distribución de probabilidad constante en el tiempo.

Sin embargo, por lo general, es satisfactorio considerar los dos primeros momentos de la serie temporal y definir la estacionariedad (o estacionariedad débil) de la siguiente manera:

El valor esperado de la serie temporal no depende del tiempo

La función de autocovarianza definida como \(\text{Cov}(y_{t} , y_{t+k})\) para cualquier rezago, \(k\) es solo una función de \(k\) y no del tiempo; es decir, \(\gamma_{y}(k) = \text{Cov}(y_{t}, y_{t+k})\).

Observación

La estacionariedad de una serie temporal se puede evaluar aproximadamente mediante la observación de su comportamiento en diferentes momentos. Si muestra un comportamiento similar en distintos instantes, se puede asumir estacionariedad y continuar con el modelado.

Además, pruebas preliminares, como el análisis de la función de autocorrelación, pueden proporcionar indicios sobre la estacionariedad. Un decaimiento lento en la autocorrelación sugiere desviaciones de la estacionariedad. También existen pruebas metodológicas más rigurosas para evaluar la estacionariedad, que se discutirán posteriormente en este capítulo.

Theorem 3.1

Dado un filtro lineal invariante en el tiempo y estable y una serie de tiempo con input \(x_{t}\) estacionario, con \(\mu_{x}=\text{E}(x_{t})\) y \(\gamma_{x}(k)=\text{Cov}(x_{t}, x_{t+k})\), la serie de tiempo

(3.2)#\[ y_{t}=L(x_{t})=\sum_{i=-\infty}^{\infty}\psi_{i}x_{t-i}, \]donde \(t=,\dots,-1,0,1,\dots,\) es también estacionaria.

El siguiente proceso lineal estable con ruido blanco \(\varepsilon_{t}\) es también estacionario

(3.3)#\[ y_{t}=\mu+\sum_{i=-\infty}^{\infty}\psi_{i}\varepsilon_{t-i}, \]y además puede reescribirse como sigue, en términos del operado backshift \(B\) como

(3.4)#\[ y_{t}=\mu+\left(\sum_{i=0}^{\infty}\psi_{i}B^{i}\right)\varepsilon_{t}=\mu+\Psi(B)\varepsilon_{t}. \]

Demostración

Calculemos valor esperado para la serie \(y_{t}\) dada en la Ecuación (3.2). Nótese que es constante respecto a \(t\)

Evaluemos ahora la autocovarianza. Nótese que esta es función de \(k\)

Por lo tanto, la serie de tiempo definida como en la Ecuación (3.2) es estacionaria. Consideremos ahora la serie de la Ecuación (3.3) y verifiquemos que es estacionaría

Dado que \(\gamma_{c}(k)=\text{Cov}(c,c)=\text{Var}(c)=0,~\forall c\in\mathbb{R}\), la autocovarianza de la Ecuación (3.3) está dada por

Nótese que la última igualdad es independiente de \(t\). Además, se usó el hecho de que: \(h=k+i-j=0\) entonces \(\gamma_{\varepsilon}(h)=\sigma^{2}\).

La Ecuación (3.3) puede reescribirse como

Observación

La Ecuación (3.4) se le conoce como el promedio móvil infinito y sirve como una clase general de modelos para cualquier serie temporal estacionaria [Wold, 1938].

Básicamente, establece que cualquier serie temporal \(y_{t}\) no determinística y estacionaria débil puede ser representada como en la Ecuación (3.3), donde \(\{\psi_{i}\}\) satisfacen \(\sum_{i=0}^{\infty}\psi_{i}^{2}<\infty\).

Una interpretación más intuitiva de este teorema es que una serie temporal estacionaria puede ser vista como la suma ponderada de las “perturbaciones” aleatorias presentes y pasadas [Yule, 1971, Bisgaard and Kulahci, 2011].

El Teorema de Wold requiere que los choques aleatorios en una media móvil infinita sean ruido blanco, que definimos como choques aleatorios no correlacionados con varianza constante. Es importante tener en cuenta que hay una diferencia entre correlación e independencia.

Indpendencia vs No Correlación

Las variables aleatorias independientes también son no correlacionadas, pero lo contrario no siempre es cierto. La independencia entre dos variables aleatorias se refiere a que su función de distribución de probabilidad conjunta es igual al producto de las distribuciones marginales. Es decir, dos variables aleatorias \(X\) e \(Y\) se dicen independientes si

Esto puede interpretarse de manera general como que si \(X\) e \(Y\) son independientes, conocer el valor de \(X\), por ejemplo, no proporciona información sobre cuál podría ser el valor de \(Y\). Para dos variables aleatorias no correlacionadas \(X\) e \(Y\), tenemos que su correlación y su covarianza son iguales a cero. Es decir,

Esto implica que si \(X\) y \(Y\) son no correlacionados, \(\text{E}[XY]=\text{E}[X]\text{E}[Y]\)

Claramente, si dos variables son independientes, estas son no correlacionadas, ya que bajo independencia se tiene que

Lo contrario no siempre es cierto. Para ilustrarlo con un ejemplo, consideremos \(X\), una variable aleatoria con una función de densidad de probabilidad simétrica alrededor de 0, es decir, \(\text{E}[X] = 0\). Supongamos que la segunda variable \(Y\) es igual a \(|X|\).

Dado que conocer el valor de \(X\) también determina el valor de \(Y\), estas dos variables claramente no son independientes. Sin embargo, se puede demostrar que

Entonces \(\text{E}[XY]=\text{E}[X]\text{E}[Y]\). Esto muestra que \(X\) e \(Y\) no están correlacionadas, pero no son independientes.

3.4. Proceso de media móvil finito \(MA(q)\)#

Proceso de media móvil de orden \(q\) (\(MA(q)\))

En los modelos de media móvil de orden finito o \(MA\), convencionalmente \(\psi_{0}\) se establece en 1 y los pesos que no se establecen en 0 se representan con la letra griega \(\theta\) con signo negativo delante. Por lo tanto, un proceso de media móvil de orden \(q\) (\(MA(q)\)) se expresa como

(3.5)#\[ y_{t}=\mu+\varepsilon_{t}-\theta_{1}\varepsilon_{t-1}-\cdots-\theta_{q}\varepsilon_{q} \]donde \(\{\varepsilon_{t}\}\) es ruido blanco.

Theorem 3.2

Dado que la Ecuación (3.5) es un caso especial de la Ecuación (3.4) con solo pesos finitos, un proceso \(MA(q)\) siempre es estacionario independientemente de los valores de los pesos. En términos del operador backshift, el proceso \(MA(q)\) está dado por

\[ y_{t}=\mu+\Phi(B)\varepsilon_{t},~\text{donde}~\Phi(B)=1-\sum_{i=1}^{q}\theta_{i}B^{i}. \]Además, dado que \(\{\varepsilon_{t}\}\) es ruido blanco, el valor esperado del proceso \(MA(q)\) es simplemente \(\text{E}(y_{t})=\mu\) y su varianza es

Similarmente, la autocovarianza en el lag \(k\) puede ser calculada como

Demostración

Nótese que utilizando el operador backshift el proceso \(MA(q)\) se escribe como

\[ y_{t}=\mu+(B^{0}-\theta_{1}B^{1}-\theta_{2}B^{2}-\cdots-\theta_{q}B^{q})\varepsilon_{t}=\mu+\left(1-\sum_{i=1}^{q}\theta_{i}B^{i}\right)\varepsilon_{t}=\mu+\Phi(B)\varepsilon_{t} \]

Dado que \(\{\varepsilon_{t}\}\) es un proceso white noise, su valor esperado está dado por

Además, su varianza está dada por

Análogamente, la autocovarianza en el lag \(k\) está dada por

\[\begin{split} \begin{align*} \gamma_{y}(k)&=\text{Cov}(y_{t}, y_{t+k})\\ &=\text{E}((\mu+\epsilon_{t}-\theta_{1}\varepsilon_{t-1}-\cdots-\theta_{q}\varepsilon_{t-q}-\mu)(\mu+\varepsilon_{t+k}-\theta_{1}\varepsilon_{t+k-1}-\cdots-\theta_{q}\varepsilon_{t+k-q}-\mu))\\ &=\text{E}((\epsilon_{t}-\theta_{1}\varepsilon_{t-1}-\cdots-\theta_{q}\varepsilon_{t-q})(\varepsilon_{t+k}-\theta_{1}\varepsilon_{t+k-1}-\cdots-\theta_{q}\varepsilon_{t+k-q})) \end{align*} \end{split}\]

Recuerde que: \(\text{E}(\varepsilon_{t})=0,~\text{Var}(\varepsilon_{t})=\text{E}(\varepsilon_{t}^{2})=\sigma^{2}\) y \(\text{Cov}(\varepsilon_{t}, \varepsilon_{t-k})=\text{E}(\varepsilon_{t}\varepsilon_{t-k})=0,~k\neq0\). Nótese además que para \(k=1\)

Análogamente, para \(k=2\) se tiene que (verifíquelo): \(\gamma_{y}(2)=\sigma^{2}(-\theta_{2}+\theta_{1}\theta_{3}+\theta_{2}\theta_{4}+\cdots+\theta_{2-q}\theta_{q})\). Por lo tanto,

Entonces la función de autocorrelación de \(MA(q)\), para \(k=1,2,\dots,q\) está dada por

Observación

Esta característica de la

ACFes muy útil para identificar el modeloMAy su orden adecuado, ya que “se corta” después del rezago \(q\). Sin embargo, en aplicaciones de la vida real, laACFmuestral, \(r(k)\), no necesariamente será igual a cero después del rezago \(q\). Se espera que se vuelva muy pequeña en valor absoluto después del rezago \(q\).Para un conjunto de datos de \(N\) observaciones, esto a menudo se prueba contra límites de \(\pm 2/\sqrt{N}\), donde \(1/\sqrt{N}\) es el valor aproximado para la desviación estándar de la

ACFpara cualquier rezago bajo la suposición de que \(\rho(k)=0\) para todos los \(k\).[Bartlett, 1946] [Brockwell and Davis, 1991] Tenga en cuenta que una fórmula más precisa para el error estándar del coeficiente de autocorrelación muestral \(k\) es proporcionada por (

bonus)\[ \text{s.e.}~(r(k))=N^{-1/2}\left(1+2\sum_{j=1}^{k-1}r(j)^{\star 2}\right)^{1/2} \]donde

\[\begin{split} r(j)^{\star}=\begin{cases}r(j) & \text{para}~\rho(j)\neq 0\\0 & \text{para}~\rho(j)=0.\end{cases} \end{split}\]

Un caso especial sería datos de ruido blanco, para los cuales \(\rho(j) = 0\) para todos los valores de \(j\). Por lo tanto, para un proceso de ruido blanco (es decir, sin autocorrelación), un intervalo razonable para los coeficientes de autocorrelación muestral sería \(\pm 2/N\) y cualquier indicación contraria puede considerarse como evidencia de dependencia serial en el proceso.

3.5. El Proceso de Media Móvil de Primer Orden, \(MA(1)\)#

Media Móvil de Primer Orden \(MA(1)\)

El modelo \(MA\) de orden finito más simple se obtiene cuando \(q = 1\) en la Ecuación (3.5)

Para el modelo de media móvil de primer orden o \(MA(1)\), tenemos la función de autocovarianza como

De manera similar, tenemos la función de autocorrelación como

De la Ecuación (3.8), podemos ver que la autocorrelación del primer rezago en \(MA(1)\) está limitada a

\[ |\rho_{y}(1)|=\frac{|\theta_{1}|}{1+\theta_{1}^{2}}\leq\frac{1}{2} \]y la función de autocorrelación se reduce a cero después del primer rezago.

import pandas as pd

import numpy as np

from matplotlib import pyplot as plt

from statsmodels.graphics.tsaplots import plot_acf, plot_pacf

import statsmodels.tsa.api as smtsa

import statsmodels.tsa.arima.model as arima_model

import seaborn as sns

import warnings

warnings.filterwarnings("ignore")

plt.rcParams['text.usetex'] = True

sns.set_style("darkgrid")

Show code cell source

def plotds(xt, nlag=30, fig_size=(12, 10)):

if not isinstance(xt, pd.Series):

xt = pd.Series(xt)

plt.figure(figsize=fig_size)

layout = (2, 2)

ax_xt = plt.subplot2grid(layout, (0, 0), colspan=2)

ax_acf = plt.subplot2grid(layout, (1, 0))

ax_pacf = plt.subplot2grid(layout, (1, 1))

xt.plot(ax=ax_xt)

ax_xt.set_title('Time Series')

plot_acf(xt, lags=50, ax=ax_acf)

plot_pacf(xt, lags=50, ax=ax_pacf)

plt.tight_layout()

return None

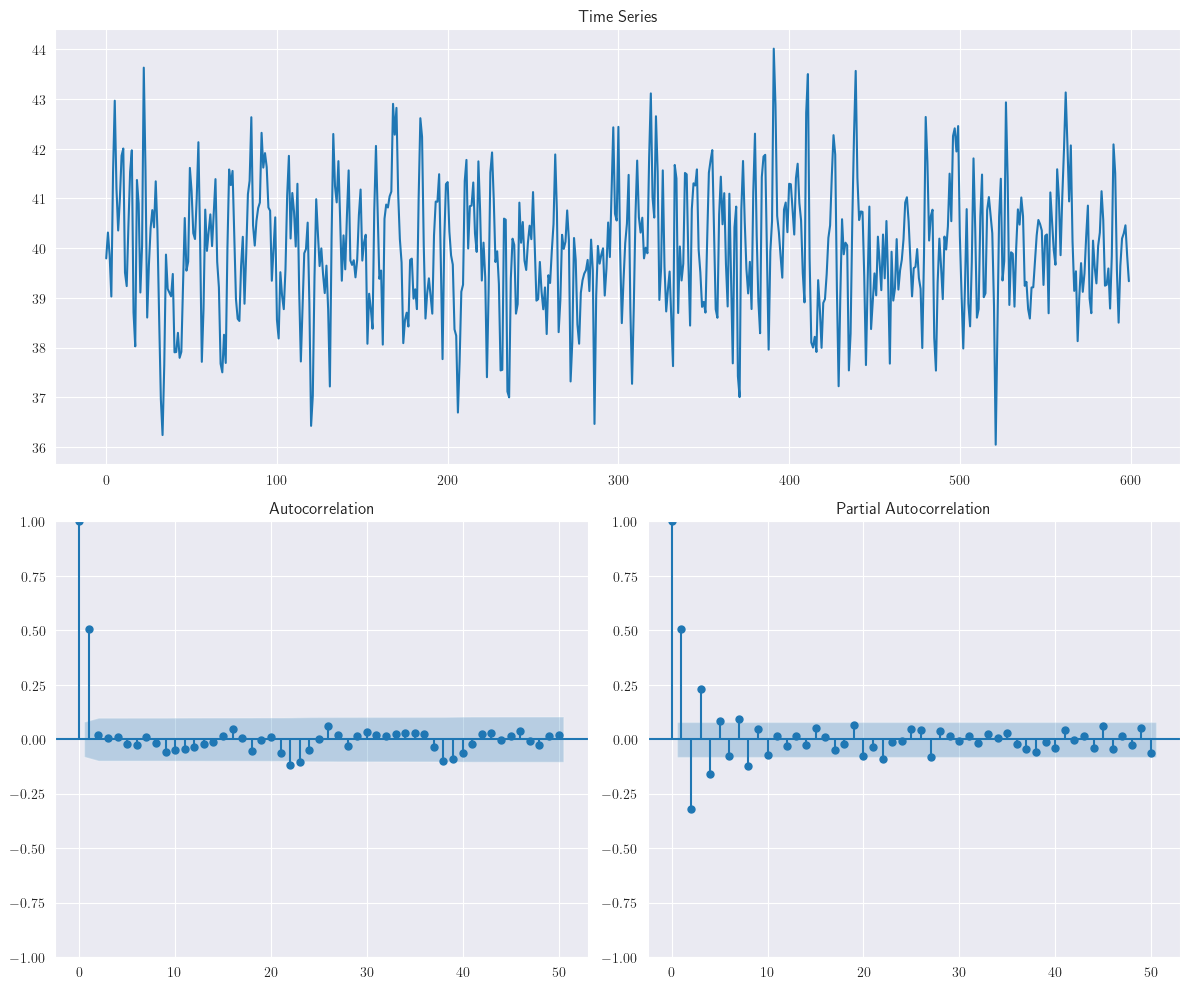

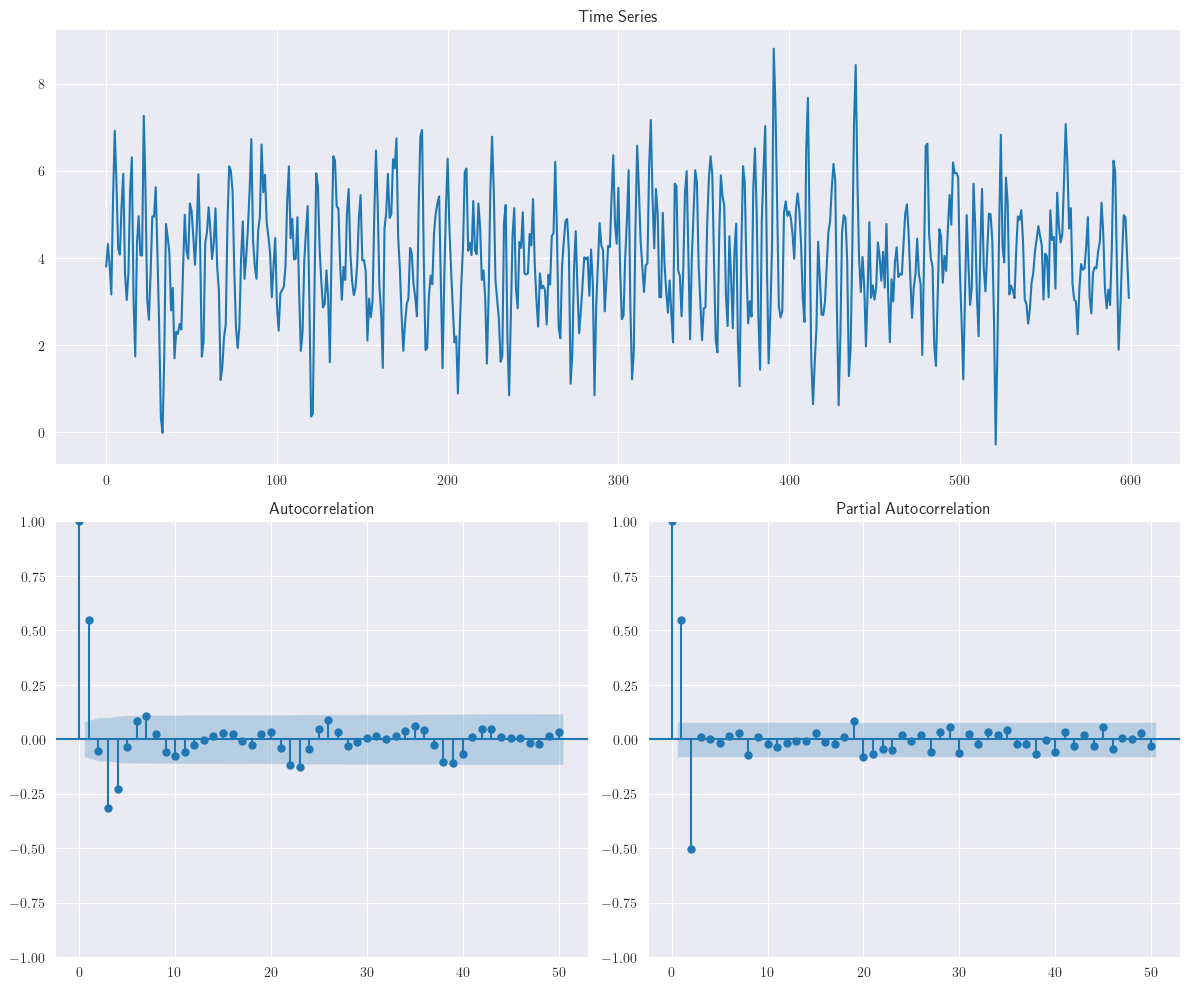

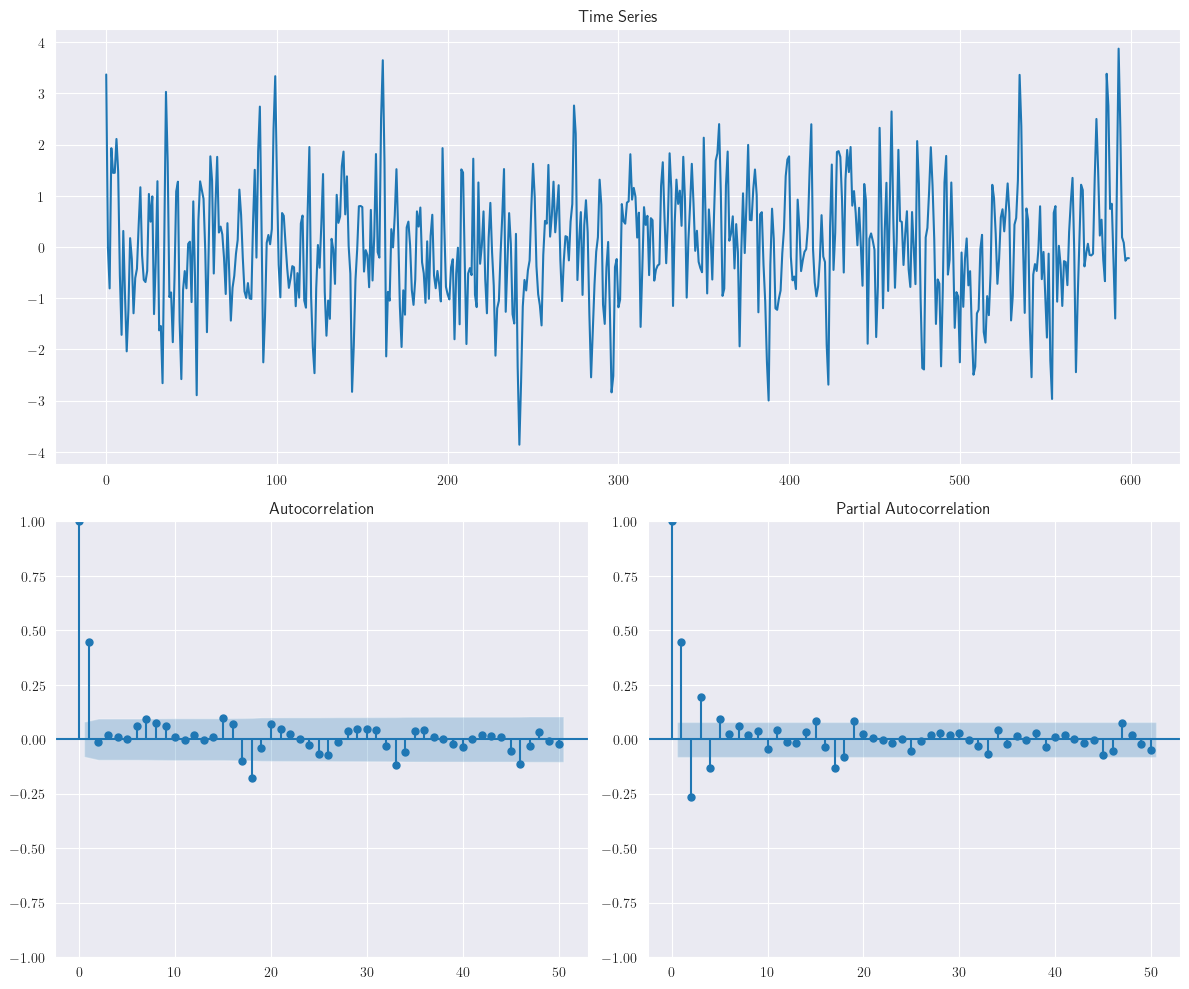

El siguiente gráfico corresponden al proceso \(MA(1)\): \(y_{t}=40+\varepsilon_{t}+0.8\varepsilon_{t-1}\). En este ejemplo se ha utilizado la librería arma_generate_sample. Debe instalarla previamente usando

pip

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0]) # phi1, phi2,...

maparams = np.array([0.8]) # theta1, theta2,...

intercept = 40

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

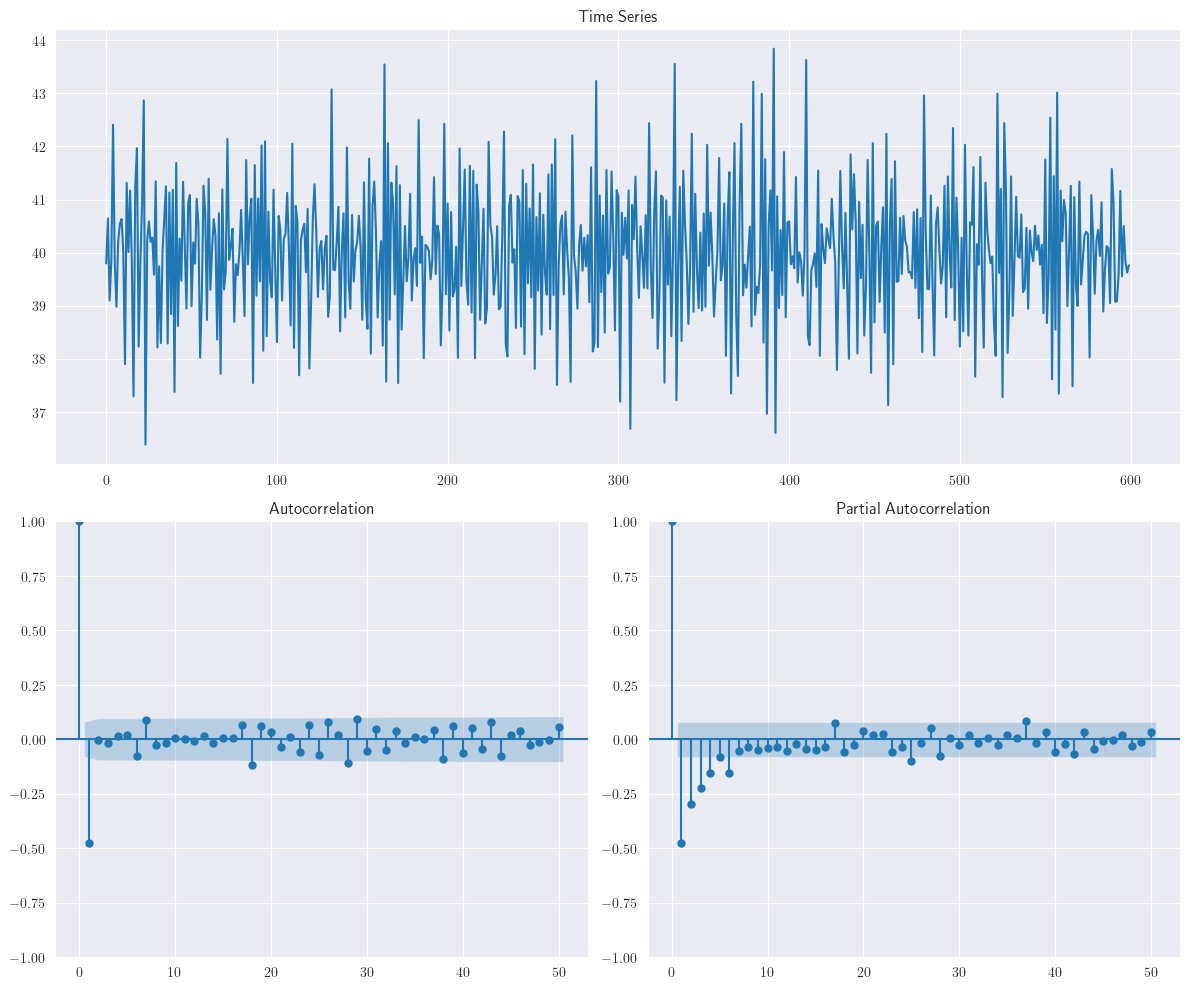

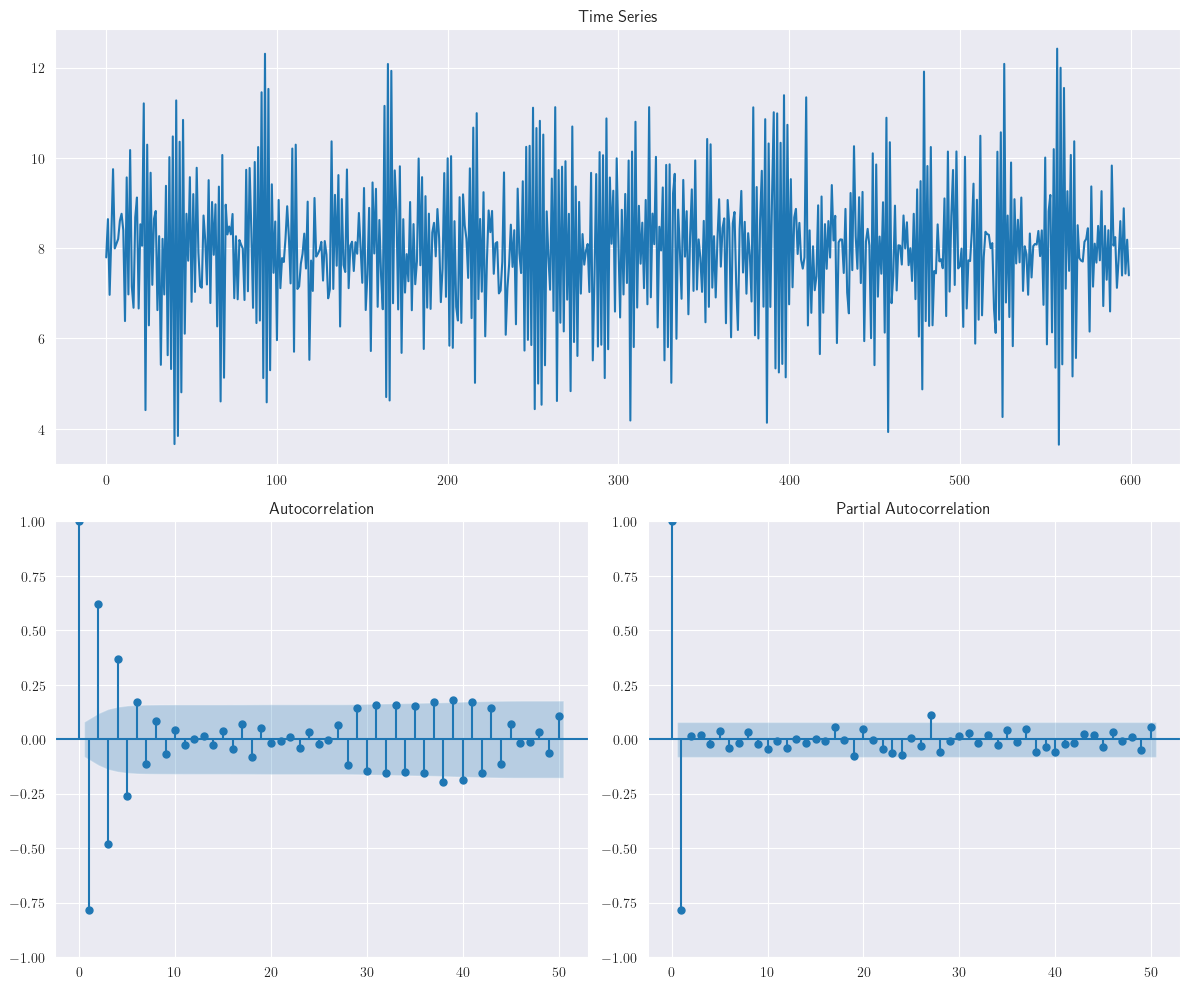

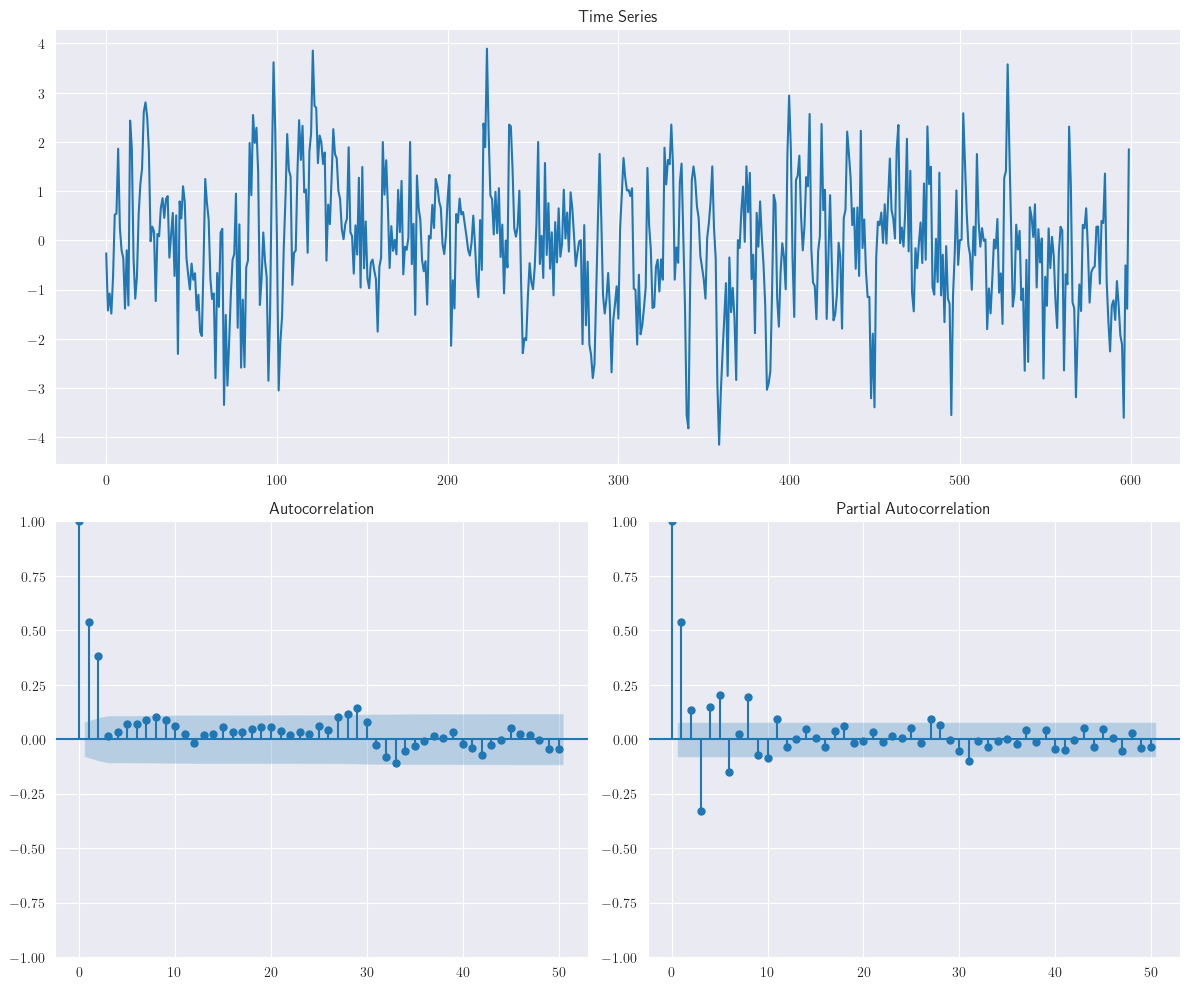

Analogamente, el siguiente gráfico corresponden al proceso \(MA(1)\): \(y_{t}=40+\varepsilon_{t}-0.8\varepsilon_{t-1}\). Podemos observar que las observaciones tienden a oscilar sucesivamente. Esto sugiere una autocorrelación negativa, como lo confirma el gráfico de la

ACFde la muestra.

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0]) # phi1, phi2,...

maparams = np.array([-0.8]) # theta1, theta2,...

intercept = 40

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

3.6. El Proceso de Media Móvil de Segundo Orden, \(MA(2)\)#

Media Móvil de Segundo Orden \(MA(2)\)

Otro proceso de media móvil de orden finito útil es \(MA(2)\), dado como

Las funciones de autocovarianza y autocorrelación para el modelo \(MA(2)\) se expresan como

Además, la función de autocorrelación está dada por

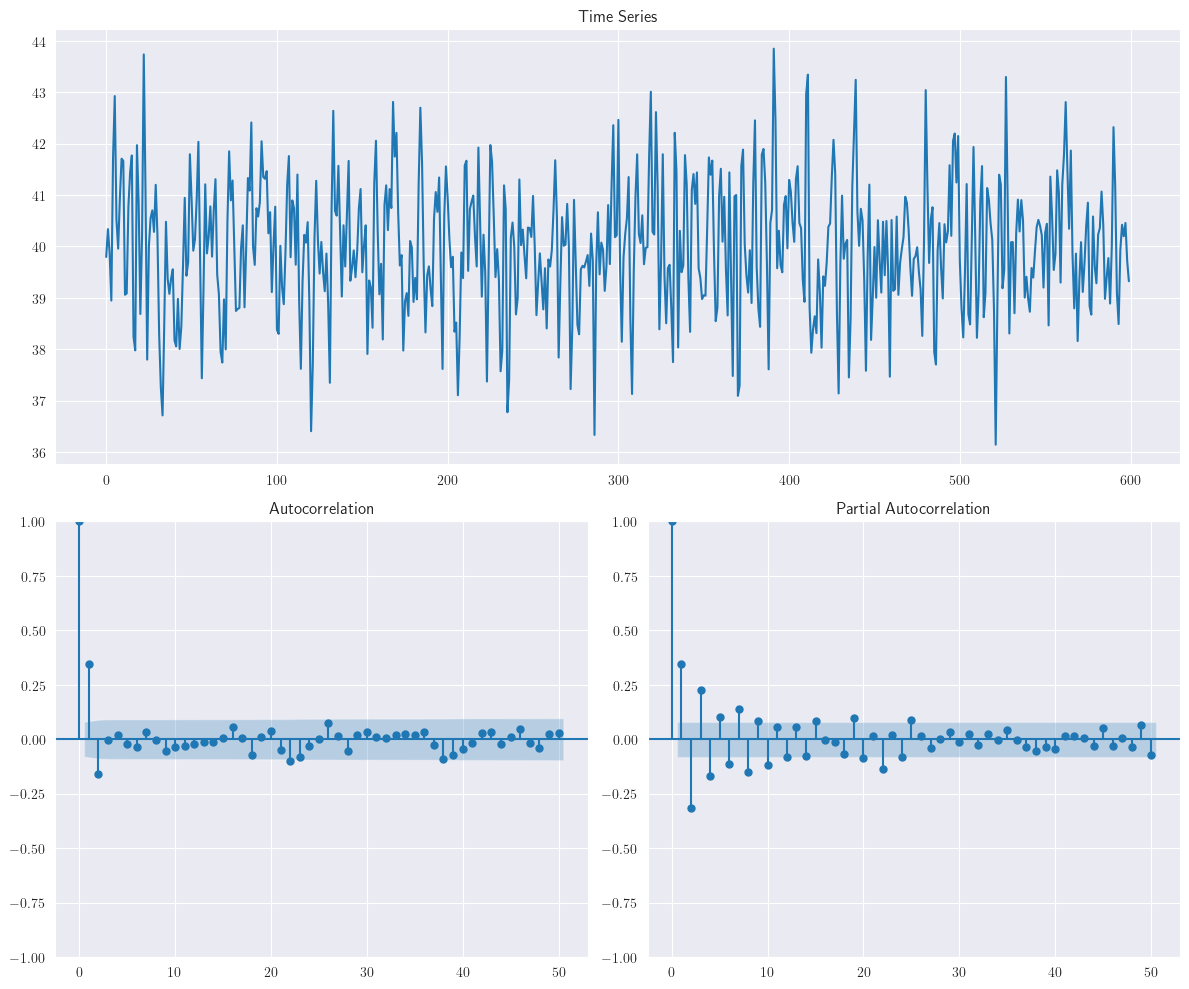

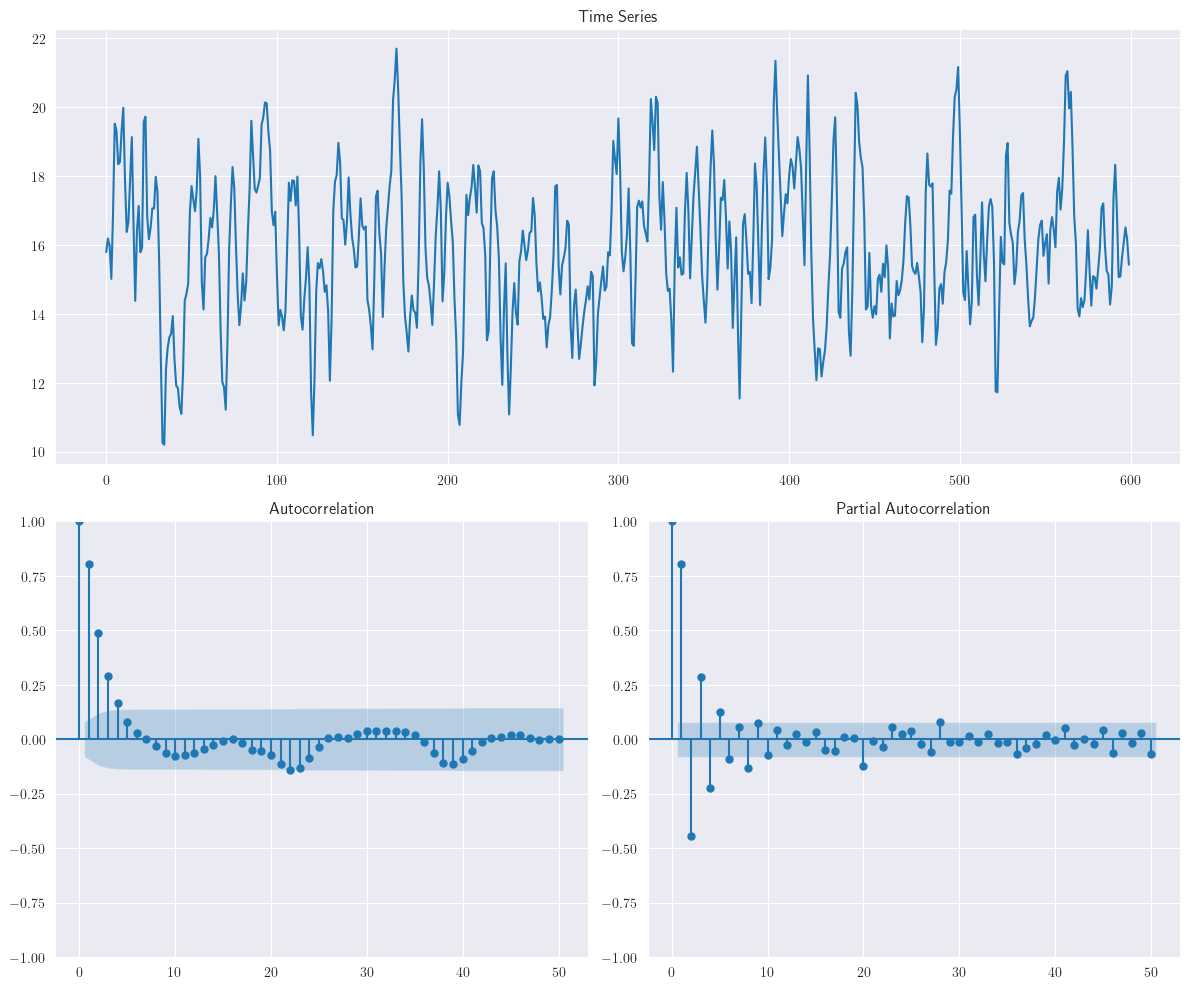

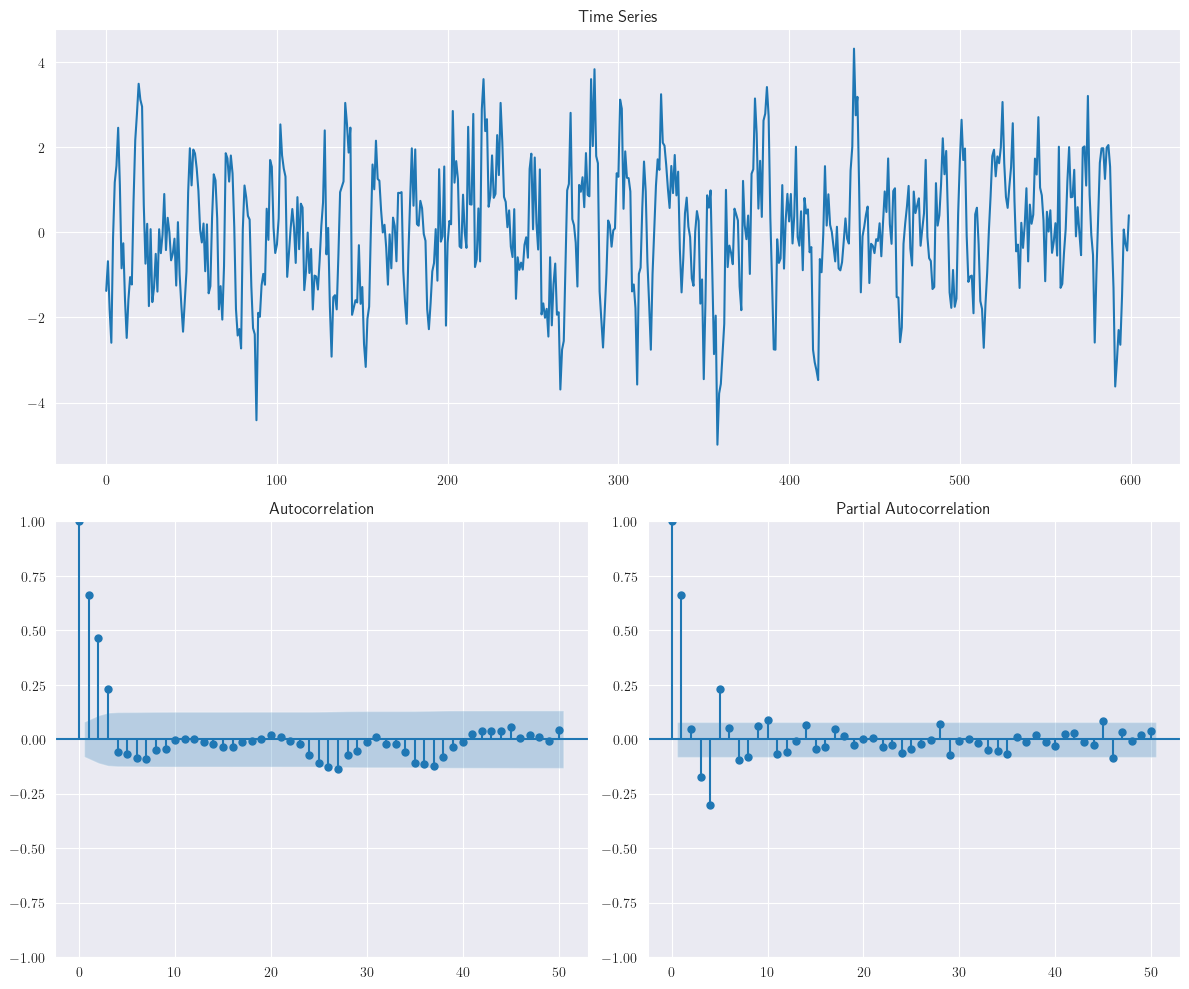

El siguiente gráfico muestra la serie temporal y la función de autocorrelación para la realización del modelo \(MA(2)\): \(y_{t}=40+\varepsilon_{t}+0.7\varepsilon_{t-1}-0.28\varepsilon_{t-2}\)

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0]) # phi1, phi2,...

maparams = np.array([0.7, -0.28]) # theta1, theta2,...

intercept = 40

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

Observe que la función de autocorrelación muestral se anula después del rezago 2.

Observación

El teorema de descomposición de Wold, es poderoso, pero no ayuda mucho en nuestros esfuerzos de modelado y pronóstico, ya que requiere implícitamente la estimación de infinitos pesos, \(\psi_{i}\). Discutiremos un caso especial de esta descomposición, asumiendo que el proceso de series temporales puede ser adecuadamente modelado al estimar solo un número finito de pesos y establecer el resto en cero.

Otra interpretación de los procesos

MAde orden finito es que, en cualquier momento, solo un número finito de perturbaciones pasadas “contribuyen” al valor actual de la serie temporal, y que la ventana temporal de los contribuyentes “se mueve”, haciendo que la perturbación “más antigua” sea obsoleta para la siguiente observación.

3.7. Procesos autorregresivos de orden finito#

Algunos procesos pueden tener las dinámicas intrínsecas mencionadas en la anterior observación, pero para otros, es posible que necesitemos considerar las contribuciones “persistentes” de las perturbaciones que ocurrieron en el pasado. Una solución a este problema son los modelos autorregresivos, en los cuales se asume que los infinitos pesos siguen un patrón distintivo y pueden ser representados con éxito con solo unos pocos parámetros. Ahora consideraremos algunos casos especiales de procesos autorregresivos.

3.8. Proceso autorregresivo de primer orden, \(AR(1)\)#

Theorem 3.3

Considere el siguiente proceso lineal estable, con serie de tiempo \({\varepsilon}_{t}\), ruido blanco,

\[ y_{t}=\mu+\sum_{i=0}^{\infty}\psi_{i}\varepsilon_{t-i}. \]Además, para garantizar decrecimiento exponencial, fije \(\psi_{i}=\phi^{i}\), donde \(|\phi|<1\).

Demuestre que el proceso autorregresivo de primer orden, está dado por

(3.9)#\[ y_{t}=\delta+\phi y_{t-1}+\varepsilon_{t}. \]Además, demuestre que si \(|\phi|>1\), existe una solución estacionaria para el proceso \(AR(1)\); sin embargo, esta solución es no-causal o no-convergente (requiere conocimiento sobre el futuro para hacer pronósticos sobre él).

Pruebe que, para el proceso \(AR(1)\), el valor esperado, covarianza y autocorrelación, están dados por

(3.10)#\[\begin{split} \begin{align*} \text{E}(y_{t}) &= \frac{\delta}{1-\phi}\\ \gamma(k) &= \sigma^{2}\phi^{k}\frac{1}{1-\phi^{2}},~\text{para}~k=0,1,2,\dots\\ \rho(k) &= \phi^{k},~\text{para}~k=0,1,2,\dots \end{align*} \end{split}\]

Demostración

Primero, volvamos a considerar la serie temporal dada en la Ecuación (3.3) asociada con el proceso lineal estable

\[ y_{t}=\mu+\sum_{i=0}^{\infty}\psi_{i}\varepsilon_{t-i}=\mu+\sum_{i=0}^{\infty}\psi_{i}B^{i}\varepsilon_{t}=\mu+\Psi(B)\varepsilon_{t}, \]donde \(\Psi(B)=\sum_{i=0}^{\infty}\psi_{i}B^{i}\).

Una manera de modelar esta serie temporal es asumir que las contribuciones de las perturbaciones que ocurrieron hace mucho tiempo deberían ser pequeñas en comparación con las perturbaciones más recientes experimentadas por el proceso. Dado que las perturbaciones son variables aleatorias independientes e idénticamente distribuidas, podemos simplemente asumir un conjunto de infinitas ponderaciones en magnitudes descendentes que reflejen la disminución en las contribuciones de las perturbaciones pasadas.

Un conjunto simple e intuitivo de estas ponderaciones pueden seguir un patrón de decaimiento exponencial. Para ello, estableceremos \(\psi_{i}=\phi^{i}\), donde \(|\phi|<1\) para garantizar el “decaimiento” exponencial. Con esta notación, las ponderaciones en las perturbaciones, comenzando desde la perturbación actual y retrocediendo en el tiempo, serán \(1, \phi, \phi^{2}, \phi^{3},\dots\).

Por lo tanto, la Ecuación (3.3) puede escribirse como:

De la Ecuación (3.11) obtenemos

(3.12)#\[ y_{t-1}=\mu+\textcolor{blue}{\varepsilon_{t-1}+\phi\varepsilon_{t-2}+\phi^{2}\varepsilon_{t-3}+\cdots} \]

Usando la Ecuación (3.11) y Ecuación (3.12)

(3.13)#\[\begin{split} \begin{align*} y_{t} &= \mu+\varepsilon_{t}+\phi\varepsilon_{t-1}+\phi^{2}\varepsilon_{t-2}+\cdots\\ &= \mu+\varepsilon_{t}+\phi(\textcolor{blue}{\varepsilon_{t-1}+\phi\varepsilon_{t-2}+\cdots})\\ &= \mu+\varepsilon_{t}+\phi(y_{t-1}-\mu)\\ &= \textcolor{red}{\mu-\phi\mu}+\phi y_{t-1}+\varepsilon_{t}\\ &= \textcolor{red}{\delta}+\phi y_{t-1}+\varepsilon_{t}, \end{align*} \end{split}\]donde \(\delta=(1-\phi)\mu\).

El proceso de la Ecuación (3.13) es llamado proceso autorregresivo de primer orden, \(AR(1)\), dado que Ecuación (3.13) puede verse como una regresión de \(y_{t}\) sobre \(y_{t-1}\), es por esto que se usa el término autorregresivo.

Observación

El supuesto de \(|\phi|<1\) conduce a ponderaciones que decaen exponencialmente en el tiempo y también garantiza que \(\sum_{i=0}^{\infty}|\psi_{i}|<\infty\). Esto significa que un proceso \(AR(1)\) es estacionario si \(|\phi|<1\).

Para \(|\phi|>1\), las perturbaciones pasadas obtendrán ponderaciones exponencialmente crecientes a medida que pasa el tiempo y la serie temporal resultante será explosiva. Este tipo de procesos son de poco interés práctico y, por lo tanto, solo consideran casos donde \(|\phi|=1\) y \(|\phi|<1\).

La solución en Ecuación (3.11) de hecho no converge para \(|\phi|>1\). Sin embargo, podemos reescribir el proceso \(AR(1)\) para \(y_{t+1}\) como \(y_{t+1}=\delta+\phi y_{t}+\varepsilon_{t+1}\). Entonces, por medio de operaciones de despeje en esta última igualdad, obtenemos

(3.14)#\[\begin{split} \begin{align*} y_{t} &= -\phi^{-1}\delta+\phi^{-1}y_{t+1}-\phi^{-1}\varepsilon_{t+1}\\ &=-\phi^{-1}\delta+\phi^{-1}(-\phi^{-1}\delta+\phi^{-1}y_{t+2}-\phi^{-1}\varepsilon_{t+2})-\phi^{-1}\varepsilon_{t+1}\\ &= -\phi^{-1}\delta-\phi^{-2}\delta+\phi^{-2}y_{t+2}-\phi^{-2}\varepsilon_{t+2}-\phi^{-1}\varepsilon_{t+1}\\ &= -(\phi^{-1}+\phi^{-2})\delta+\phi^{-2}y_{t+2}-\phi^{-1}\varepsilon_{t+1}-\phi^{-2}\varepsilon_{t+2}\\ &\hspace{2mm}\vdots\\ &=-\delta\sum_{i=1}^{\infty}\phi^{-i}-\sum_{i=1}^{\infty}\phi^{-i}\varepsilon_{t+i}. \end{align*} \end{split}\]

Nótese que para \(|\phi|>1\) se tiene que \(|\phi^{-i}|<1\). Por lo tanto, la solución vía \(AR(1)\) es estacionaria para \(|\phi|>1\). Sin embargo, la solución dada por la Ecuación (3.14) involucra futuras perturbaciones, las cuales deseamos predecir, lo cual es impráctico. Este tipo de modelos son conocidos como, modelos no-causales.

Calculemos ahora, la media del proceso estacionario \(AR(1)\). Nótese que

(3.15)#\[ \text{E}(y_{t})=\text{E}(\delta+\phi y_{t-1}+\varepsilon_{t})=\delta+\phi\text{E}(y_{t-1})+\text{E}(\varepsilon_{t})=\delta+\phi\text{E}(y_{t-1}) \]

Dado que el proceso \(AR(1)\) es estacionario \(\text{E}(y_{t})=\text{E}(y_{t-1})\). Entonces, despejando en la Ecuación (3.15), obtenemos que la media del proceso \(AR(1)\) está dada por

\[ \text{E}(y_{t})=\frac{\delta}{1-\phi}. \]

Por otro lado, para calcular autocovarianza del proceso \(AR(1)\), nótese que, gracias a su estacionariedad se tiene que

\[ \gamma(0)=\text{Var}(y_{t})=\text{Var}(\delta+\phi y_{t-1}+\varepsilon_{t})=\phi^{2}\text{Var}(y_{t-1})+\sigma^{2}=\phi^{2}\gamma(0)+\sigma^{2} \]

Por lo tanto, \(\gamma(0)=\sigma^{2}/(1-\phi^{2})\). Analicemos la covarianza \(\gamma(k)\), para algunos pocos valores de rezagos, usando sus propiedades (ver Covariance), para realizar un razonamiento por inducción. Nótese que para \(k=1, 2,\dots,k\), dado que el ruido blanco \(\varepsilon_{t+1}\) iid es independiente de \(y_{t}\) (\(y_{t}\) depende de \(\varepsilon_{t}\)), se tiene que

Además, la función de autocorrelación para el proceso \(AR(1)\) está dada por

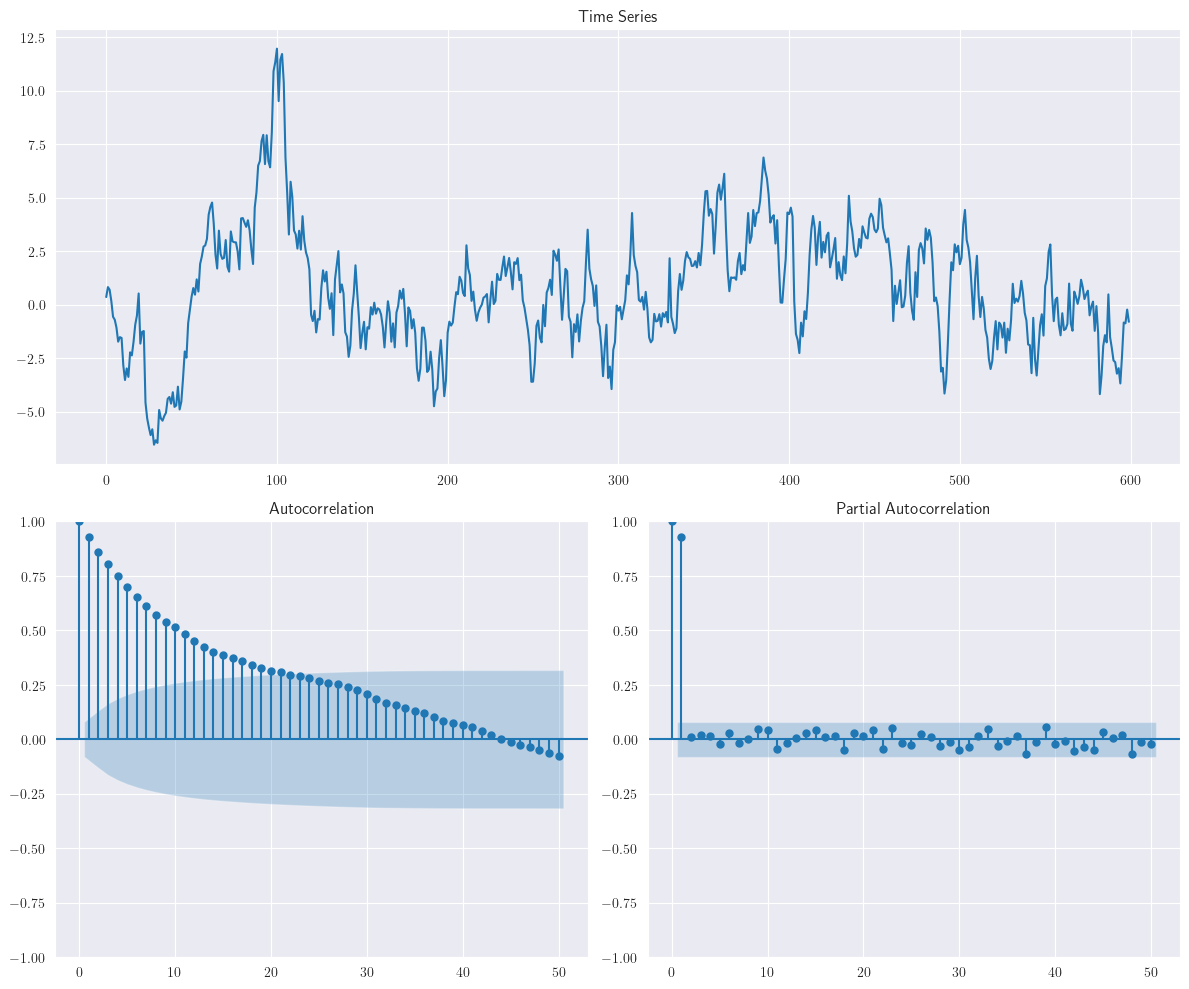

Por lo tanto, la función de autocorrelación para un proceso \(AR(1)\) tiene forma de decaimiento exponencial. Una realización del siguiente modelo \(AR(1)\),

\[ y_{t}=8+0.8y_{t-1}+\varepsilon_{t} \]se muestra en la siguiente figura:

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0.8]) # phi1, phi2,...

maparams = np.array([0]) # theta1, theta2,...

intercept = 8

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

Al igual que en el modelo \(MA(1)\) con \(\theta = −0.8\), podemos observar algunos cortos períodos durante los cuales las observaciones tienden a moverse en dirección ascendente o descendente. A diferencia del modelo \(MA(1)\), sin embargo, la duración de estos períodos tiende a ser más larga y la tendencia tiende a persistir. Esto también puede observarse en el gráfico de la función de autocorrelación (

ACF) de la muestra.

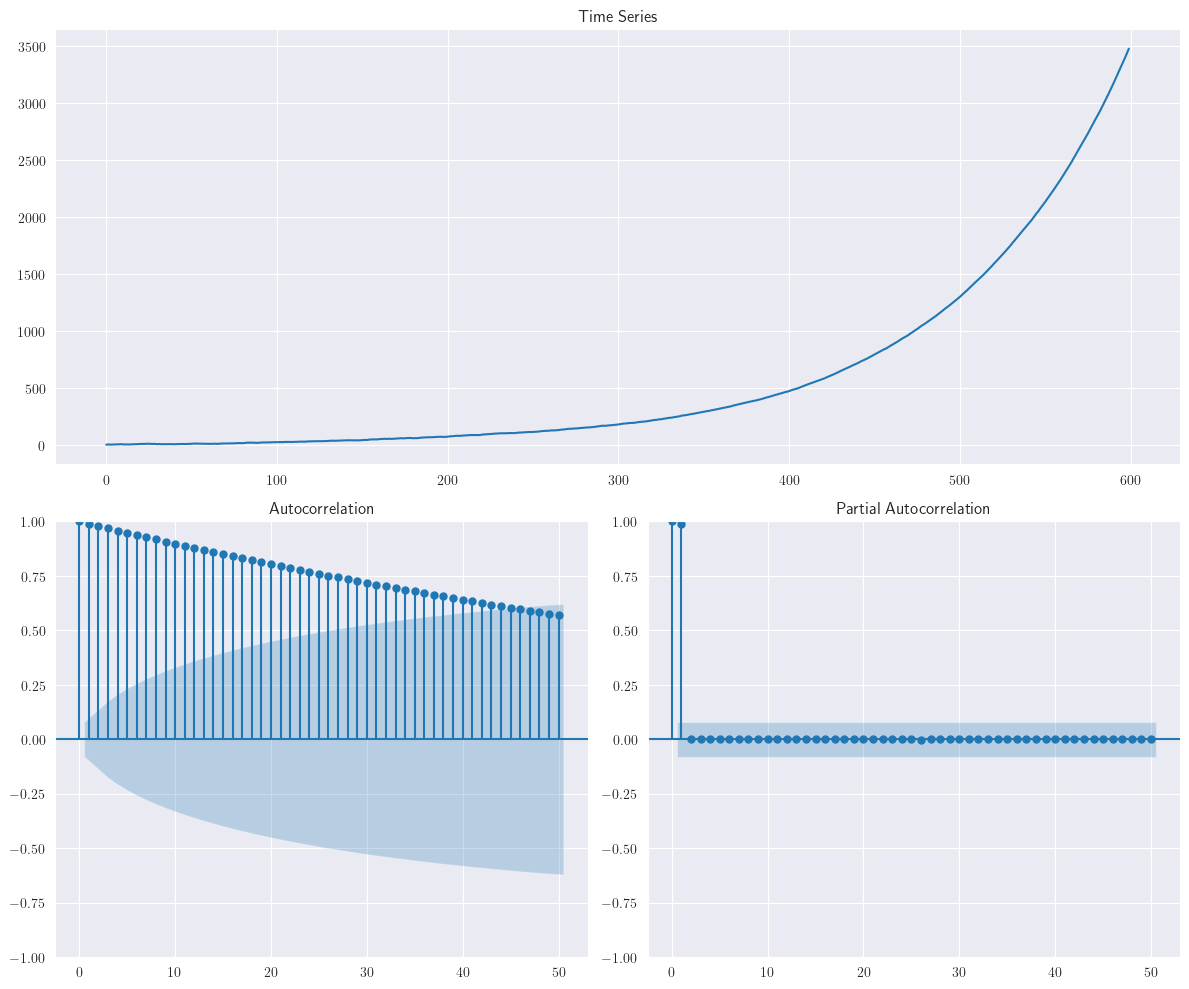

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([-0.8]) # phi1, phi2,...

maparams = np.array([0]) # theta1, theta2,...

intercept = 8

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

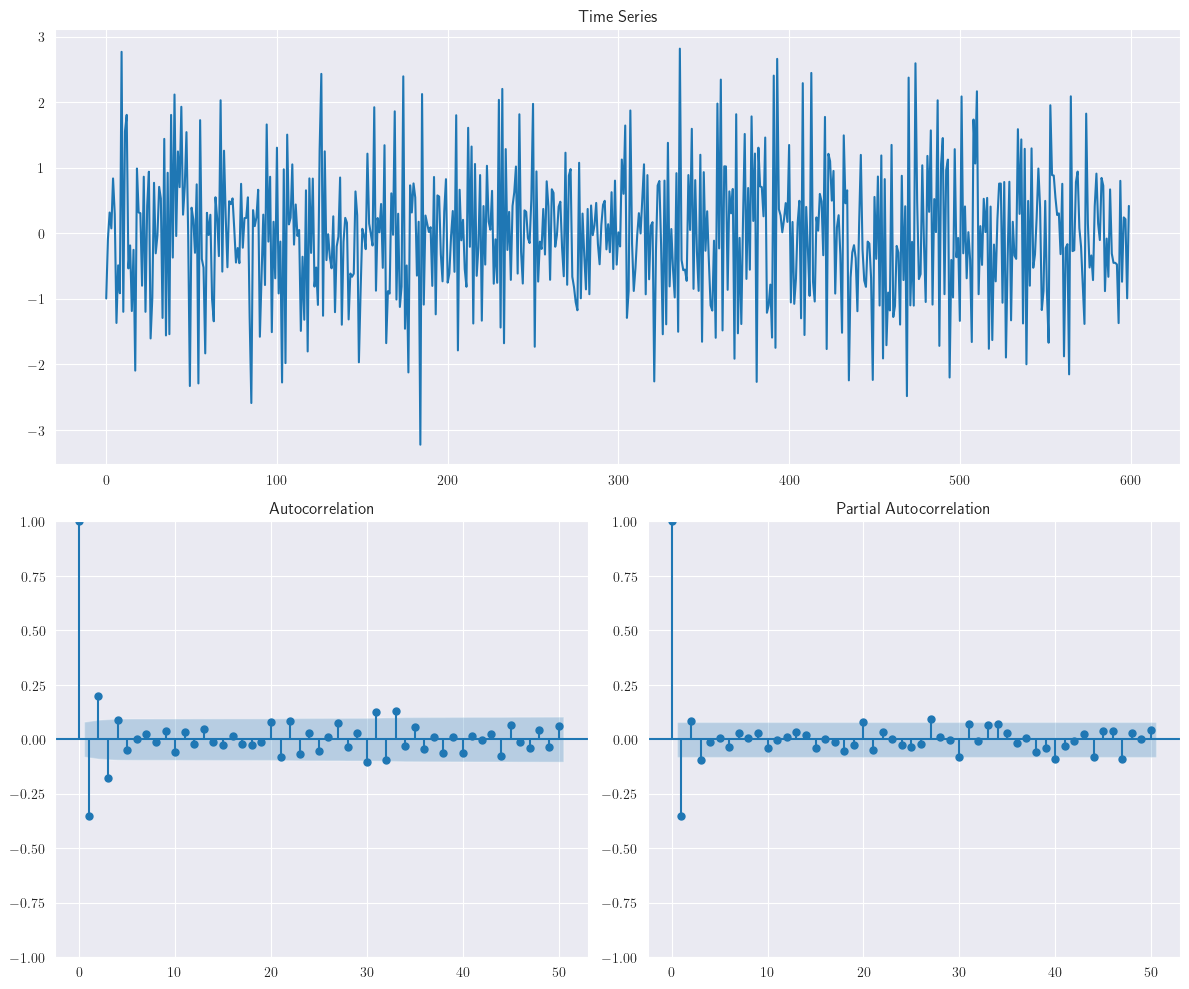

plotds(ar1_data)

La figura anterior muestra una realización del modelo \(AR(1)\) \(y_{t} = 8 − 0.8y_{t-1} + \varepsilon_{t}\). Observamos que en lugar de secuencias persistentes, las observaciones exhiben movimientos volatiles hacia arriba/abajo debido al valor negativo de \(\Phi\).

3.9. Proceso autorregresivo de segundo orden, \(AR(2)\)#

Theorem 3.4

La clara extensión de la Ecuación (3.9) incluye la observación \(y_{t-2}\) y define el proceso autorregresivo de segundo orden \(AR(2)\) como

Demuestre que el proceso \(AR(2)\) es estacionario si los parámetros \(\phi_{1}, \phi_{2}\) satisfacen

Además,

Más aún, las raíces de las ecuaciones de Yule-Walker muestran combinación de dos términos: decaimiento exponencial y forma sinusoidal amortiguada.

Demostración

Nótese que la Ecuación (3.16) puede reescribirse como

\[ y_{t}=\delta+\phi_{1}By_{t}+\phi_{2}B^{2}y_{t}+\varepsilon_{t}\Rightarrow(1-\phi_{1}B-\phi_{2}B^{2})y_{t}=\delta+\varepsilon_{t}\Rightarrow\Phi(B)y_{t}=\delta+\varepsilon_{t}. \]

Aplicando el operador inverso \(\Phi(B)^{-1}\) en ambos miembros de la igualdad se tiene

Dado que \(\Psi(B)=\Phi(B)^{-1}\) entonces \(\Phi(B)\Psi(B)=1\), esto es

\[\begin{split} \begin{align*} (1-\phi_{1}B-\phi_{2}B^{2})(\psi_{0}+\psi_{1}B+\psi_{2}B^{2}+\cdots) &= 1\Leftrightarrow\\ \psi_{0}+(\psi_{1}-\phi_{1}\psi_{0})B+(\psi_{2}-\phi_{1}\psi_{1}-\phi_{2}\psi_{0})B^{2}+\cdots+(\psi_{j}-\phi_{1}\psi_{j-1}-\phi_{2}\psi_{j-2})B^{j} &= 1\Leftrightarrow \end{align*} \end{split}\]

Ecuación en diferencias lineal homogénea de orden \(n\)

Una ecuación en diferencias lineal homogénea de orden \(n\) está dada por

(3.20)#\[ y(t+n)+a_{1}y(t+n-1)+\cdots+a_{n-1}y(t+1)+a_{n}y(t)=0,~\text{con}~a_{i}\in\mathbb{R}, \]\(\forall i~\text{y}~a_{n}\neq0\).

A la siguiente ecuación

(3.21)#\[ P(r)=m^{n}+a_{1}m^{n-1}+a_{2}m^{n-2}+\cdots+a_{n-1}m+a_{n}=0, \]la llamamos ecuación característica asociada a la ecuación en diferencias lineal homogénea de orden \(n\) (3.20).

Para encontrar soluciones homogéneas no triviales, asumimos soluciones de la forma \(\psi_{j}=Am^{j}\), \(~A, m\in\mathbb{R}\setminus\{0\}\). Entonces la ecuación característica asociada a la Ecuación (3.19) tomaría la forma

\[ \psi_{j}-\phi_{1}\psi_{j-1}-\phi_{2}\psi_{j-2}=Am^{j}-\phi_{1}Am^{j-1}-\phi_{2}Am^{j-2}=0\Leftrightarrow m^{2}-\phi_{1}m-\phi_{2}=0. \]

Las raíces son obtenidas por medio del uso de la fórmula general. Estudiaremos tres casos para sus posibles raíces

Nótese que si \(|m_{i}|<1,~i=1,2\) entonces \(\sum_{i=0}^{\infty}|\psi_{i}|<\infty\). Por lo tanto, el modelo sería causal estacionario. Además, si las raices de la Ecuación (3.22) son complejas, esto es, de la forma \(a+bi,~i=\sqrt{-1}\), la estacionariedad se tendría si

\[ |a+bi|=\sqrt{a^{2}+b^{2}}<1 \]

Además, bajo estas condiciones \(\{y_{t}\}_{t}\) tendría una representación como \(MA\) infinito (ver Ecuación (3.4)). Dado que se tiene estacionariedad si \(|m_{i}|<1,~i=1,2\), entonces

\[ -1<\frac{\phi_{1}\pm\sqrt{\phi_{1}^{2}+4\phi_{2}}}{2}<1\Leftrightarrow-2<\phi_{1}\pm\sqrt{\phi_{1}^{2}+4\phi_{2}}<2. \]

Analicemos el valor más grande de \(m_{i},~i=1,2\), el cual es acotado por \(\phi_{1}+\sqrt{\phi_{1}^{2}+4\phi_{2}}<2\)

(3.23)#\[\begin{split} \begin{align*} \phi_{1}+\sqrt{\phi_{1}^{2}+4\phi_{2}}<2 &\Rightarrow \sqrt{\phi_{1}^{2}+4\phi_{2}}<2-\phi_{1}\\ &\Rightarrow\phi_{1}^{2}+4\phi_{2}<(2-\phi_{1})^{2}\\[1mm] &\Rightarrow\phi_{1}^{2}+4\phi_{2}<4-4\phi_{1}+\phi_{1}^{2}\\[2mm] &\Rightarrow\textcolor{red}{\phi_{1}+\phi_{2}<1}. \end{align*} \end{split}\]

Usando la otra desigualdad \(-2<\phi_{1}\pm\sqrt{\phi_{1}^{2}+4\phi_{2}}\), se tiene que (

verifíquelo)(3.24)#\[ \textcolor{red}{\phi_{2}-\phi_{1}<1}. \]

Nótese que si \(m_{i}\) es una raíz compleja, entonces: \(\phi_{1}^{2}+4\phi_{2}<0\Leftrightarrow\phi_{1}^{2}<-4\phi_{2}\), y además

\[ m_{1,2}=\frac{\phi_{1}}{2}\pm\frac{\sqrt{-\left(\phi_{1}^{2}+4\phi_{2}\right)}}{2}i. \]

Por lo tanto, el módulo complejo está dado por

Entonces, se tiene estabilidad si \(|m_{i}|<1\), esto es, si \(-\phi_{2}<1\Rightarrow\phi_{2}>-1\). Las Ecuaciones (3.23)-(3.24) entregan vía método de eliminación que \(\phi_{2}<1\), por lo tanto, \(\textcolor{red}{|\phi_{2}|<1}\). De esta forma, las condiciones de estacionariedad son las siguientes:

\[\begin{split} \begin{align*} \phi_{1}+\phi_{2} &< 1\\ \phi_{2}-\phi_{1} &< 1\\ |\phi_{2}| &< 1 \end{align*} \end{split}\]

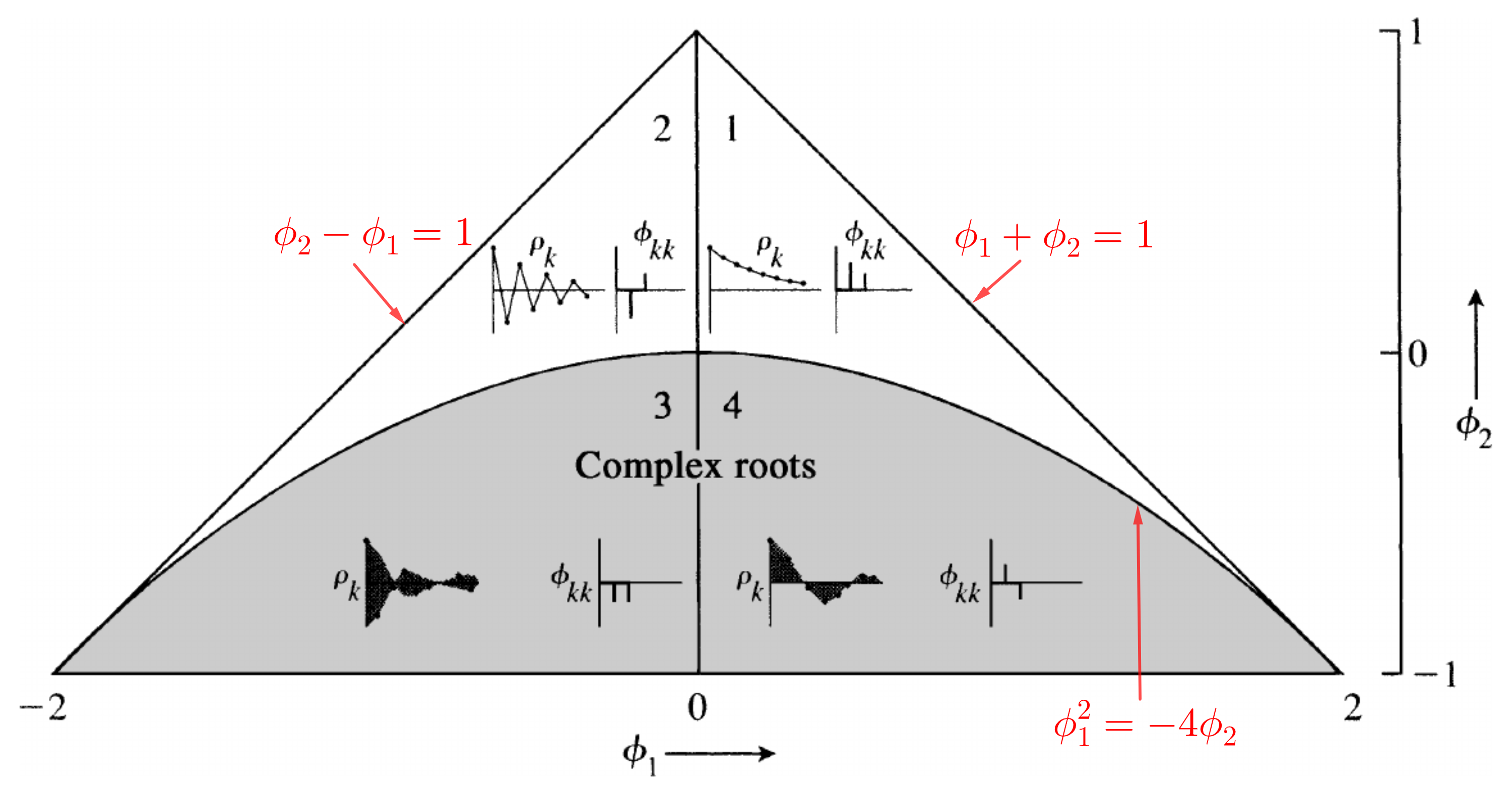

Fig. 3.1 Funciones típicas de autocorrelación y autocorrelación parcial \(\rho_{k}\) y \(\phi_{kk}\) para varios modelos \(AR(2)\) estacionarios. (Fuente: [Stralkowski, 1968]).#

Procedemos a calcular ahora, media y autocovarianza. Si se satisface la Ecuación (3.17), el proceso \(AR(2)\) es estacionario, y, por lo tanto,

Nótese que si \(1-\phi_{1}-\phi_{2}=0\) entonces \(m=1\) es solución de \(m^{2}-\phi_{1}m-\phi_{2}=0\), y, por lo tanto, la serie se considera no estacionaria. Calculemos ahora la autocovarianza

Entonces, si \(k=0\), se tiene que \(\gamma(0)=\phi_{1}\gamma(1)+\phi_{2}\gamma(2)+\sigma^{2}\) (

¿por qué?) y además(3.25)#\[ \gamma(k)=\phi_{1}\gamma(k-1)+\phi_{2}\gamma(k-2). \]

Las Ecuaciones en (3.25) se llaman las Ecuaciones de Yule-Walker para \(\gamma(k)\). De manera similar, podemos obtener la función de autocorrelación al dividir la Ecuación (3.25) por \(\gamma(0)\):

(3.26)#\[\begin{split} \begin{align*} \rho(k) &= \frac{\gamma(k)}{\gamma(0)}\\ &= \phi_{1}\frac{\gamma(k-1)}{\gamma(0)}+\phi_{2}\frac{\gamma(k-2)}{\gamma(0)}\\[2mm] &= \phi_{1}\rho(k-1)+\phi_{2}\rho(k-2),~k=1,2,\dots \end{align*} \end{split}\]

Las Ecuaciones de Yule-Walker para \(\rho(k)\) en Ecuación (3.26) pueden ser resueltas de manera iterativa

Considerando \(\rho(j)=Am^{j},~A, m\in\mathbb{R}\setminus\{0\}\) entonces, la Ecuación Característica asociada a la Ecuación (3.27) puede ser escrita como

\[ Am^{j}=\phi_{1}Am^{j-1}+\phi_{2}Am^{j-2}\Leftrightarrow m^{2}-\phi_{1}m-\phi_{2}=0. \]

Ecuación característica

Si \(m_{0}\) es solución de la ecuación característica (3.21), entonces \(y_{t}=Am_{0}^{t}\) es solución de (3.20)

Al resolver la ecuación característica pueden ocurrir los siguientes casos:

La ecuación característica (3.21) tiene todas sus raíces reales y simples \(m_{1}, m_{2},\dots, m_{n}\), entonces

\[ y_{h}(t)=c_{1}m_{1}^{t}+c_{2}m_{2}^{t}+\cdots+c_{n}m_{n}^{t} \]La ecuación característica (3.21) tiene todas sus raíces reales: \(m_{1}\) con multiplicidad, \(k\) y \(m_{k+1}, \dots, m_{n}\) simples, entonces

\[ y_{h}(t)=c_{1}m_{1}^{t}+c_{2}tm_{1}^{t}+\cdots+c_{k}t^{k-1}m_{1}^{t}+c_{k+1}t^{k}m_{k+1}^{t}+\cdots+c_{n}m_{n}^{t}. \]La ecuación característica (3.21) tiene raíces complejas simples. Si \(m_{1,2}=\alpha\pm\beta i\), son raices complejas conjugadas, siendo \(\rho=\sqrt{\alpha^{2}+\beta^{2}}\) el módulo y \(\theta=\textsf{arctan}(\beta/\alpha)\) el argumento correspondiente, entonces la solución asociada a las raíces \(m_{1}, m_{2}\) es

\[ y_{h}(t)=\rho^{t}(A\cos(\theta t)+B\sin(\theta t)). \]

Si \(m_{1}, m_{2}\) son raíces reales distintas, tenemos que

\[ \rho(k)=c_{1}m_{1}^{k}+c_{2}m_{2}^{k},~k=1,2,\dots \]donde \(c_{1}, c_{2}\) son constantes y pueden ser obtenidas a partir de \(\rho(0), \rho(1)\). Dado que \(|m_{1,2}|<1\) por estacionariedad, la autocorrelación es una combinación de términos de decrecimiento exponencial.

Si \(m_{1}, m_{2}\) son raíces complejas conjugadas de la forma \(a\pm bi\) entonces las raíces son de la forma

\[ \rho(k)=R^{k}(c_{1}\cos(mk)+c_{2}\sin(mk)),~k=0,1,2,\dots \]donde \(R=|m_{i}|=\sqrt{a^{2}+b^{2}},~i=1,2\), y \(\lambda\) es determinado por \(\cos(m)=a/R\) y \(\sin(m)=b/R\). Por lo tanto, \(a+bi=R(\cos(m)\pm\sin(m)i)\). Donde \(c_{1}, c_{2}\) son constantes. La función \(ACF\) en este caso tiene la forma de frecuencia senosoidal con factor de frecuencia \(R\) y frecuencia \(m\). Esto es, periodo \(2\pi/\lambda\).

Existe una sola raíz real (raíz doble) \(m_{1}=m_{2}=m_{0}\), entonces

\[ \rho(k)=(c_{1}+c_{2}k)m_{0}^{k},~k=0,1,2,\dots \]En este caso, la \(ACF\) exhibe un patrón de decrecimiento exponencial.

En el Caso 1, por ejemplo, un modelo AR(2) puede ser visto como un modelo AR(1) “ajustado” para el cual una única expresión de decaimiento exponencial como en el modelo \(AR(1)\) no es suficiente para describir el patrón en la ACF, y, por lo tanto, una expresión adicional de decaimiento exponencial se “agrega” al introducir el término de retardo de segundo orden, \(y_{t−2}\).

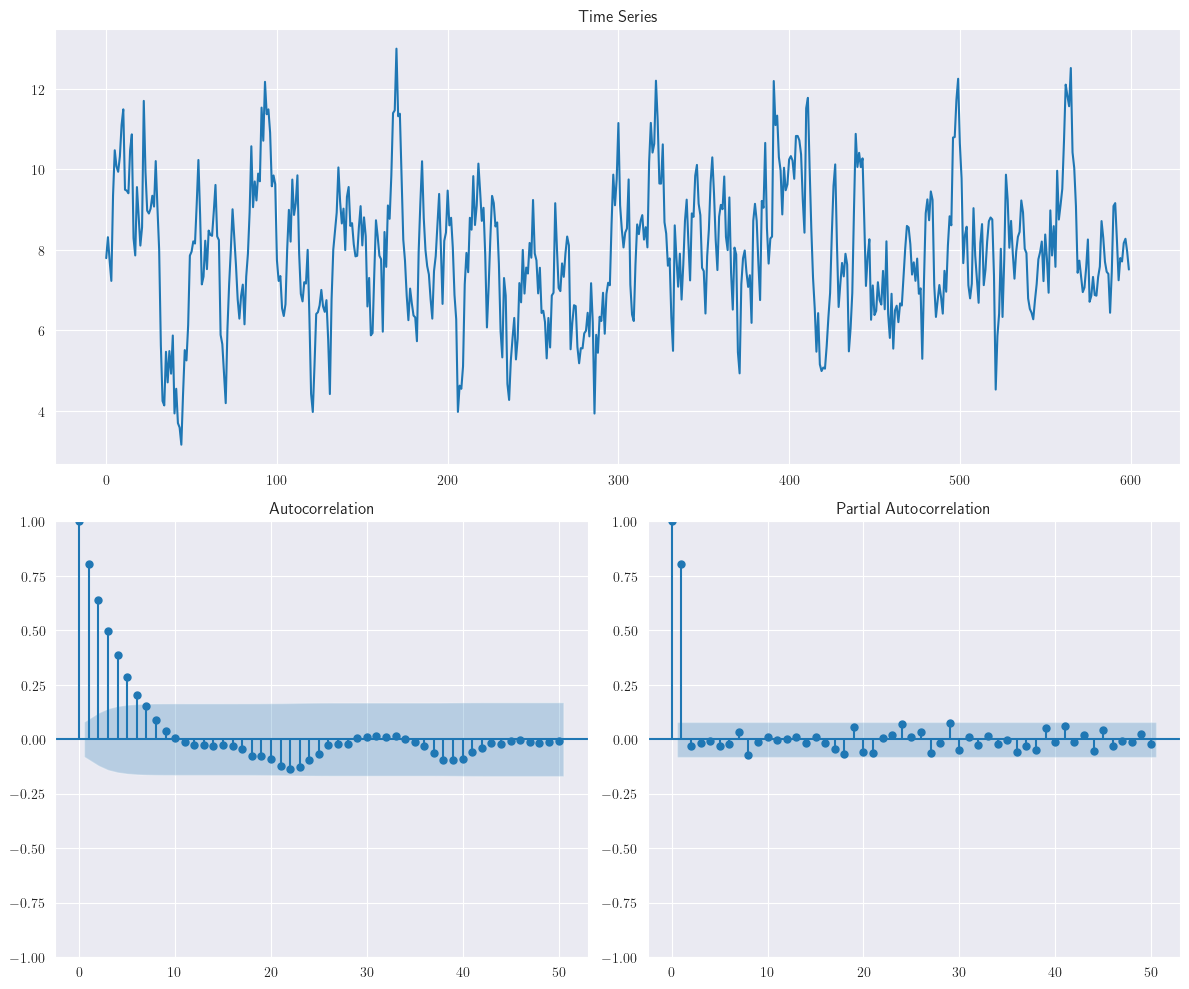

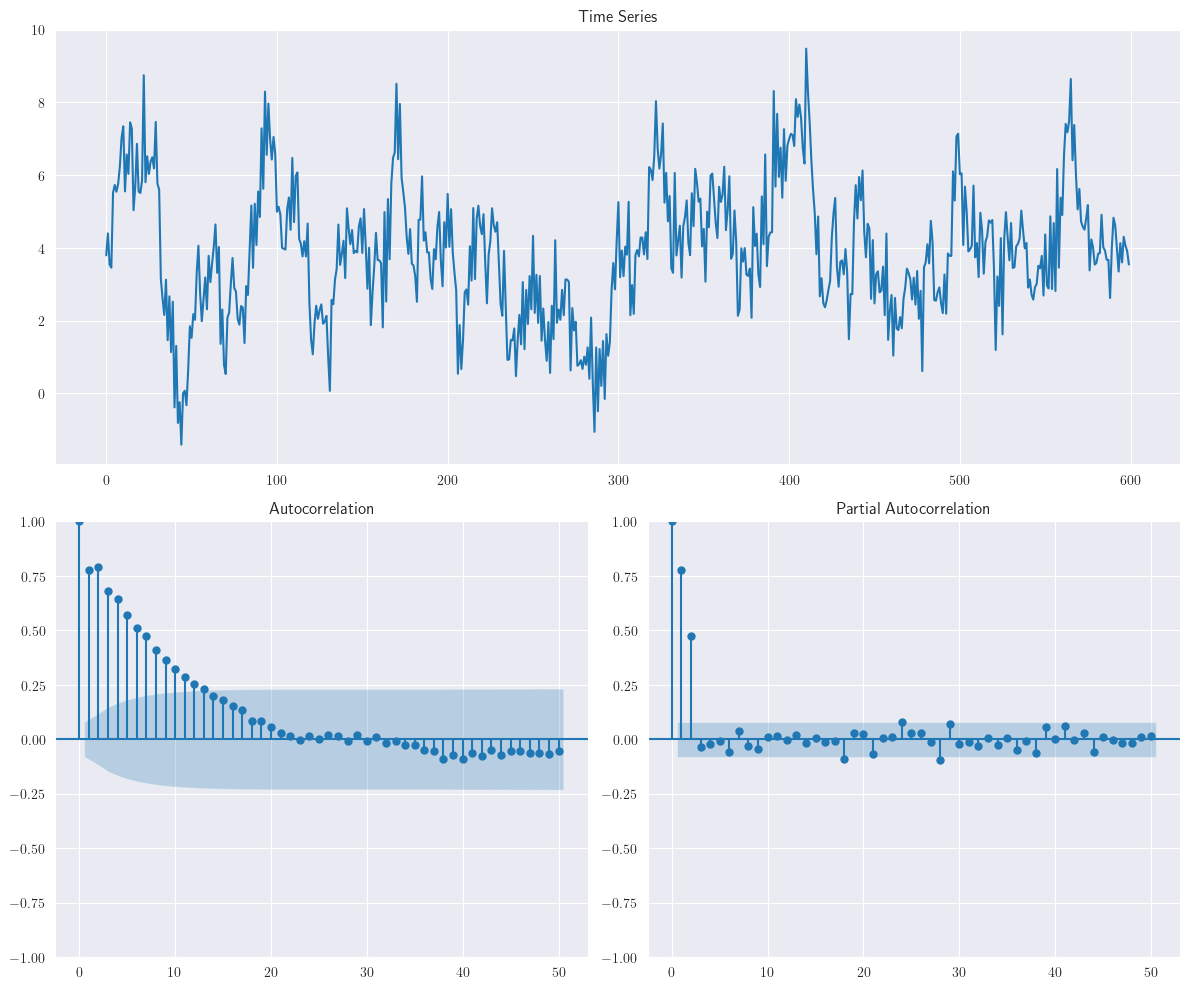

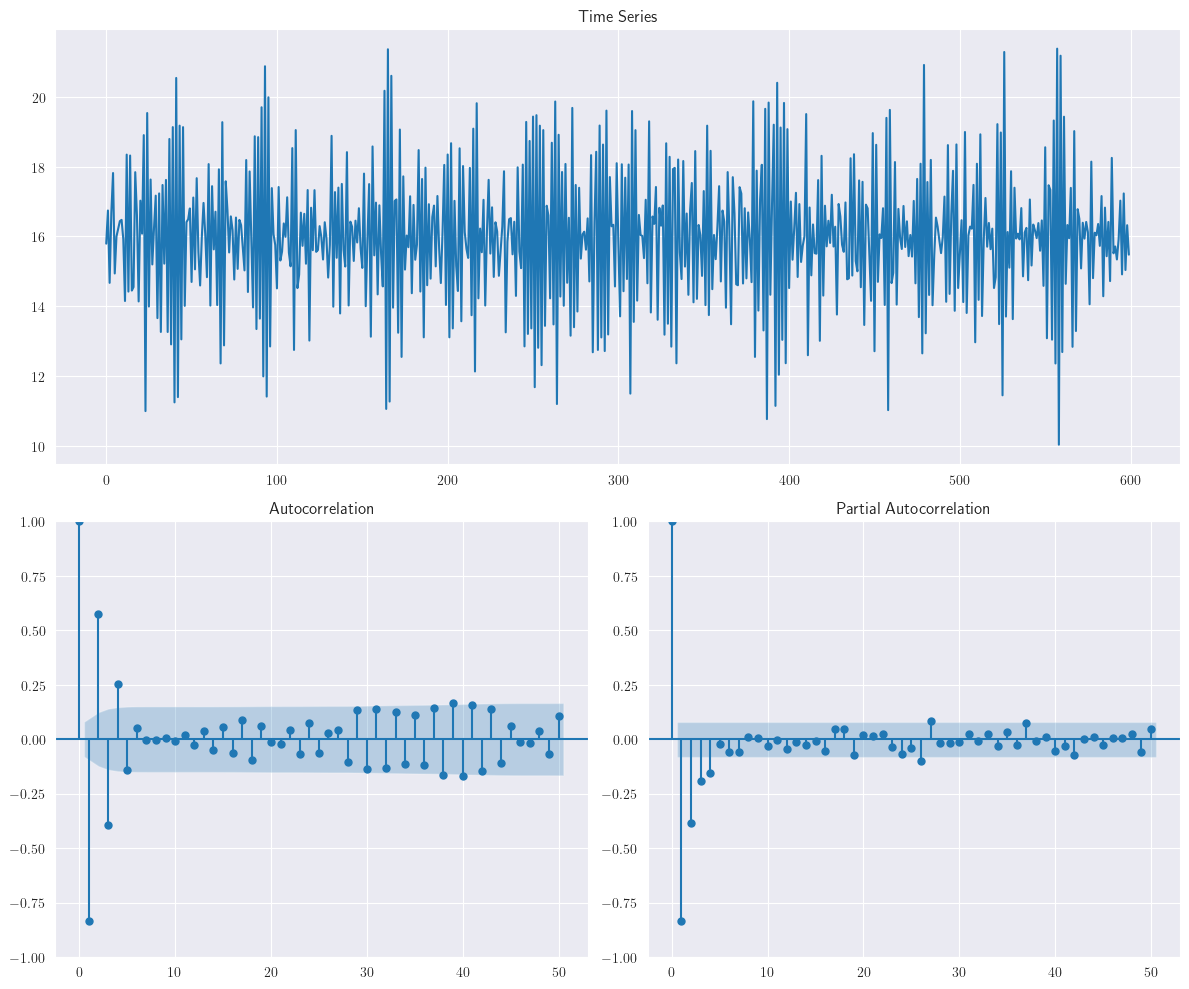

La siguiente figura muestra la realización del proceso \(AR(2)\): \(y_{t}=4+0.4y_{t-1}+0.5y_{t-2}+\varepsilon_{t}\).

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0.4, 0.5]) # phi1, phi2,...

maparams = np.array([0]) # theta1, theta2,...

intercept = 4

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

Tenga en cuenta que las raíces del polinomio asociado a este modelo son reales. Por lo tanto, la ACF es una mezcla de dos términos de decaimiento exponencial. De manera similar, la siguiente figura muestra una realización del siguiente proceso \(AR(2)\): \(y_{t}=4+0.4y_{t-1}-0.5y_{t-2}+\varepsilon_{t}\)

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0.4, -0.5]) # phi1, phi2,...

maparams = np.array([0]) # theta1, theta2,...

intercept = 4

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

Para este proceso, las raíces del polinomio asociado son complejas conjugadas. Por lo tanto, el gráfico de la función de autocorrelación (ACF) muestra un comportamiento de sinusoides amortiguadas.

3.10. Proceso autorregresivo general, \(AR(p)\)#

En las dos secciones anteriores, se presenta un modelo \(AR\) general de orden \(p\)

(3.28)#\[ y_{t}=\delta+\phi_{1}y_{t-1}+\phi_{2}y_{t-2}+\cdots+\phi_{p}y_{t-p}+\varepsilon_{t} \]donde \(\varepsilon_{t}\) es ruido blanco.

Otra representación de la Ecuación (3.28) se puede dar como

\[ \Phi(B)y_{t}=\delta+\varepsilon_{t} \]donde \(\Phi(B)=1-\phi_{1}B-\phi_{2}B^{2}-\cdots-\phi_{p}B^{p}\).

La serie temporal \(AR(p)\), \(\{y_{t}\}\) en la Ecuación (3.28) es causal y estacionaria si las raíces del polinomio asociado

(3.29)#\[ m^{p}-\phi_{1}m^{p-1}-\phi_{2}m^{p-2}-\cdots-\phi_{p}=0 \]son menores que uno, en valor absoluto.

Además, bajo esta condición, la serie temporal \(\{y_{t}\},~ AR(p)\) también se dice que tiene una representación \(MA\) infinita, absolutamente sumable

(3.30)#\[ y_{t}=\mu+\Psi(B)\varepsilon_{t}=\mu+\sum_{i=0}^{\infty}\psi_{i}\varepsilon_{t-i}, \]donde \(\Psi(B)=\Phi(B)^{-1}\) con \(\sum_{i=0}^{\infty}|\psi_{i}|<\infty\).

Al igual que en \(AR(2)\), los pesos de los choques aleatorios en la Ecuación (3.30) pueden obtenerse de \(\Phi(B)\Psi(B)=1\) como

\[\begin{split} \begin{align*} \psi_{j} &= 0,~ j<0\\ \psi_{0} &= 1\\ \psi_{j}-\phi_{1}\psi_{j-1}-\phi_{2}\psi_{j-2}-\cdots-\phi_{p}\psi_{j-p} &=0~\forall~j=1,2,\dots \end{align*} \end{split}\]

Podemos mostrar fácilmente que, para el proceso \(AR(p)\) estacionario

\[ \text{E}(y_{t})=\mu=\frac{\delta}{1-\phi_{1}-\phi_{2}-\cdots-\phi_{p}} \]y

(3.31)#\[\begin{split} \begin{align*} \gamma(k) &= \text{Cov}(y_{t}, y_{t-k})\\[5mm] &= \text{Cov}(\delta+\phi_{1}y_{t-1}+\phi_{2}y_{t-2}+\cdots+\phi_{p}y_{t-p}+\varepsilon_{t}, y_{t-k})\\[2mm] &= \sum_{i=1}^{p}\phi_{i}\text{Cov}(y_{t-i}, y_{t-k})+\text{Cov}(\varepsilon_{t}, y_{t-k})\\ &= \sum_{i=1}^{p}\phi_{i}\gamma(k-i)+\begin{cases}\sigma^{2} & \text{si}~k=0\\0 & \text{si}~k>0\end{cases} \end{align*} \end{split}\]

Por lo tanto, tenemos

Al dividir la Ecuación (3.31) por \(\gamma(0)\) para \(k > 0\), se puede observar que la función de autocorrelación (ACF) de un proceso \(AR(p)\) satisface las ecuaciones de Yule–Walker

Las Ecuaciones (3.32) son ecuaciones lineales de orden \(p\), lo que implica que la función de autocorrelación (ACF) para un modelo \(AR(p)\) se puede encontrar a través de las \(p\) ***raíces del polinomio asociado con la Ecuación (3.29). Por ejemplo, si todas las raíces son distintas y reales, tenemos

\[ \rho(k)=c_{1}m_{1}^{k}+c_{2}m_{2}^{k}+\cdots+c_{p}m_{p}^{k},~k=1,2,\dots \]donde \(c_{1}, c_{2},\dots, c_{p}\) son constantes particulares.

Sin embargo, en general, las raíces pueden no ser todas distintas o reales. Por lo tanto, la función de autocorrelación (ACF) de un proceso \(AR(p)\) puede ser una mezcla de expresiones de decaimiento exponencial y de seno amortiguado dependiendo de las raíces de la Ecuación (3.29).

3.11. Función de Autocorrelación Parcial, \(PACF\)#

Introducción

En la sección anterior vimos que la función de autocorrelación (ACF) es una herramienta excelente para identificar el orden de un proceso \(MA(q)\), ya que se espera que “corte” después del rezago \(q\). Sin embargo, en la sección anterior, señalamos que la \(ACF\) no es tan útil en la identificación del orden de un proceso \(AR(p)\), porque probablemente tendrá una mezcla de expresiones de decaimiento exponencial y de seno amortiguado.

Por lo tanto, dicho comportamiento, aunque indica que el proceso podría tener una estructura \(AR\), no proporciona información adicional sobre el orden de dicha estructura. Para ello, definiremos y utilizaremos la función de autocorrelación parcial (PACF) de la serie temporal. Pero antes de eso, discutiremos el concepto de correlación parcial para facilitar la interpretación de la \(PACF\).

Correlación Parcial

Consideremos tres variables aleatorias \(X, Y\) y \(Z\). Luego, tomemos en cuenta la regresión lineal simple de \(X\) sobre \(Z\) y \(Y\) sobre \(Z\) como dos ecuaciones separadas

\[ \hat{X}=a_{1}+b_{1}Z~\text{donde}~b_{1}=\frac{\text{Cov}(Z, X)}{\text{Var}(Z)} \]y

\[ \hat{Y}=a_{2}+b_{2}Z~\text{donde}~b_{2}=\frac{\text{Cov}(Z, Y)}{\text{Var}(Z)} \]Entonces, los errores pueden obtenerse a partir de

\[ X^{\star}=X-\hat{X}=X-(a_{1}+b_{1}Z) \]y

\[ Y^{\star}=Y-\hat{Y}=Y-(a_{2}+b_{2}Z) \]Entonces, la correlación parcial entre \(X\) e \(Y\) después de ajustar por \(Z\) se define como la correlación entre \(X^{\star}\) e \(Y^{\star}\); \(\text{Corr}(X^{\star}, Y^{\star})=\text{Corr}(X-\hat{X}, Y-\hat{Y})\).

Es decir, la correlación parcial se puede entender como la correlación entre dos variables después de ser ajustadas por un factor común que puede estar afectándolas. Por supuesto, es posible generalizar esto permitiendo el ajuste por más de un factor.

La Función de Autocorrelación Parcial (PACF), siguiendo la definición anterior, entre \(y_{t}\) y \(y_{t−k}\) es la autocorrelación entre \(y_{t}\) y \(y_{t−k}\) después de ajustar por \(y_{t−1}, y_{t−2},\dots, y_{t−k+1}\) y eliminar su influencia intermedia.

Es decir, PACF mide la correlación “pura” entre \(y_{t}\) y \(y_{t-k}\) ajustada por las correlaciones en todos los desfases menores. Por lo tanto, para un modelo \(AR(p)\) la \(PACF\) entre \(y_{t}\) y \(y_{t−k}\) para \(k > p\) debería ser igual a cero. Una definición más formal se puede encontrar a continuación.

Función de Autocorrelación Parcial: Considera un modelo de series temporales estacionario \(\{y_{t}\}_{t}\) que no necesariamente es un proceso AR. Además, considera, para cualquier valor fijo de \(k\), las Ecuaciones de Yule-Walker para la ACF de un proceso \(AR(p)\) dadas en la Ecuación (3.32) como

Equivalentemente

Estas son las conocidas ecuaciones de [Yule, 1927] [Walker, 1931]. Obtenemos estimaciones de los parámetros de Yule-Walker reemplazando las autocorrelaciones teóricas \(ρ_{k}\) por las autocorrelaciones estimadas \(r_{k}\). Nótese que, si escribimos

\[\begin{split} \boldsymbol{\phi}= \begin{pmatrix} \phi_{1k}\\ \phi_{2k}\\ \vdots\\ \phi_{kk} \end{pmatrix},~ \boldsymbol{\rho}_{k}= \begin{pmatrix} \rho(1)\\ \rho(2)\\ \vdots\\ \rho(k) \end{pmatrix},~ \boldsymbol{P}_{k}= \begin{pmatrix} 1 & \rho(1) & \rho(2) & \cdots & \rho(k-1)\\ \rho(1) & 1 & \rho(1) & \cdots & \rho(k-2)\\ \vdots & \vdots & \vdots & \cdots & \vdots\\ \rho(k-1) & \rho(k-2) & \rho(k-3) & \cdots & 1\\ \end{pmatrix} \end{split}\]la solución de (3.33) para los parámetros \(\boldsymbol{\phi}\) en términos de las autocorrelaciones pueden ser escritos como

\[ \boldsymbol{\phi}=\boldsymbol{P}_{k}^{-1}\boldsymbol{\rho}_{k}. \]

Propiedades de la Matriz de Autocorrelación y PACF

Definición Positiva: La matriz de autocorrelación \(\boldsymbol{P}_{k}\) es siempre una matriz semidefinida positiva. Esto se debe a que cualquier combinación lineal de las variables tendrá una varianza no negativa.Invertibilidad: La matriz de autocorrelación \(\boldsymbol{P}_{k}\) es invertible siempre y cuando las series de tiempo no tengan una dependencia lineal perfecta en los desfases considerados. En el contexto de un modelo \(AR(p)\), \(\boldsymbol{P}_{k}\) será invertible si el proceso subyacente es estacionario y las raíces del polinomio característico están fuera del círculo unitario.

Para cualquier valor dado de \(k,~k = 1, 2,\dots,\) el último coeficiente \(\phi_{kk}\) se llama la autocorrelación parcial del proceso en el rezago \(k\). Se observa que para un proceso \(AR(p),~\phi_{kk} = 0\) para \(k>p\).

Por lo tanto, decimos que la PACF se corta después del rezago \(p\) para un \(AR(p)\). Esto sugiere que la \(PACF\) se puede utilizar para identificar el orden de un proceso \(AR\) de manera similar a cómo se puede utilizar la \(ACF\) para un proceso \(MA\).

Autocorrelación Parcial Muestral \(\hat{\phi}_{kk}\)

Para cálculos de muestrales, \(\hat{\phi}_{kk}\), la estimación muestral de \(\phi_{kk}\), se obtiene utilizando la \(ACF\) muestral, \(r(k)\). Además, en una muestra de \(N\) observaciones de un proceso \(AR(p), \hat{\phi}_{kk}\) para \(k>p\) está aproximadamente distribuido normalmente con

Por lo tanto, los límites del 95% para juzgar si algún \(\hat{\phi}_{kk}\) es estadísticamente significativamente diferente de cero se dan por \(\pm 2/\sqrt{N}\) [Quenouille, 1949, Jenkins and others, 1956, Daniels, 1956].

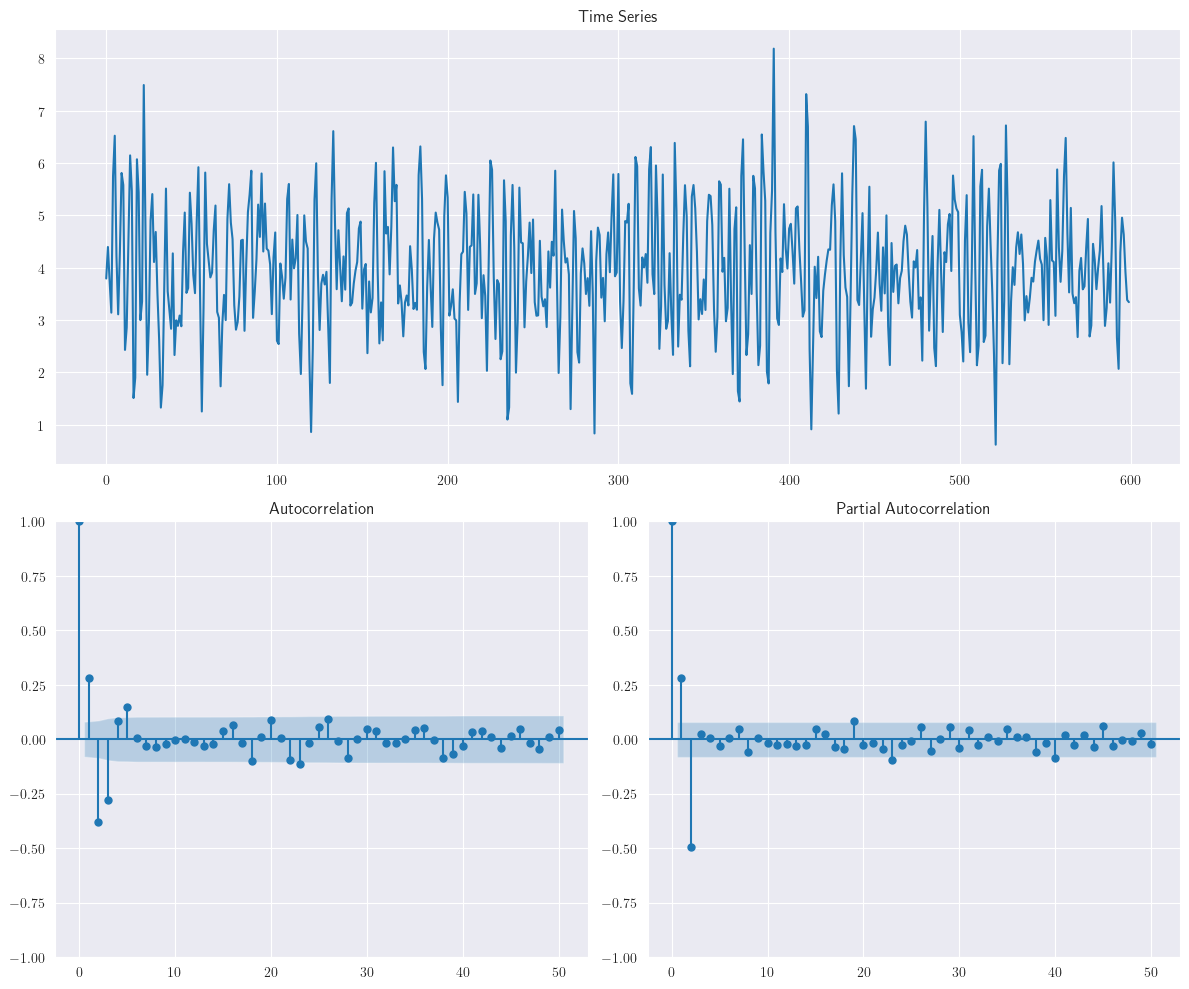

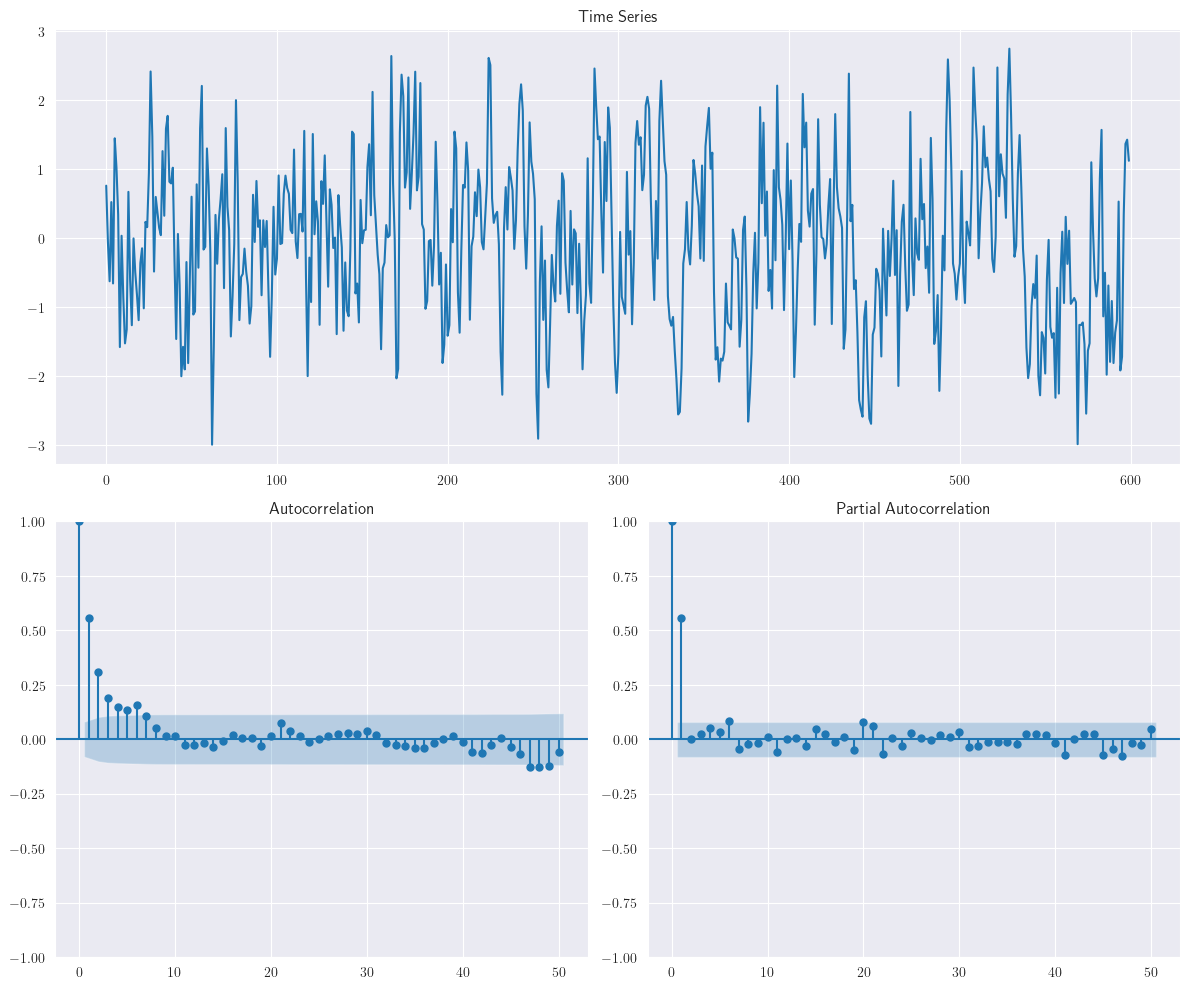

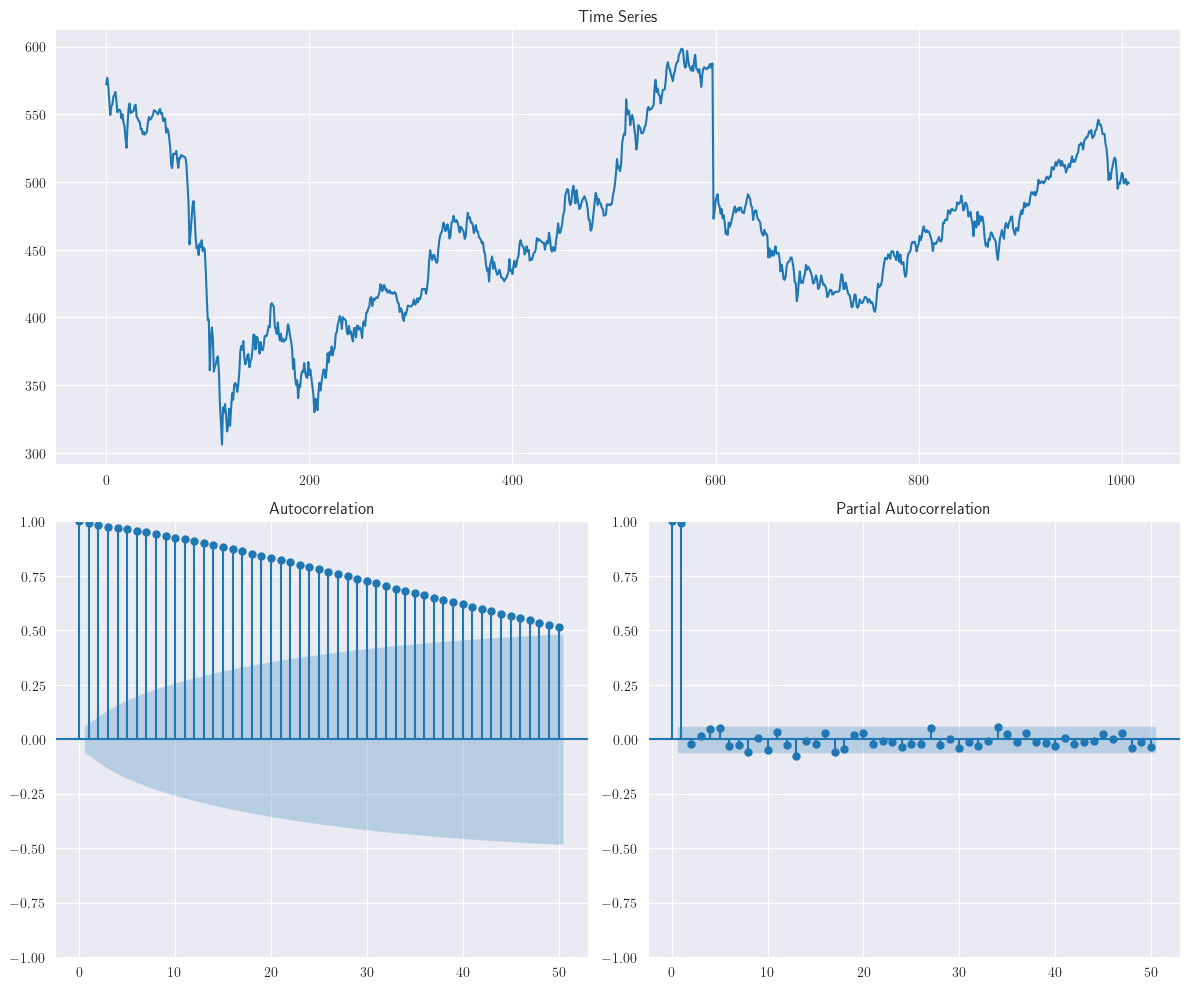

Nótese que en la siguiente figura, la cual representa el proceso

\[ AR(2):~y_{t}=4+0.8y_{t-1}-0.5y_{t-2}+\varepsilon_{t}, \]tenemos la \(PACF\) muestrales de las realizaciones del modelo \(AR(2)\). Observe que la \(PACF\) muestral se corta después del rezago 2.

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0.8, -0.5]) # phi1, phi2,...

maparams = np.array([0]) # theta1, theta2,...

intercept = 4

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

3.12. Procesos Mixtos Autorregresivos-Media Movil#

Introducción

Los modelos ARMA (Autoregressive Moving Average) combinan dos componentes principales: el modelo autorregresivo (AR), que captura la relación lineal entre una observación y un número lineal de observaciones pasadas, y el modelo de media móvil (MA), que modela la relación lineal entre una observación y los errores de predicción pasados.

Los modelos \(ARMA\) son ampliamente utilizados en el modelamiento y predicción de datos temporales en una variedad de campos, incluyendo la economía, las finanzas, la meteorología y la ingeniería, debido a su capacidad para capturar tanto la dependencia temporal como la variabilidad aleatoria.

Proceso \(ARMA(p, q)\)

En general, un modelo \(ARMA(p, q)\) se define como:

(3.34)#\[\begin{split} \begin{align*} y_{t} &= \delta+\phi_{1}y_{t-1}+\phi_{2}y_{t-2}+\cdots+\phi_{p}y_{t-p}+\varepsilon_{t}-\theta_{1}\varepsilon_{t-1}-\theta_{2}\varepsilon_{t-2}-\cdots-\theta_{q}\varepsilon_{t-q}\\ &= \delta + \sum_{i=1}^{p}\phi_{i}y_{t-i}+\varepsilon_{t}-\sum_{i=1}^{q}\theta_{i}\varepsilon_{t-i} \end{align*} \end{split}\]o

(3.35)#\[ \Phi(B)y_{t}=\delta+\Theta(B)\varepsilon_{t} \]donde \(\varepsilon_{t}\) es un proceso ruido blanco.

3.13. Estacionariedad del proceso \(ARMA(p, q)\)#

La estacionariedad de un proceso \(ARMA\) está relacionada con el componente \(AR\) en el modelo y puede verificarse a través de las raíces del polinomio asociado

(3.36)#\[ m^{p}-\phi_{1}m^{p-1}-\phi_{2}m^{p-2}-\cdots-\phi_{p}=0 \]

Si todas las raíces de la Ecuación (3.36) son menores que uno en valor absoluto, entonces el \(ARMA(p, q)\) es estacionario. Esto también implica que, bajo esta condición, el \(ARMA(p, q)\) tiene una representación MA infinita como

(3.37)#\[ y_{t}=\mu+\sum_{i=0}^{\infty}\psi_{i}\varepsilon_{t-i}=\mu+\Psi(B)\varepsilon_{t}, \]con \(\Psi(B)=\Phi(B)^{-1}\Phi(B)\). Los coeficientes en \(\Psi(B)\) pueden ser calculados usando

\[\begin{split} \psi_{i}-\phi_{1}\psi_{i-1}-\phi_{2}\psi_{i-2}-\cdots-\phi_{p}\psi_{i-p}= \begin{cases} -\theta_{i}, & i=1,2,\dots,q\\ 0, & i>q \end{cases} \end{split}\]y \(\psi_{0}=1\).

3.14. Invertibilidad del proceso \(ARMA(p, q)\)#

La invertibilidad de un proceso \(ARMA(p, q)\) está relacionada con el componente \(AR\) del modelo y puede verificarse a través de las raíces del polinomio asociado

\[ m^{q}-\theta_{1}m^{q-1}-\theta_{2}m^{q-2}-\cdots-\theta_{q}=0 \]

Si todas las raíces de la Ecuación (3.37) son menores que uno en valor absoluto, entonces se dice que el \(ARMA(p, q)\) es invertible y tiene una representación \(AR\) infinita

\[ \Pi(B)y_{t}= \alpha +\varepsilon_{t} \]donde \(\alpha=\Theta(B)^{-1}\delta\) y \(\Pi(B)=\Theta(B)^{-1}\Phi(B)\). Los coeficientes en \(\Pi(B)\) pueden ser calculados a partir de

\[\begin{split} \pi_{i}-\theta_{1}\pi_{i-1}-\theta_{2}\pi_{i-2}-\cdots-\theta_{q}\pi_{i-q}= \begin{cases} \phi_{i}, & i=1,2,\dots,p\\ 0, & i>p \end{cases} \end{split}\]y \(\pi_{0}=-1\).

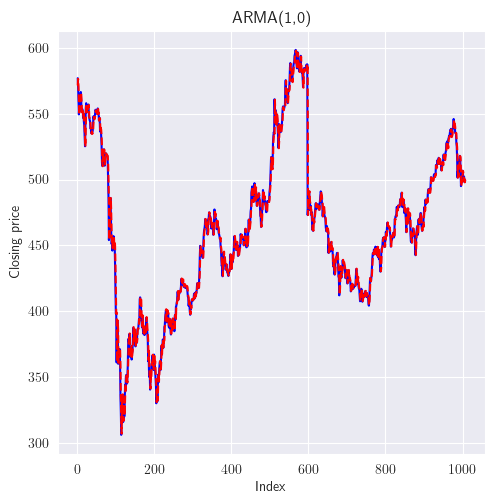

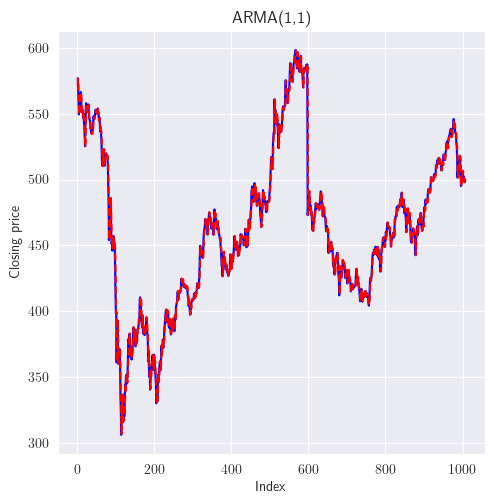

La siguiente figura muestra la ejercitación del proceso \(ARMA(1, 1)\)

\[ y_{t}=16+0.6y_{t-1}+\varepsilon_{t}+0.8\varepsilon_{t-1} \]

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([0.6]) # phi1, phi2,...

maparams = np.array([0.8]) # theta1, theta2,...

intercept = 16

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

Nótese que las funciones de autocorrelación y autocorrelación parcial de la muestra exhiben un comportamiento de decaimiento exponencial (a veces en valor absoluto dependiendo de los signos de los coeficientes \(AR\) y \(MA\)), como se muestra en el proceso \(ARMA(1, 1)\)

Show code cell source

np.random.seed(12345)

n=600

arparams = np.array([-0.7]) # phi1, phi2,...

maparams = np.array([-0.6]) # theta1, theta2,...

intercept = 16

ar = np.r_[1, -arparams] # add zero-lag and negative

ma = np.r_[1, maparams] # add zero-lag

ar1_data = intercept + smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

3.15. Funciones de autocorrelación (\(ACF\)) y autocorrelación parcial (\(PACF\)) del proceso \(ARMA(p, q)\)#

Las funciones de autocorrelación (ACF) y autocorrelación parcial (PACF) de un proceso ARMA son determinadas por las componentes AR y MA, respectivamente. Por lo tanto, tanto la ACF como la PACF de un \(ARMA(p, q)\) exhiben patrones de decaimiento exponencial y/o sinusoidales amortiguados, lo que dificulta relativamente la identificación del orden del modelo \(ARMA(p, q)\).

Para ello, se pueden utilizar funciones de muestra adicionales como la ACF de muestra extendida (ESACF), la PACF de muestra generalizada (GPACF), la ACF inversa (IACF) y correlaciones canónicas [Box et al., 2015, William and Wei, 2006, Tiao and Box, 1981, Tsay and Tiao, 1984, Ledolter and Abraham, 1984].

Sin embargo, la disponibilidad de librerías en

Pythonpermite al profesional considerar varios modelos con diferentes órdenes y compararlos según los criterios de selección de modelos como AIC, AICC y BIC. Los valores teóricos de la ACF y la PACF para series de tiempo estacionarias se resumen en la siguiente tabla.

Modelo |

ACF |

PACF |

|---|---|---|

\(MA(q)\) |

La \(ACF\) se corta después del rezago \(q\) |

Decaimiento exponencial y/o sinusoides amortiguadas |

\(AR(p)\) |

Decaimiento exponencial y/o sinusoides amortiguadas |

La \(PACF\) se corta después del rezago \(p\) |

\(ARMA(p, q)\) |

Decaimiento exponencial y/o sinusoides amortiguadas |

Decaimiento exponencial y/o sinusoides amortiguadas |

3.16. Procesos No Estacionarios#

Introducción

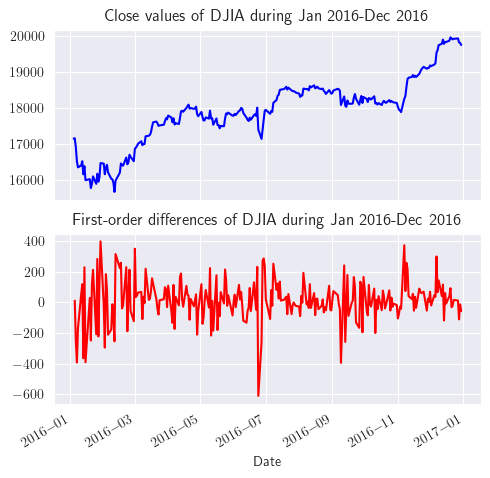

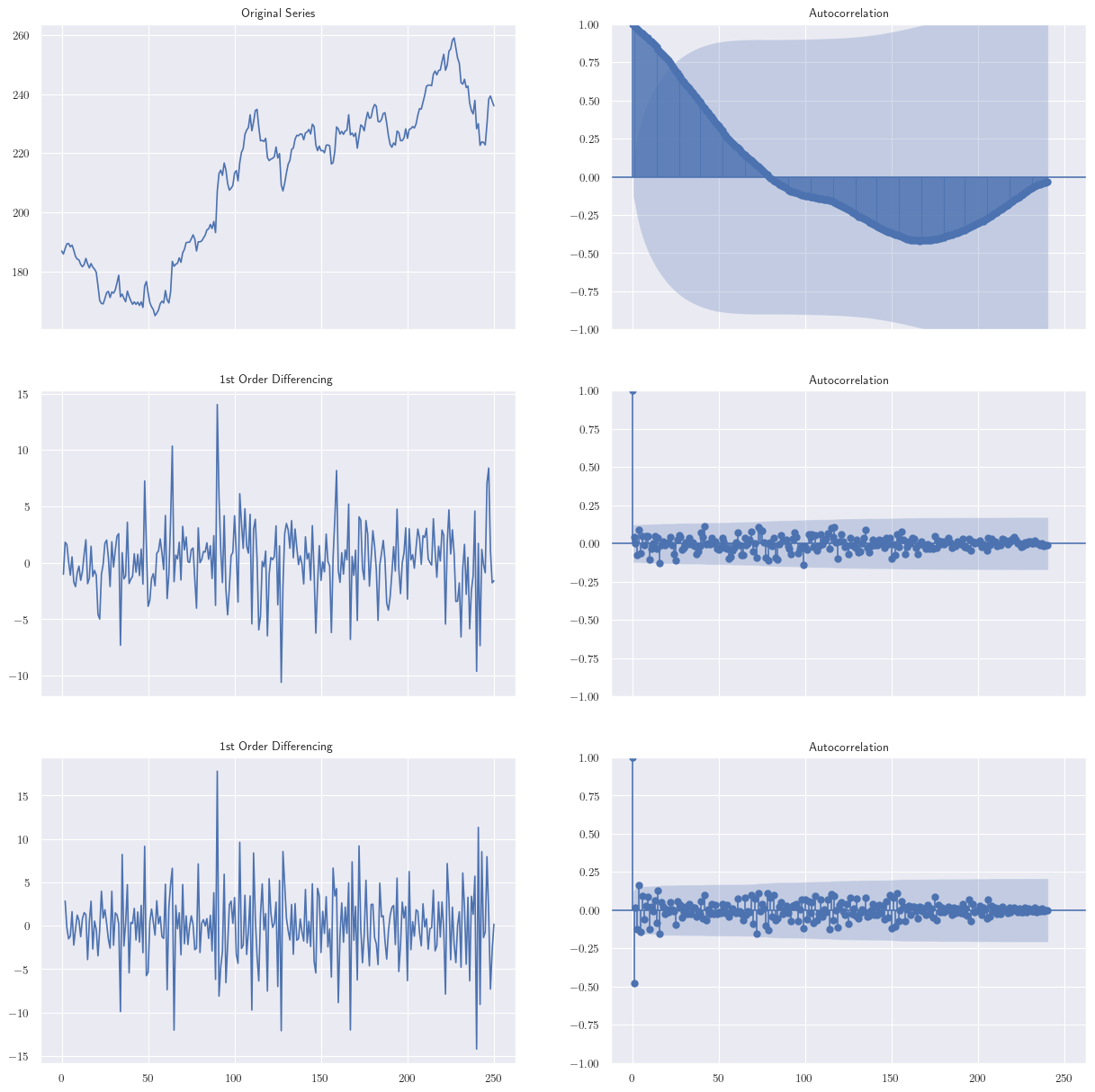

A menudo sucede que, aunque los procesos pueden no tener un nivel constante, exhiben un comportamiento homogéneo a lo largo del tiempo. Llamaremos a una serie de tiempo, \(y_{t}\), no estacionaria homogénea si no es estacionaria, pero su primera diferencia, es decir, \(w_{t} = y_{t} - y_{t-1} = (1 - B)y_{t}\), o diferencias de orden superior, \(w_{t} = (1 - B)^{d}y_{t}\), produce una serie de tiempo estacionaria.

Además, llamaremos a \(y_{t}\) un proceso autoregresivo integrado de media móvil (ARIMA) de órdenes \(p, d\) y \(q\), es decir, \(ARIMA(p, d, q)\), si su \(d\)-ésima diferencia, denotada por \(w_{t}= (1 - B)^{d}y_{t}\), produce un proceso \(ARMA(p, q)\) estacionario.

El término “integrado” se utiliza ya que, para \(d = 1\), por ejemplo, podemos escribir \(y_{t}\) como la suma (o “integral”) del proceso \(w_{t}\) como

Por lo tanto, un proceso \(ARIMA(p, d, q)\) puede ser escrito como

(3.38)#\[ \Phi(B)(1-B)^{d}y_{t}=\delta+\Phi(B)\varepsilon_{t} \]

Observación

Por lo tanto, una vez que se realiza la diferenciación y se obtiene una serie temporal estacionaria \(w_{t}=(1−B)^{d}y_{t}\), se pueden usar los métodos proporcionados en las secciones anteriores para obtener el modelo completo.

En la mayoría de las aplicaciones, la primera diferenciación (\(d = 1\)) y ocasionalmente la segunda diferenciación (\(d = 2\)) serían suficientes para lograr la estacionariedad. Sin embargo, a veces las transformaciones que no sean la diferenciación son útiles para reducir una serie temporal no estacionaria a una estacionaria.

Por ejemplo, en muchas series temporales económicas, la variabilidad de las observaciones aumenta a medida que aumenta el nivel promedio del proceso; sin embargo, el porcentaje de cambios en las observaciones es relativamente independiente del nivel. Por lo tanto, tomar el logaritmo de la serie original será útil para lograr la estacionariedad.

3.17. Construcción de Modelos de Series Temporales#

Introducción

Se utiliza un procedimiento iterativo de tres pasos para construir un modelo ARIMA. Primero, se identifica un modelo tentativo de la clase ARIMA mediante el análisis de datos históricos. Segundo, se estiman los parámetros desconocidos del modelo. Tercero, a través del análisis de residuos, se realizan controles diagnósticos para determinar la adecuación del modelo o indicar posibles mejoras. Discutiremos cada uno de estos pasos con más detalle.

3.18. Identificación de modelos#

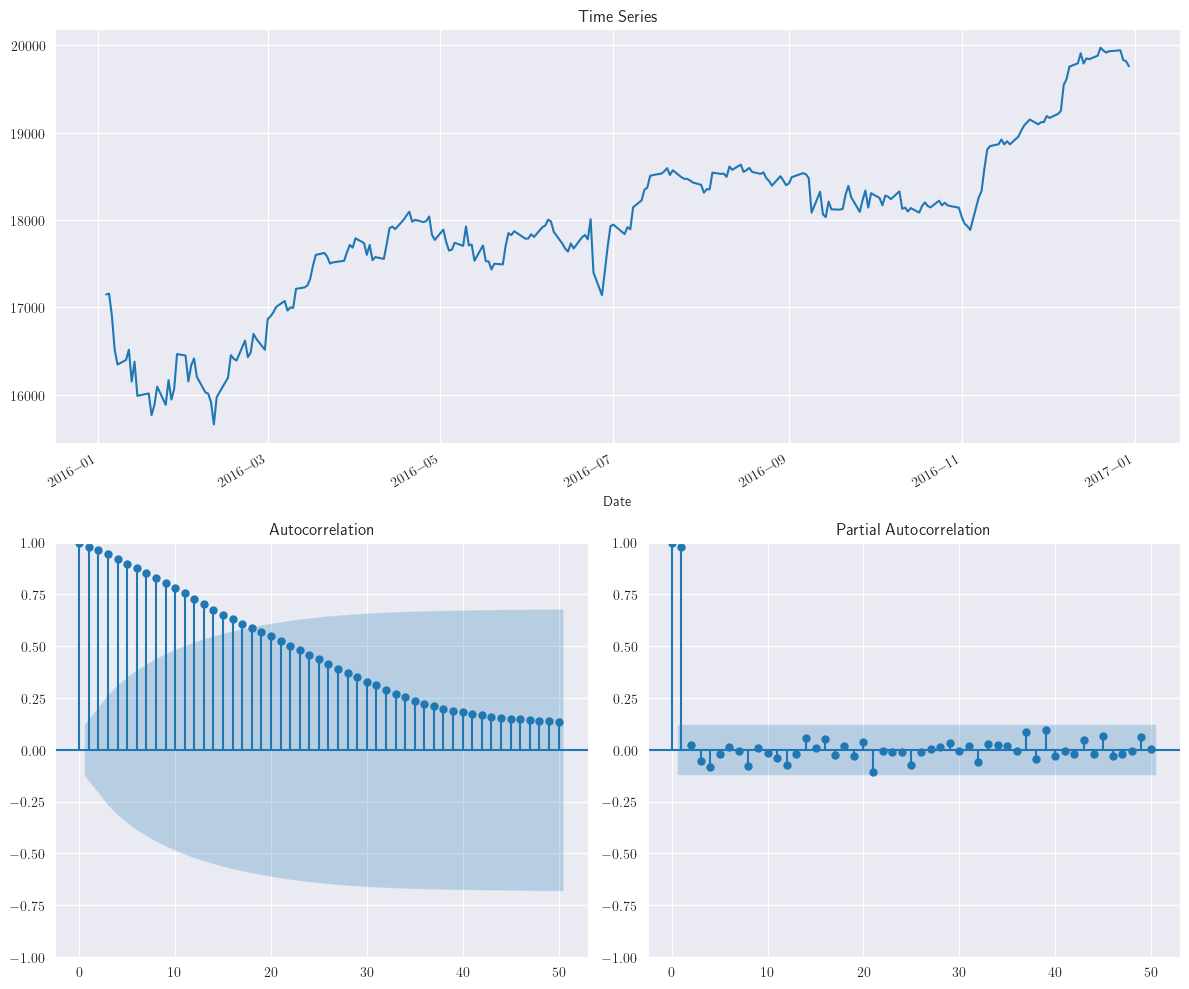

Antes de comenzar con esfuerzos rigurosos de construcción de modelos estadísticos, se recomienda el uso de gráficos descriptivos, como los gráficos de series temporales simples y los gráficos de dispersión de los datos de series temporales \(y_{t}\) vs \(y_{t−1}, y_{t−2},\dots,\).

Si se sospecha de no estacionariedad, también se debe considerar el gráfico de la primera (o \(d\)-ésima) diferencia. La prueba de raíz unitaria [Dickey and Fuller, 1979] también se puede realizar para asegurarse de que se necesite realmente la diferenciación.

Una vez que se puede asumir la estacionariedad de la serie temporal, se deben obtener la ACF y PACF muestral de la serie temporal original (o su \(d\)-ésima diferencia si es necesario). Dependiendo de la naturaleza de la autocorrelación, las primeras 20–25 autocorrelaciones y autocorrelaciones parciales muestrales deberían ser suficientes.

La Tabla Comportamiento de las ACF, PACF teóricas para procesos estacionarios junto con los límtes \(\pm2/\sqrt{N}\) pueden ser usados como una guía para identificar modelos \(AR\) y \(MA\). La identificación va a requerir mayor cuidado dado que, \(ACF\) y \(PACF\) van a presentar decaimiento exponencial y comportamiento sinusoidal amortiguado.

Existen varios métodos, como el método de momentos, método de máxima verosimilitud y mínimos cuadrados que pueden ser utilizados para estimar los parámetros en el posible modelo identificado. Sin embargo, a diferencia de los problemas de regresión, muchos modelos ARIMA son no lineales y van a requerir del uso de procedimientos no lineales para el ajuste de modelos. Debe escoger el modelo mas adecuado ofrecido por la librería utilizada.

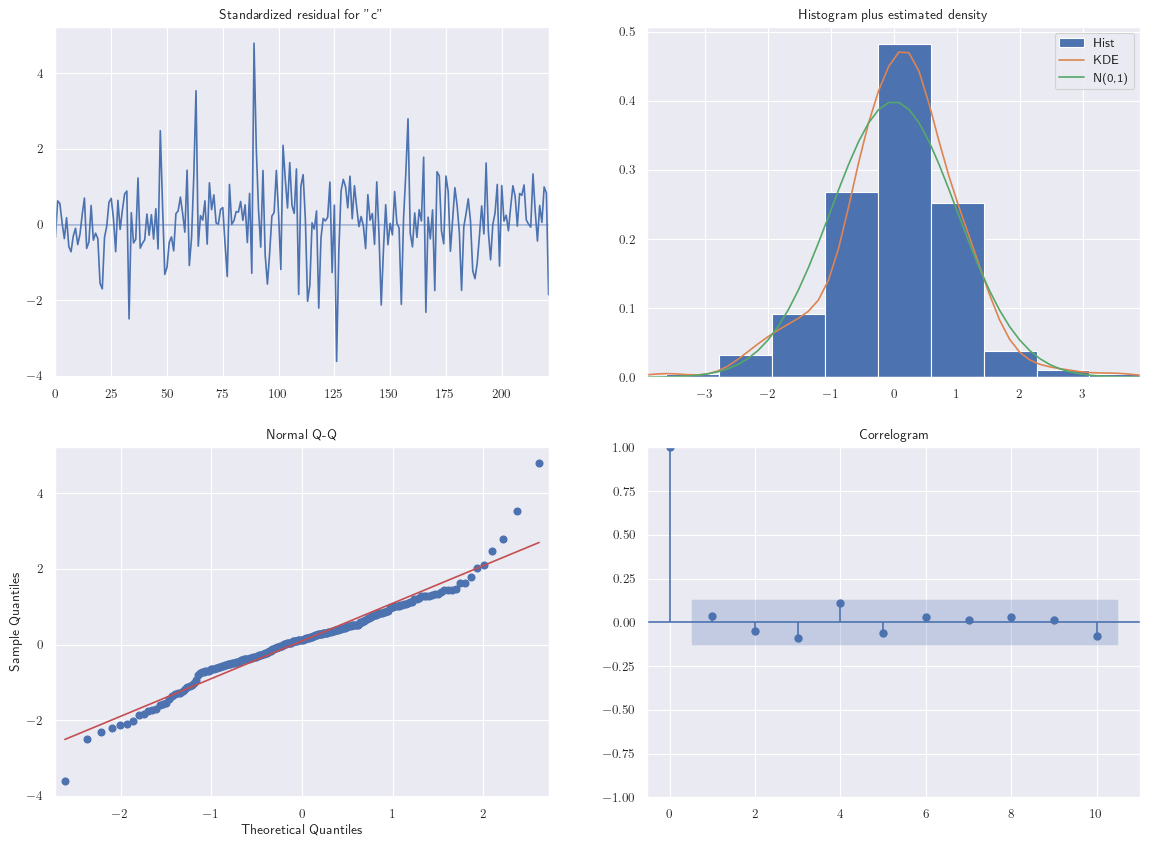

3.19. Diagnostico Checking#

Despues que un posible modelo ha sido ajustado a los datos, debemos examinar si es adecuado, y si es necesario, sugerir mejoras potenciales. Esto puede ser realizado a traves del análisis de residuales.

Los residuales para un proceso \(ARMA(p, q)\) puden ser obtenidos a partir de

(3.39)#\[ \hat{\varepsilon}_{t}=y_{t}-\left(\hat{\delta}+\sum_{i=1}^{p}\hat{\phi}_{i}y_{t-i}-\sum_{i=1}^{q}\hat{\theta_{i}}\hat{\varepsilon}_{t-i}\right) \]

Si el modelo especificado es adecuado, y por lo tanto los ordenes aproximados \(p\) y \(q\) son identificados, este debería transformar las observaciones a un proceso ruido blanco. Esto es, el comportamiento de los residuales en la Ecuación (3.39) debería ser ruido blanco.

Denotemos la función de autocorrelación muestral de los residuales por \(\{r_{e}(k)\}\). Si el modelo es apropiado, la función de autocorrelación muestral de los residuos no debería tener una estructura a identificar. Esto es, la autocorrelación no debería diferir significativamente de cero para todos los lags mayores que uno. Si conocemos los verdaderos valores de los parámetros y la forma del modelo es correcta, los errores estándar de los residuos de autocorrelación serían \(N^{-1/2}\).

Indicador chi-cuadrado

Además de considerar los términos individuales \(r_{e}(k)\), podemos obtener vía test chi-cuadrado un indicador de si los primeros \(K\) autocorrelaciones residuales unidas, indican que el modelo es adecuado. El tes estadístico es

\[ Q=(N-d)\sum_{k=1}^{K}r_{e}^{2}(k) \]la cual es distribuida aproximadamente como chi-cuadrado con \(K-p-q\) grados de libertad si el modelo es apropiado. Si el modelo es inadecuado, \(Q\) excede un punto, en la pequeña cola superior aproximada, de la distribución chi-cuadrado con \(K-p-q\) grados de libertad.

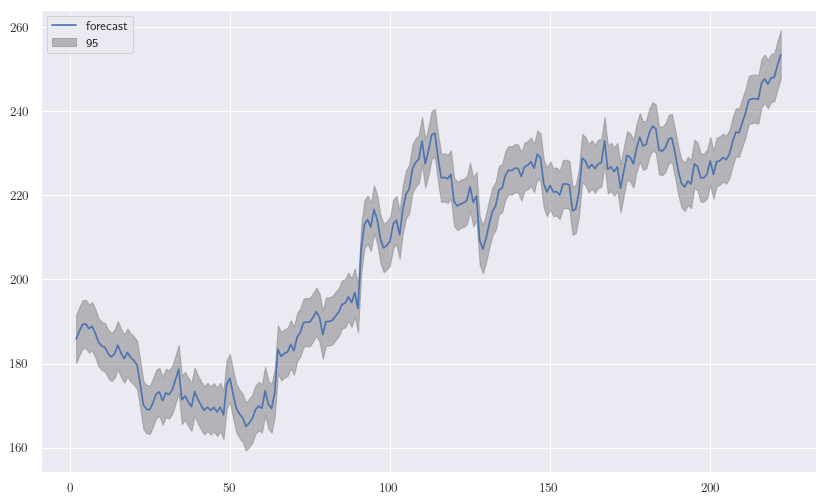

3.20. Pronóstico con proceso ARIMA#

Introducción

Una vez una serie de tiempo apropiada ha sido ajustada, esta púede ser usada para generar pronósticos de futuras observaciones. Si denotamos el tiempo actual por \(T\), la predicción \(y_{T+\tau}\) es llamada, pronóstico \(\tau\)-period-ahead y lo denotamos por \(\hat{y}_{T+\tau}(T)\).

El criterio estándar a utilizar para obtener la mejor predicción es el error cuadrático medio, para el que el valor esperado de los errores predichos al cuadrado

\[ \text{E}[(y_{T+\tau}-\hat{y}_{T+\tau}(T))^{2}]=\text{E}[e_{T}(\tau)^{2}] \]es minimizado.

Puede demostrarse que el mejor ponóstico en el sentido cuadrático medio es la esperanza condicional de \(y_{T+\tau}\) dada la actual y previas observaciones, esto es, \(y_{T}, y_{T-1}, y_{T-2},\dots\)

\[ \hat{y}_{T+\tau}(T)=\text{E}[y_{T+\tau} | y_{T}, y_{T-1},\dots] \]

Considere por ejemplo un proceso \(ARIMA(p, d, q)\) en el tiempo \(T+\tau\) (i.e periodo \(\tau\) en el futuro)

\[ y_{T+\tau}=\delta+\sum_{i=1}^{p+d}\phi_{i}y_{T+\tau-i}+\varepsilon_{T+\tau}-\sum_{i=1}^{q}\theta_{i}\varepsilon_{T+\tau-i}. \]

Además, considere su representación infinita \(MA\)

(3.40)#\[ y_{T+\tau}=\mu+\sum_{i=0}^{\infty}\psi_{i}\varepsilon_{T+\tau-i} \]

Podemos particionar la Ecuación (3.40) como

\[ y_{T+\tau}=\mu+\sum_{i=0}^{\tau-1}\psi_{i}\varepsilon_{T+\tau-i}+\sum_{i=\tau}^{\infty}\psi_{i}\varepsilon_{T+\tau-i} \]

En esta partición se puede ver claramente que la componente \(\sum_{i=0}^{\tau-1}\psi_{i}\varepsilon_{T+\tau-i}\) involucra los errores futuros, mientras que la componente \(\sum_{i=\tau}^{\infty}\psi_{i}\varepsilon_{T+\tau-i}\) involucra el error presente y los pasados.

Dada la relación entre la actual y pasadas observaciones, y el supuesto de que los random shocks tienen media cero y son independientes, el mejor pronostico en el sentido cuadratico medio es

\[\begin{split} \begin{align*} \hat{y}_{T+\tau}(T) &= \text{E}[y_{T+\tau} | y_{T}, y_{T-1},\dots]\\[3mm] &= \text{E}\left[\mu+\sum_{i=0}^{\tau-1}\psi_{i}\varepsilon_{T+\tau-i}+\sum_{i=\tau}^{\infty}\psi_{i}\varepsilon_{T+\tau-i}\right]\\ &= \mu+\sum_{i=0}^{\tau-1}\psi_{i}\text{E}[\varepsilon_{T+\tau-i} | y_{T}, y_{T-1},\dots]+\sum_{i=\tau}^{\infty}\psi_{i}\text{E}[\varepsilon_{T+\tau-i} | y_{T}, y_{T-1},\dots]\\[1mm] &= \mu+\sum_{i=\tau}^{\infty}\psi_{i}\varepsilon_{T+\tau-i},~\text{E}[\varepsilon_{T+\tau-i} | y_{T}, y_{T-1},\dots]= \begin{cases} 0 & \text{si}~i<\tau\\ \varepsilon_{T+\tau-i} & \text{si}~i\geq\tau. \end{cases} \end{align*} \end{split}\]

Seguidamente, el error del pronóstico es calculado a partir de

(3.41)#\[ e_{T}(\tau)=y_{T+\tau}-\hat{y}_{T+\tau}(T)=\sum_{i=0}^{\tau-1}\psi_{i}\varepsilon_{T+\tau-i} \]

Dado que el error de pronóstico en la Ecuación (3.41) es una combinación lineal de random shocks, tenemos que

\[\begin{split} \begin{align*} \text{E}[e_{T}(\tau)] &= 0\\ \text{Var}[e_{T}(\tau)] &= \text{Var}\left[\sum_{i=0}^{\tau-1}\psi_{i}\varepsilon_{T+\tau-i}\right]\\ &= \sum_{i=0}^{\tau-1}\psi_{i}^{2}\text{Var}(\varepsilon_{T+\tau-i})\\ &= \sigma^{2}\sum_{i=0}^{\tau-1}\psi_{i}^{2}\\[2mm] &= \sigma^{2}(\tau),~\tau=1,2,\dots \end{align*} \end{split}\]

3.21. Implementación#

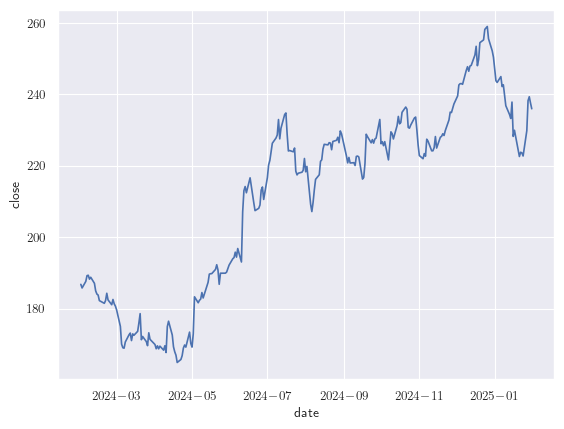

Estudiemos implicaciones de los modelos de componentes \(AR\). El conjunto de datos

AR(1)puede ser generado utilizando la funciónarma_generate_sampledel módulostatsmodels.tsa

import pandas as pd

import numpy as np

from matplotlib import pyplot as plt

from statsmodels.graphics.tsaplots import plot_acf, plot_pacf

import statsmodels.tsa.api as smtsa

import statsmodels.tsa.arima.model as arima_model

import warnings

warnings.filterwarnings("ignore")

n = 600

ar = np.r_[1, -0.6]

ma = np.r_[1, 0]

ar1_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

El script anterior genera un conjunto de datos para el escenario \(AR(1)\) con correlación serial definida para el retardo anterior como 0.6. El componente \(MA\) se fija en cero para eliminar cualquier efecto de media móvil de la señal de la serie temporal.

Considere el siguiente modelo \(y_{t}=\phi_{1}y_{t-1}+\varepsilon_{t}\). Los datos son simulados usando componentes autoregresivas menores que 1, por lo tanto, la autocorrelación decrecerá sobre el tiempo siguiendo la relación entre \(\phi\) y \(t\)

Por lo tanto, el gráfico ACF decrece exponencialmente y la PACF remueve el efecto de rezago mientras calcula correlación, solo términos significativos son capturados. El valor de \(\phi\) afecta la estacionariedad de la señal. Por ejemplo, si aumentamos el valor de \(\phi\) de 0.6 a 0.95 en \(AR(1)\), el modelo tiende a la no estacionariedad, como se muestra en el siguiente ejemplo:

ar = np.r_[1, -0.95]

ma = np.r_[1, 0]

ar1_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

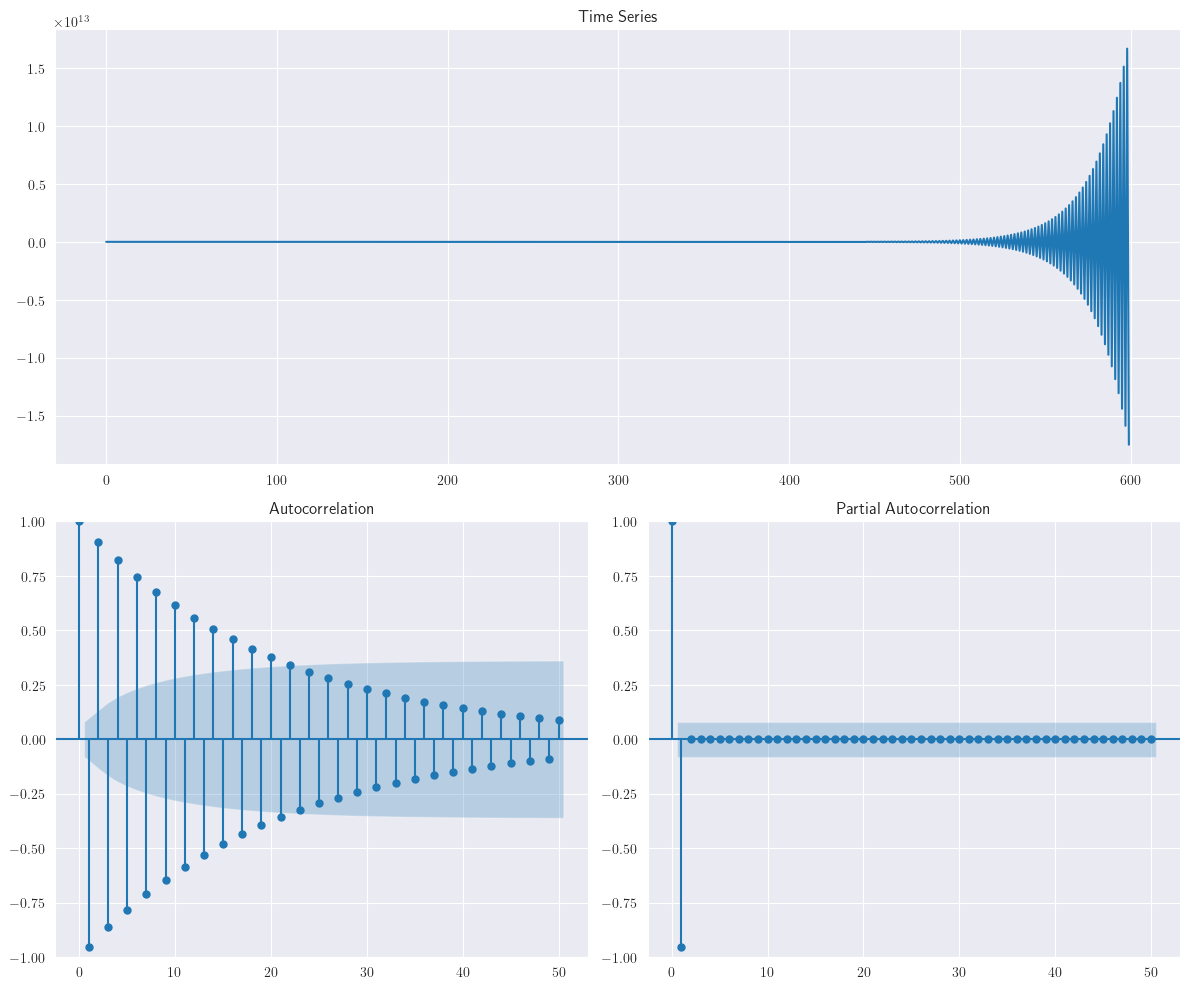

En el escenario en que \(\phi>1\), el modelo se convierte en no estacionario. Un ejemplo de proceso no estacionario con \(\phi>1\) lo podemos ver a continuación, considerando \(\phi=1.01\)

ar = np.r_[1, -1.01]

ma = np.r_[1, 0]

ar1_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1_data)

Similarmente, modelos autorregresivos de alto orden, pueden ser generados para validar efecto sobre los componentes de la PACF con el orden. Los conjuntos de datos con componentes \(AR(2)\) y \(AR(3)\) son generados utilizando el siguiente script

ar = np.r_[1, 0.6, 0.7]

ma = np.r_[1, 0]

ar2_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar2_data)

ar = np.r_[1, 0.6, 0.7, 0.5]

ma = np.r_[1, 0]

ar3_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar3_data)

Como se puede ver, a partir de diferentes fuentes de datos, la PACF está capturando la componente autorregresiva y \(q\) es el valor donde esta es significativa.

El modelo para \(AR(3)\) puede ser evaluado usando la clase

ARIMA.fitdel módulo dePython,statsmodels.tsa.api(ver statsmodels.tsa.arima.model.ARIMA).Si ajustamos un modelo \(AR(3)\) sobre los datos generados con \(AR\), las correlaciones de 0.6, 0.7 y 0.5 se pueden visualizar (aproximadas vía MLE) en el siguiente

summary(). Nótese que son parecidos a la relación real obtenida en el ejemplo anterior usandosmtsa.arma_generate_sample

ar3 = arima_model.ARIMA(ar3_data.tolist(), order=(3, 0, 0)).fit()

ar3.summary()

| Dep. Variable: | y | No. Observations: | 600 |

|---|---|---|---|

| Model: | ARIMA(3, 0, 0) | Log Likelihood | -847.763 |

| Date: | Fri, 31 Jan 2025 | AIC | 1705.527 |

| Time: | 21:42:05 | BIC | 1727.512 |

| Sample: | 0 | HQIC | 1714.085 |

| - 600 | |||

| Covariance Type: | opg |

| coef | std err | z | P>|z| | [0.025 | 0.975] | |

|---|---|---|---|---|---|---|

| const | 0.0028 | 0.014 | 0.198 | 0.843 | -0.025 | 0.030 |

| ar.L1 | -0.6479 | 0.034 | -18.891 | 0.000 | -0.715 | -0.581 |

| ar.L2 | -0.7168 | 0.030 | -23.592 | 0.000 | -0.776 | -0.657 |

| ar.L3 | -0.5454 | 0.034 | -16.194 | 0.000 | -0.611 | -0.479 |

| sigma2 | 0.9852 | 0.057 | 17.270 | 0.000 | 0.873 | 1.097 |

| Ljung-Box (L1) (Q): | 0.71 | Jarque-Bera (JB): | 1.04 |

|---|---|---|---|

| Prob(Q): | 0.40 | Prob(JB): | 0.59 |

| Heteroskedasticity (H): | 0.94 | Skew: | -0.10 |

| Prob(H) (two-sided): | 0.68 | Kurtosis: | 3.00 |

Warnings:

[1] Covariance matrix calculated using the outer product of gradients (complex-step).

summary() Output

En el presente resumen,

Covariance Type: opgcorresponde a la estimación por producto exterior de gradientes Outer-Product-of-Gradients (OPG) para la matriz de covarianza asociada a las estimaciones de coeficientes del modelo.El

AIC, BIC, HQICutilizan la estimación de máxima verosimilitud (Log Likelihood) de un modelo como medida de ajuste. Los valores deAIC, BIC, HQICson bajos para los modelos con Log Likelihood altos. Esto significa que el modelo se ajusta mejor a los datos, que es lo que queremos. Por ejemplo,AICse define de la siguiente forma: \(AIC=2k-2\ln(L)\), donde \(k\) es el número de parámetros en el modelo estadístico, y \(L\) es el máximo valor de la función de verosimilitud para el modelo estimado.Al ajustar modelos, es posible aumentar la verosimilitud añadiendo parámetros, pero hacerlo puede dar lugar a un sobreajuste. Tanto el BIC como el AIC intentan resolver este problema introduciendo un término de penalización por el número de parámetros del modelo; el término de penalización es mayor en el

BICque en elAICpara tamaños de muestra superiores a 7.BICestá definido como \(BIC=k\ln(n)-2\ln(L)\), donde aquí \(n\) representa el tamaño de la muestra. El criterio de información de Hannan–Quinn (HQIC) está dado por \(HQIC=2k\ln(\ln(n))-2\ln(L)\). Este criterio reduce la penalización deBIC, de tal forma que en términos de penalización se ubica entreAICyBIC. La selección del criterio va a depender del objetivo principal del investigador.Los coeficientes del modelo autorregresivo son

ar.L1, ar.L2, ar.L3. El valor deconstes equivalente al intercepto en modelos de regresión lineal ysigma2es la varianza estimada del residuo en el modelo. La columnaP>|z|corresponde al \(p\)-value.std erres el error estándar asociado a cada coeficiente, para los cuales el intervalo de confianza aparece en la última columna[0.025, 0.075].Para determinar si la asociación entre la respuesta y cada término del modelo es estadísticamente significativa, comparamos el \(p\)-value del término con su nivel de significancia para evaluar la hipótesis nula.

La hipótesis nula es que el término no es significativamente diferente de 0, lo que indica que no existe asociación entre el término y la respuesta. Nótese que los coeficientes:ar.L1, ar.L2, ar.L3, son estadísticamente significativos. Cuando un coeficiente no es estadísticamente significativo, es posible que desee volver a ajustar el modelo sin el término asociado.El siguiente paso es determinar si el modelo cumple el supuesto del análisis. Utilizamos el estadístico chi-cuadrado de Ljung-Box (Ljung-Box (L1) (Q)), el \(p\)-value asociado

Prob(Q)y la función de autocorrelación de los residuos para determinar si el modelo cumple el supuesto de que los residuos son independientes. Si no se cumple el supuesto, es posible que el modelo no se ajuste correctamente a los datos y debe tener cuidado al interpretar los resultados. En este caso lahipótesis nula es que los residuos son independientes o que no hay correlación en los residuales. Nótese que el \(p\)-value es mayor o igual que 0.05, y está representado porProb(Q).Por otro lado, Jarque-Bera (JB) es un test de normalidad, en este caso para los residuales. La hipótesis nula a contrastar es que los

residuales están normalmente distribuidos. Nótese también que en este caso el \(p\)-value (Prob(JB)) es mayor al nivel de significancia. El sesgo y la curtosisSkew, Kurtosismuestran un sesgo negativo en los residuales y una distribuciónleptocúrticacon mayor concentración de los datos en torno a la media.El valor

Heteroskedasticity (H)es el estadístico asociado con el test de heterocedasticidad de los residuos estandarizados con \(p\)-valueProb(H) (two-sided). Lahipótesis nula es, los residuos no presentan heteroscedasticidad. Nótese que el \(p\)-value es mayor o igual que 0.05, y está representado porProb(H) (two-sided).

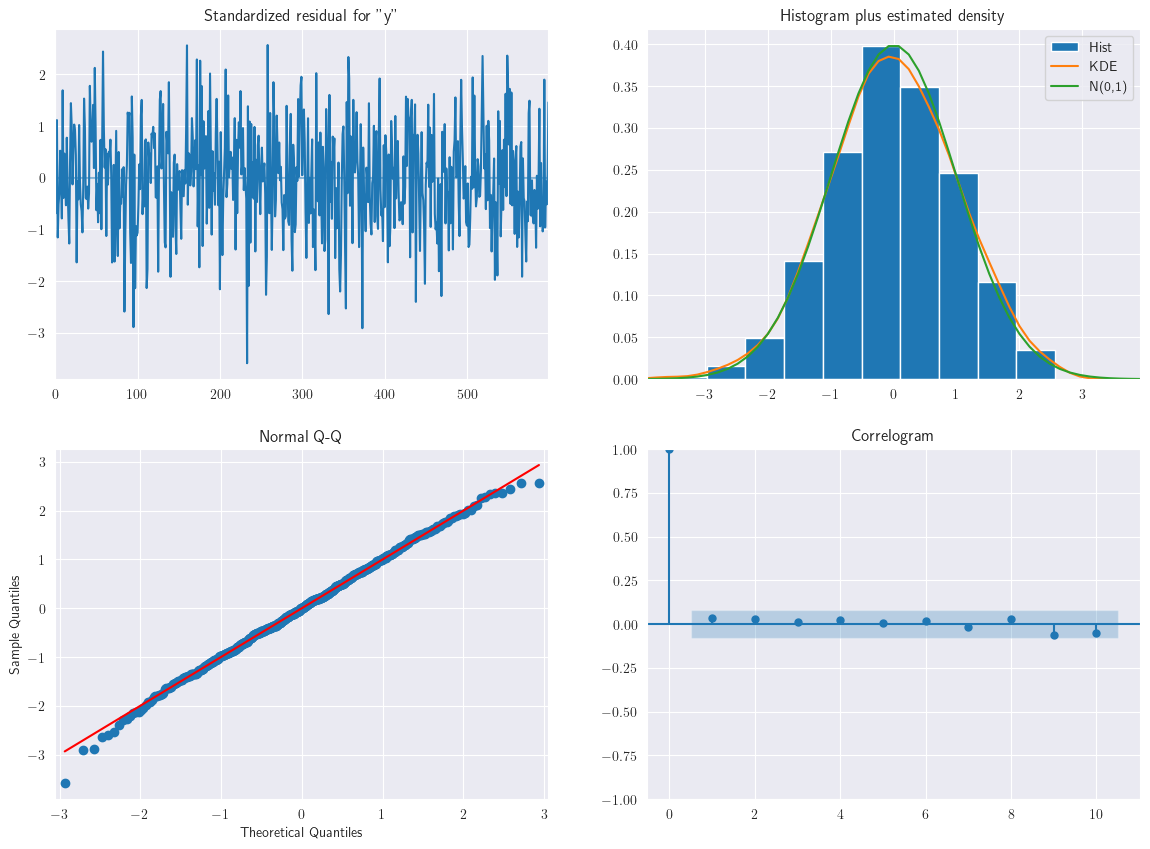

ar3.plot_diagnostics(figsize=(14,10));

Nótese que en la ACF no hay correlaciones significativas, puede concluir que los residuos son independientes. Esto es, ninguna de las correlaciones de la función de autocorrelación de los residuos es significativa. Se puede concluir que el modelo cumple el supuesto de que los residuos son independientes.

Tanto \(AR\) como \(MA\) pueden utilizarse para corregir la dependencia serial, pero normalmente la autocorrelación positiva se corrige utilizando modelos \(AR\) y la dependencia negativa se corrige utilizando modelos \(MA\).

3.22. Modelos de media móvil#

Observación (Cross Validated)

¿Por qué molestarse en tomar alguna parte de un ruido blanco anterior \(\theta_{1}\varepsilon_{t-1}\) para la estimación del siguiente paso temporal, sabiendo que los términos de ruido blanco no están relacionados a lo largo del tiempo?

Ejemplo: Si un huracán azota Houston, va a haber un impacto en las ventas de, digamos, Target. Desde un alto nivel, esto es un gran valor negativo de \(\varepsilon_{t}\) para esa semana. La semana siguiente, habrá otra innovación semanal, \(\varepsilon_{t+1}\) pero es posible que el efecto del huracán no haya desaparecido del todo en el límite de la semana, por lo que habrá algún efecto de arrastre sobre las ventas, dado por la innovación de la semana anterior.

¿Por qué la varianza de los términos de innovación se mantiene constante dado que se esperaría que en realidad varíara con el tiempo?

Ejemplo: Incluso si varía, mientras no varíe por mucho, probablemente sea mejor simplemente modelarlo como una constante en lugar de tratar de estimarlo como un término variable. Por ejemplo, la demanda minorista de plátanos es bastante estable a lo largo del año, excepto en Navidad, cuando es más baja, pero fluctúa de forma errática semana a semana, a nivel de tienda. No podemos predecir exactamente cuál será la demanda la próxima semana, así que modelamos esa imprecisión como ruido blanco.

Para ilustrar un modelo de serie temporal de media móvil, generemos una señal utilizando el siguiente código

import statsmodels.tsa.api as smtsa

Número de muestras

n = 600

Generamos un conjunto de datos para \(MA(1)\)

ar = np.r_[1, 0]

ma = np.r_[1, 0.7]

ma1_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ma1_data)

En el script anterior, \(n\) representa el número de muestras que se generarán con \(AR\) que define el componente autorregresivo y \(MA\) que explica el componente de media móvil de la señal de la serie temporal. Por ahora, mantendremos el impacto de \(AR\) en la señal de la serie temporal como cero. Este script generará un conjunto de datos de series temporales con una dependencia \(MA(1)\) y 0.7 de correlación serial con el error y puede ser representado como como sigue:

Para evaluar si la señal de la serie temporal consta de un componente \(MA\) o \(AR\), se utiliza la autocorrelación (ACF) y la autocorrelación parcial (PACF) respectivamente.

El

ACFdel conjunto de datos anterior muestra una dependencia de 1 rezago. Como la relación \(MA\) es capturada usando \(y_{t} = \theta\varepsilon_{t-1} + \varepsilon_{t}\), que es independiente de los términos de rezago, el ACF tiende a capturar el orden \(q\) apropiado de la serie \(MA\).Como puede observarse en la siguiente siguiente figura, la ACF no llega a cero después del orden definido, sino que se reduce a un valor pequeño. El intervalo de confianza se comprueba utilizando la relación \(\pm 2/\sqrt{N}\), donde \(1/\sqrt{N}\) representan una aproximación de la desviación estándar, que se cumple bajo la condición de independencia.

Veamos el impacto del componente \(MA\) de

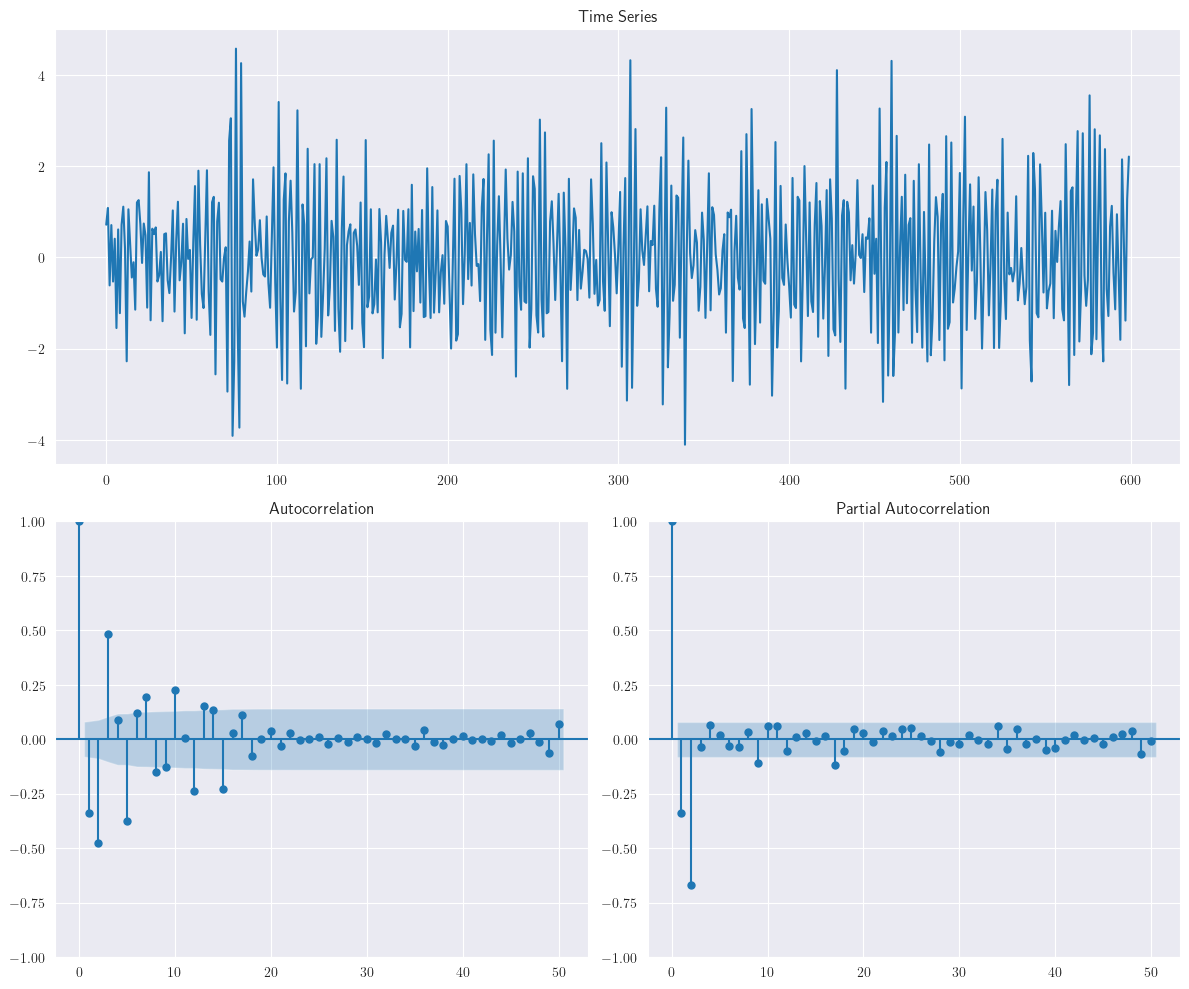

ACFyPACFcon un orden mayor de \(q\) utilizando el siguiente script, el cual generará series de tiempo de medias moviles de ordenes \(MA(2)\) y \(MA(3)\) sin impacto del componente autorregresivo. Además se generan, las funcionesACFyPACF, como en los anteriores ejemplos

ar = np.r_[1, 0]

ma = np.r_[1, 0.6, 0.7]

ma2_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ma2_data)

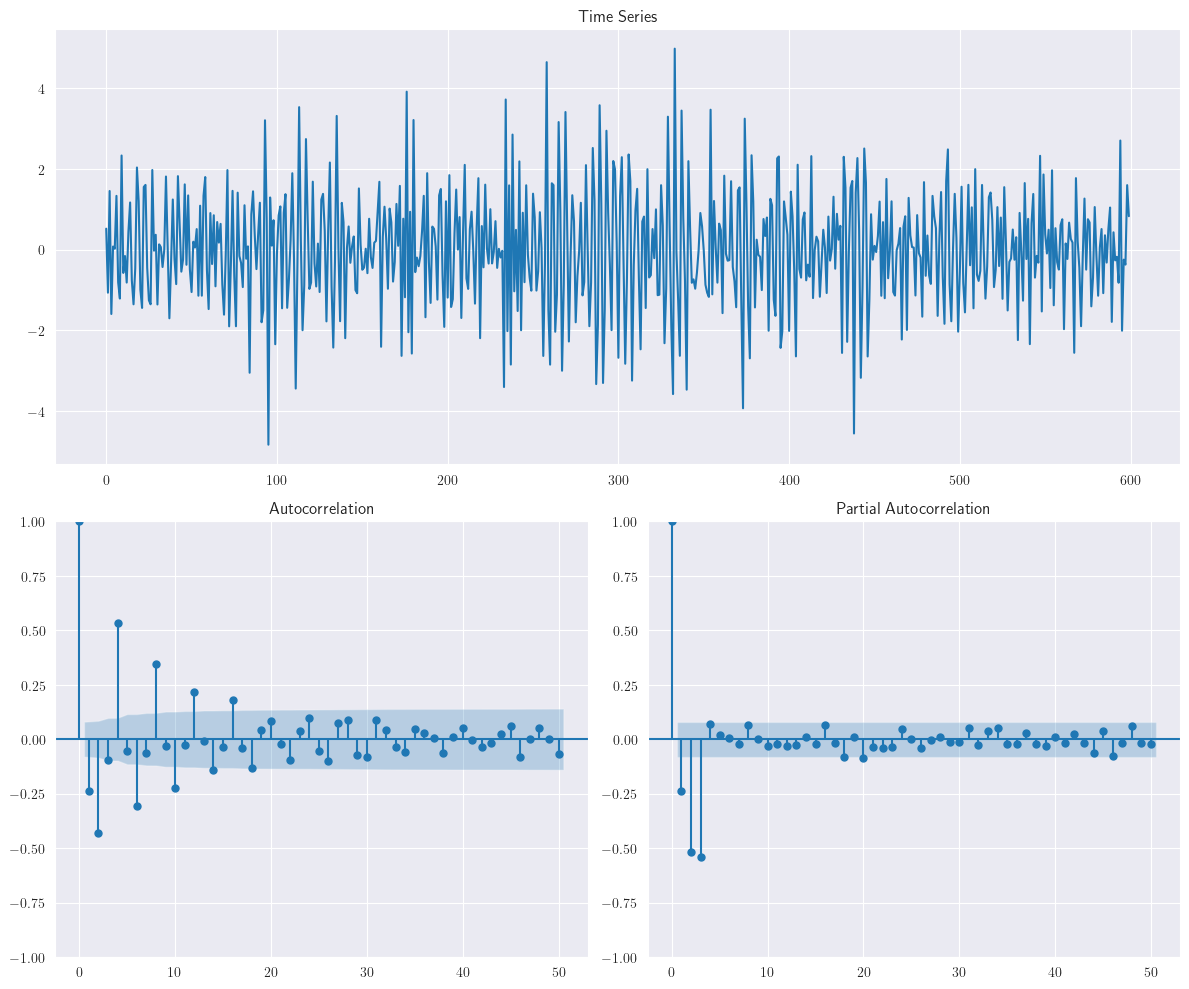

ar = np.r_[1, 0]

ma = np.r_[1, 0.6, 0.7, 0.5]

ma3_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ma3_data)

Normalmente, la ACF define bien la correlación serial del error y, por tanto, se utiliza para detectar \(MA(q)\); sin embargo, a medida que aumenta el orden y entran en escena otros componentes de la serie temporal, como la estacionalidad, tendencia o estacionariedad, la interpretación se complica. El \(MA(q)\) supone que el proceso es estacionario y que el error es un ruido blanco para garantizar una estimación insesgada.

Se puede construir un modelo \(MA(q)\) utilizando la función

ARIMAdel módulostatsmodel.tsa. Nótese que usamos siempre cero en la segunda componente de la función ARIMA, en la siguiente sección explicaremos el por qué de esto, al introducir el concepto de diferenciación. Un script de ejemplo para ajustar un modelo \(MA(1)\) es el siguiente

ma1 = smtsa.ARIMA(ma1_data.tolist(), order=(0, 0, 1)).fit()

Como el orden de \(AR\) se mantiene en cero,

smtsa.ARIMAconstruye un \(MA(1)\). El resumen del modelo devuelto porsmtsa.ARMAse muestra aquí

ma1.summary()

| Dep. Variable: | y | No. Observations: | 600 |

|---|---|---|---|

| Model: | ARIMA(0, 0, 1) | Log Likelihood | -842.209 |

| Date: | Fri, 31 Jan 2025 | AIC | 1690.418 |

| Time: | 21:42:07 | BIC | 1703.609 |

| Sample: | 0 | HQIC | 1695.553 |

| - 600 | |||

| Covariance Type: | opg |

| coef | std err | z | P>|z| | [0.025 | 0.975] | |

|---|---|---|---|---|---|---|

| const | 0.0114 | 0.067 | 0.170 | 0.865 | -0.121 | 0.143 |

| ma.L1 | 0.6789 | 0.031 | 22.252 | 0.000 | 0.619 | 0.739 |

| sigma2 | 0.9689 | 0.055 | 17.504 | 0.000 | 0.860 | 1.077 |

| Ljung-Box (L1) (Q): | 0.18 | Jarque-Bera (JB): | 0.40 |

|---|---|---|---|

| Prob(Q): | 0.67 | Prob(JB): | 0.82 |

| Heteroskedasticity (H): | 0.92 | Skew: | 0.06 |

| Prob(H) (two-sided): | 0.54 | Kurtosis: | 3.05 |

Warnings:

[1] Covariance matrix calculated using the outer product of gradients (complex-step).

Queda como ejercicio para el estudiante interpretar cada summary() basado en el análisis realizado para los modelos AR. Como puede verse, el modelo ha captado una correlación entre los residuos, que es bastante cercano al valor simulado de 0.7. Del mismo modo, ejecutamos el modelo para el conjunto de datos \(MA(3)\) y el resultado se muestra a continuación

ma3 = smtsa.ARIMA(ma3_data.tolist(), order=(0, 0, 3)).fit()

ma3.summary()

| Dep. Variable: | y | No. Observations: | 600 |

|---|---|---|---|

| Model: | ARIMA(0, 0, 3) | Log Likelihood | -852.803 |

| Date: | Fri, 31 Jan 2025 | AIC | 1715.606 |

| Time: | 21:42:07 | BIC | 1737.591 |

| Sample: | 0 | HQIC | 1724.165 |

| - 600 | |||

| Covariance Type: | opg |

| coef | std err | z | P>|z| | [0.025 | 0.975] | |

|---|---|---|---|---|---|---|

| const | 0.0530 | 0.119 | 0.445 | 0.656 | -0.180 | 0.286 |

| ma.L1 | 0.6478 | 0.038 | 16.834 | 0.000 | 0.572 | 0.723 |

| ma.L2 | 0.6936 | 0.034 | 20.646 | 0.000 | 0.628 | 0.759 |

| ma.L3 | 0.5455 | 0.038 | 14.367 | 0.000 | 0.471 | 0.620 |

| sigma2 | 1.0020 | 0.058 | 17.254 | 0.000 | 0.888 | 1.116 |

| Ljung-Box (L1) (Q): | 0.01 | Jarque-Bera (JB): | 0.52 |

|---|---|---|---|

| Prob(Q): | 0.93 | Prob(JB): | 0.77 |

| Heteroskedasticity (H): | 0.93 | Skew: | -0.07 |

| Prob(H) (two-sided): | 0.63 | Kurtosis: | 3.01 |

Warnings:

[1] Covariance matrix calculated using the outer product of gradients (complex-step).

Nótese también que el modelo ha captado correlaciones entre los residuos, que están bastante cercanas a los valores simulados 0.6, 0.7 y 0.5.

3.23. Creación de conjuntos de datos con ARIMA#

Las dos secciones anteriores describen el modelo autorregresivo \(AR(p)\), que realiza una regresión sobre sus propios términos rezagados y el modelo de media móvil \(MA(q)\) construye una función en términos de errores pasados. Los modelos \(AR(p)\) tienden a captar el efecto de reversión a la media (mean reversion), mientras que los modelos \(MA(q)\) tienden a captar el efecto de choque en el error, que no son normales o imprevistos. La reversión a la media es un término financiero para la suposición de que el precio de un activo tenderá a converger al precio promedio a lo largo del tiempo. Así pues, el modelo \(ARMA\) combina la potencia de los componentes \(AR\) y \(MA\). Un modelo de previsión de series temporales \(ARMA(p, q)\) incorpora el modelo \(AR\) de orden \(p\) y el modelo \(MA\) de orden \(q\), respectivamente.

Vamos a generar un conjunto de datos \(ARMA(1,1)\) actualizando el script utilizado anteriormente con componentes

ARyMAactualizados. También restringiremos el número de muestras a 600 para simplificar:

n = 600

ar = np.r_[1, 0.6]

ma = np.r_[1, 0.3]

ar1ma1_data = smtsa.arma_generate_sample(ar=ar, ma=ma, nsample=n)

plotds(ar1ma1_data)

Podemos utilizar el test de Dickey Fuller, considerando como hipótesis nula \(H_{0}\): la serie de tiempo no es estacionaria. Como es usual, este tipo de tests entrega un \(p\)-value en el cual basamos la decisión de aceptar o rechazar la hipótesis inicial, con una significancia \(\alpha\) de 0.05. Esto puede ser llevado a cabo usando la función

adfuller()destattools.

from statsmodels.tsa import stattools

adf_result = stattools.adfuller(ar1ma1_data, autolag='AIC')

print('p-value of the ADF test in air miles flown:', adf_result[1])

p-value of the ADF test in air miles flown: 4.896647961106425e-29

La palabra clave argumento

autolag='AIC'indica a la función que el número de rezagos se elija para minimizar el criterio de información correspondiente.

Observación

Los procesos de ventas en general siguen un modelo \(ARMA(1,1)\), ya que las ventas en el tiempo \(t\) son función de las ventas anteriores que se produjeron en el tiempo \(t-1\), que interviene en el componente \(AR\). El componente \(MA\) de \(ARMA(1,1)\) se debe a las campañas temporales lanzadas por la empresa, como la distribución de cupones.

La distribución de cupones, por ejemplo, provocará un efecto de media móvil en el proceso. Las ventas aumentan temporalmente y el cambio en el efecto de las ventas es captado por el componente de media móvil. En la figura anterior, tanto

ACFcomoPACFmuestran una curva senoidal con una fuerte correlación en los rezagos iniciales; por lo tanto, los parámetros \(p\) como \(q\) están presentes.

En los datos de series temporales \(ARMA(1,1)\), tanto

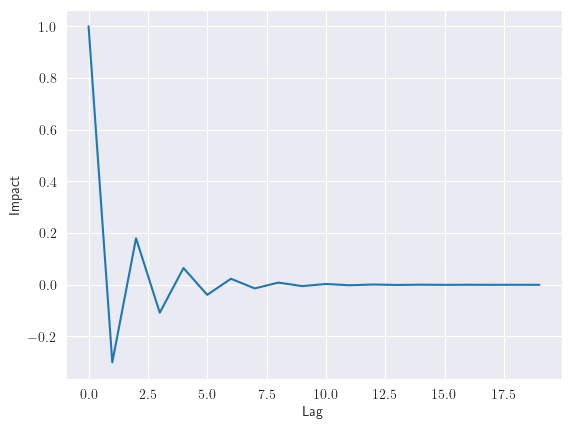

ACFcomoPACFhan mostrado un patrón de onda senoidal, \(p\) y \(q\) afectan a la señal de la serie temporal. El impacto de los retardos puede calcularse mediante la curva impulso-respuesta (ver statsmodels.tsa.arima_process.arma_impulse_response), como se muestra en la siguiente figura, para la señal de serie temporal \(ARMA(1,1)\). La figura muestra que, tras cinco retardos, el efecto sobre la respuesta es mínimo

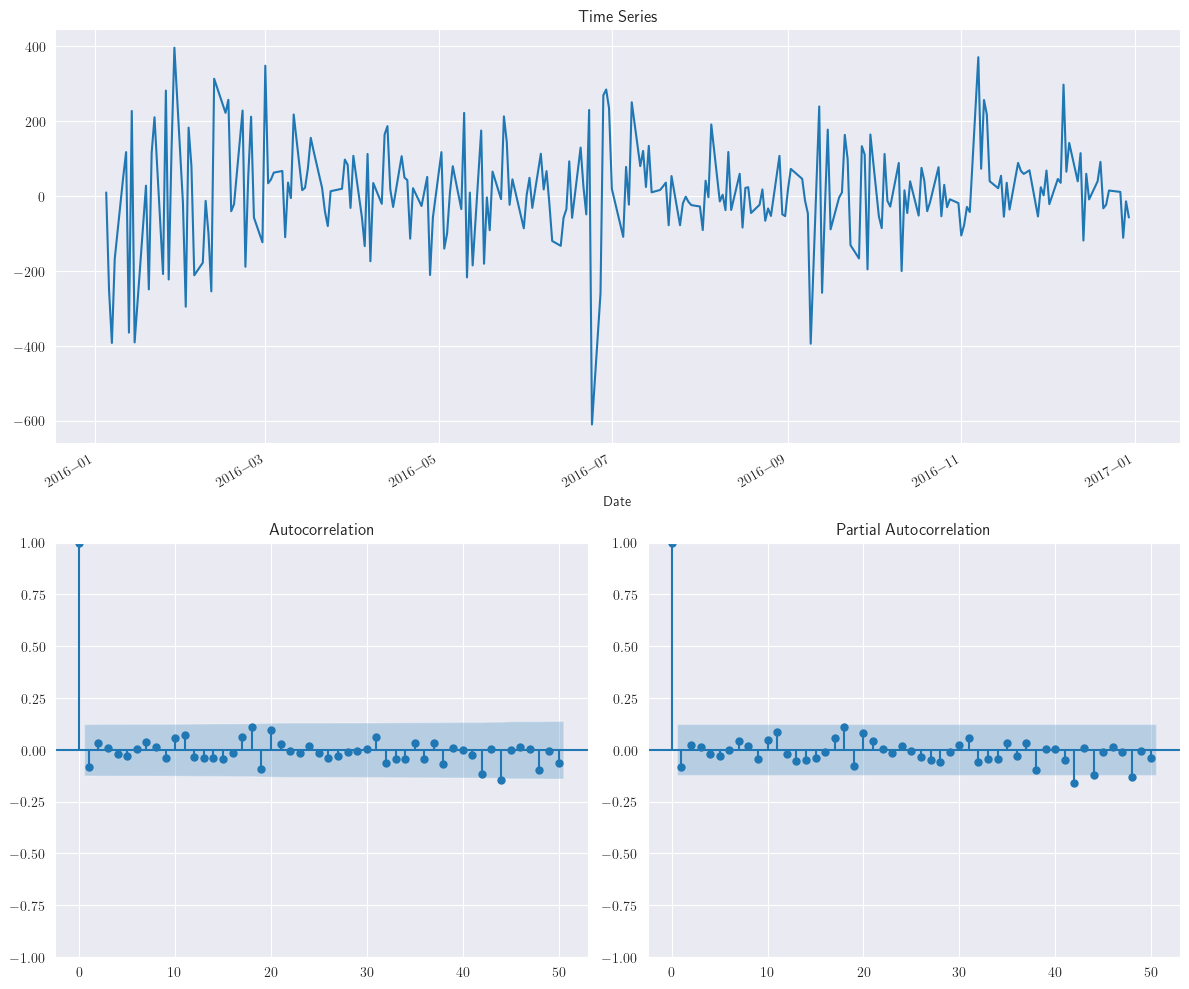

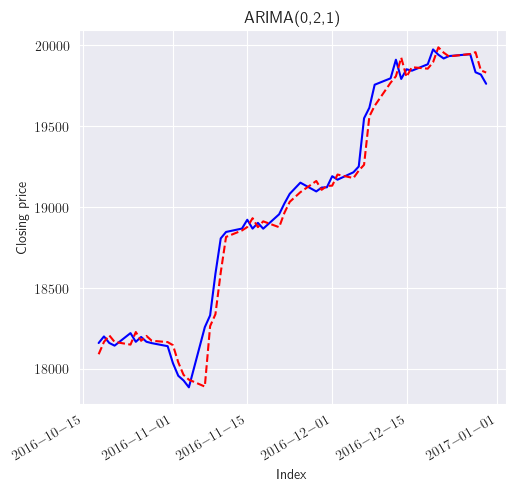

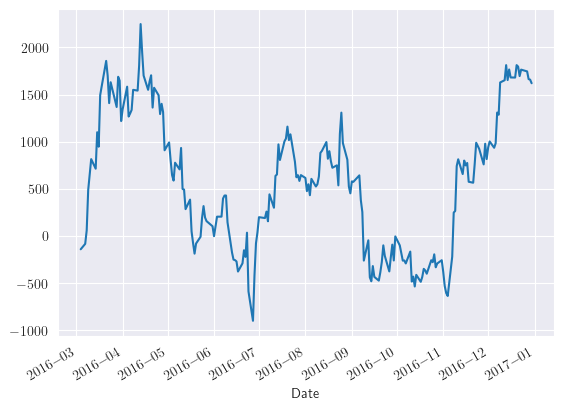

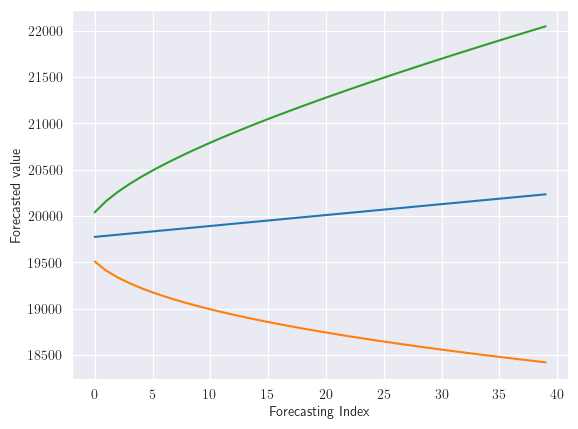

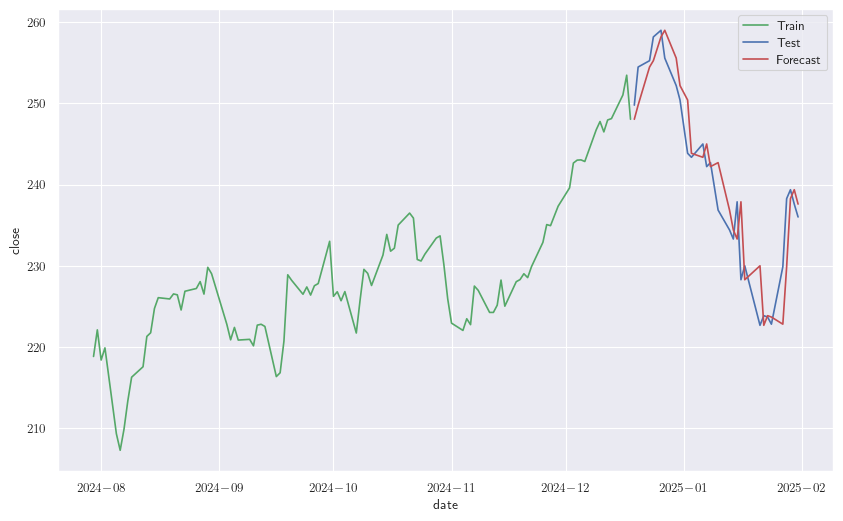

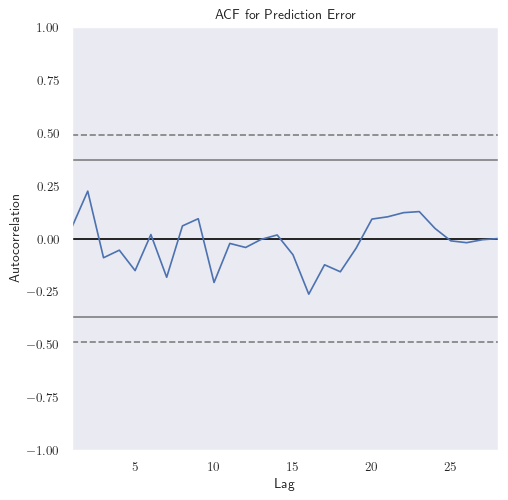

Observación